Новый стандарт оценки моделей понимания языка: MMLU-Pro

Недавние достижения в области больших языковых моделей (LLM) значительно изменили область обработки естественного языка (NLP), но их производительность на существующих показателях начала замедляться. Это затрудняет различие в возможностях моделей, затрудняя прогресс в исследованиях ИИ. Новый стандарт оценки MMLU-Pro представляет собой значительное улучшение в оценке способностей моделей понимания языка, преодолевая критические проблемы в оценке моделей.

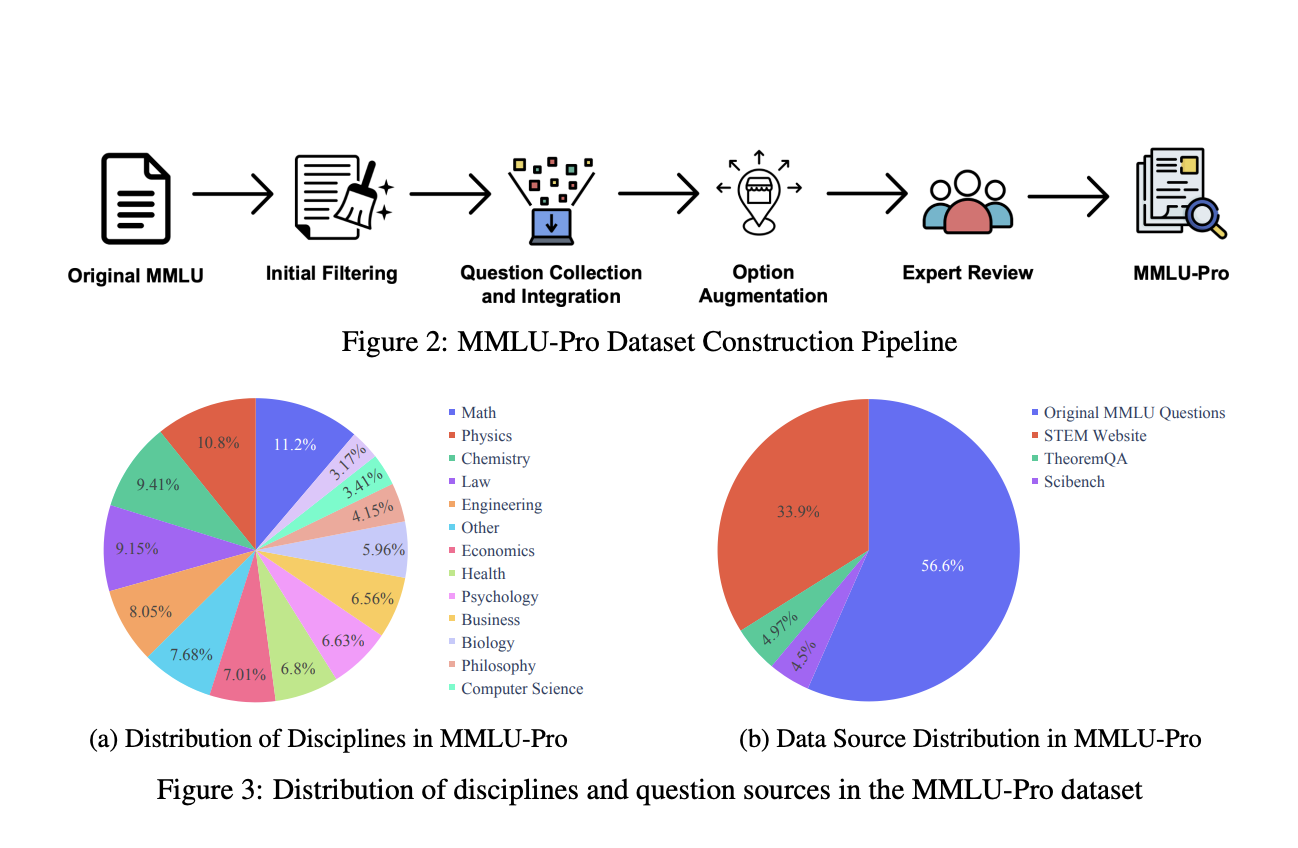

Практические решения и ценность MMLU-Pro

MMLU-Pro предлагает более сложные, требующие рассуждений задачи и увеличивает количество вариантов ответов, что значительно повышает его надежность и дискриминационную силу. Оценки показывают, что даже топовые модели сталкиваются с существенными вызовами на MMLU-Pro, что подтверждает его эффективность в расширении возможностей ИИ. Этот стандарт оценки готов играть ключевую роль в будущем развитии и оценке LLM, стимулируя прогресс в исследованиях ИИ.