Методика SMEAR для масштабирования MoE-архитектур

Методика SMEAR, представленная недавно, представляет собой полностью недифференцируемую и эффективную архитектуру MoE. Она позволяет эффективно масштабировать MoE-модели и эффективно сливать экспертов в пространстве параметров. Эта методика демонстрирует отличные результаты на задачах языкового моделирования и дополнительных задачах.

Основные преимущества методики SMEAR:

- Эффективность и сходимость обучения: Методика SMEAR достигает уровня потерь, эквивалентного менее чем половине обучающих токенов для моделей с различным количеством параметров, что говорит о более высокой производительности при таких же ресурсах обучения.

- Языковое моделирование: Модели MoE превосходят плотные базовые модели во всех областях, снижая перплексию. Например, по сравнению с плотной моделью объемом 0,3B, модели объемом 0,3B/32E демонстрируют относительное улучшение на 13,9% в категории «Книги».

- Дополнительные задачи: Модели объемом 0,3B/32E показывают увеличение производительности на 3,7% в задачах здравого смысла, на 3,3% в задачах чтения с пониманием, на 1,5% в задачах классификации и на 11,1% в задачах текстовой классификации.

Архитектура Lory для предварительного обучения языковых моделей

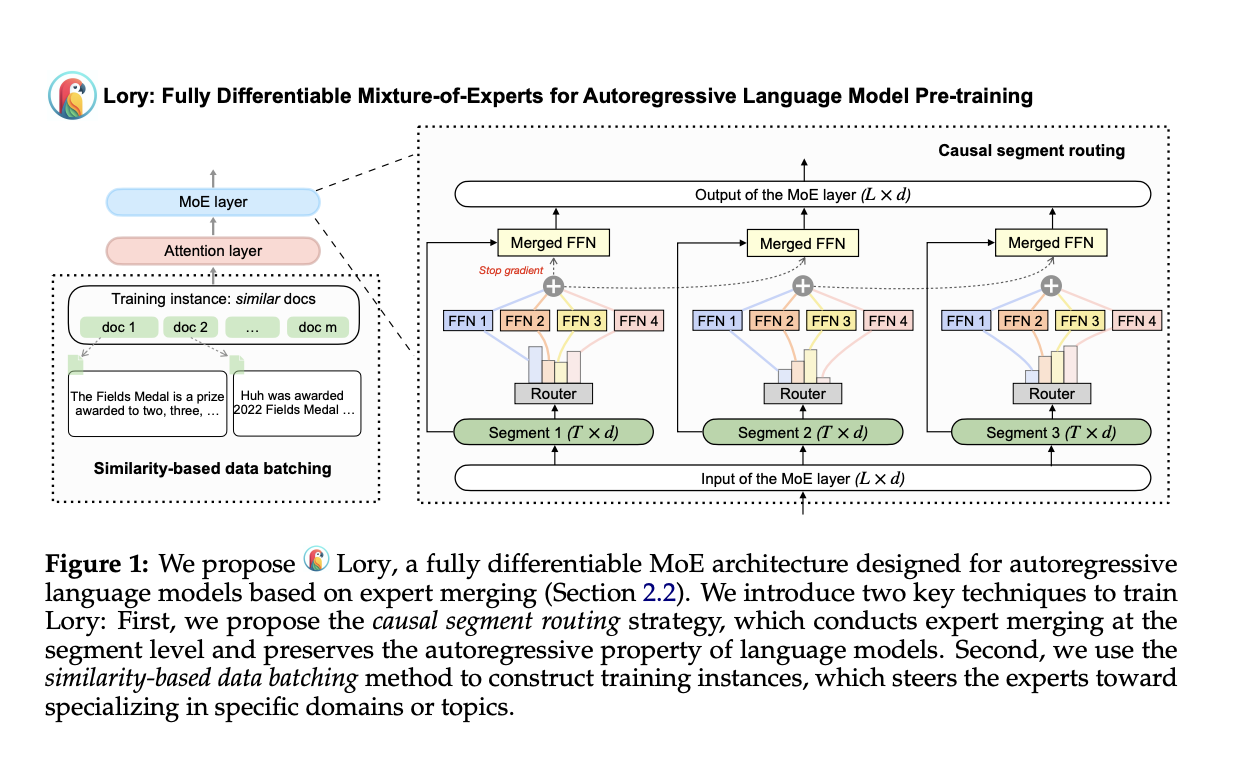

Методика Lory, разработанная исследователями из Принстонского университета и Meta AI, представляет собой полностью дифференцируемую MoE-модель, предназначенную для предварительного обучения языковых моделей. Она состоит из двух основных методик: стратегии каскадной маршрутизации сегментов и метода формирования данных на основе сходства, что позволяет максимально эффективно обучать MoE и получать высокоспециализированные эксперты.

Основные преимущества методики Lory:

- Эффективность обучения и сходимость: Методика Lory достигает уровня потерь, эквивалентного менее чем половине обучающих токенов для моделей с различным количеством параметров, что говорит о более высокой производительности при таких же ресурсах обучения.

- Языковое моделирование: MoE-модели, предложенные в методике Lory, превосходят плотные базовые модели во всех областях, снижая перплексию.

- Дополнительные задачи: Модели, разработанные на основе методики Lory, демонстрируют увеличение производительности в ряде дополнительных задач, что говорит об их эффективности в различных сценариях использования.

В итоге, методика Lory представляет собой значительное улучшение в области MoE-моделей, обеспечивая более высокую эффективность обучения и лучшую специализацию экспертов, что позволяет захватить информацию на уровне предметной области. Будущие работы включают масштабирование методики Lory и развитие более эффективных методов декодирования.