«`html

Использование Искусственного Интеллекта для Развития Вашего Бизнеса

Используя языковое мышление, крупные модели видео-языкового восприятия (VLM) продемонстрировали удивительные возможности как адаптивные агенты, способные решать широкий спектр задач. Хороший способ улучшить производительность VLM — это настройка их с помощью конкретных визуальных инструкций. Их производительность значительно улучшается благодаря этой стратегии, которая учит их следовать точным визуальным указаниям.

Преодоление Ограничений с Помощью Обучения с Подкреплением

Однако у этого метода есть недостатки, которые в основном зависят от обучения по собранным заранее данным. Это может быть не идеальным методом для обучения агентов в многошаговых интерактивных средах, которые требуют понимания языка в дополнение к визуальному распознаванию. Для преодоления этих ограничений предлагается использовать обучение с подкреплением (RL), чтобы полностью развить способности принятия решений агентов VLM в сложных многошаговых ситуациях.

Алгоритмическая Структура с Обучением с Подкреплением

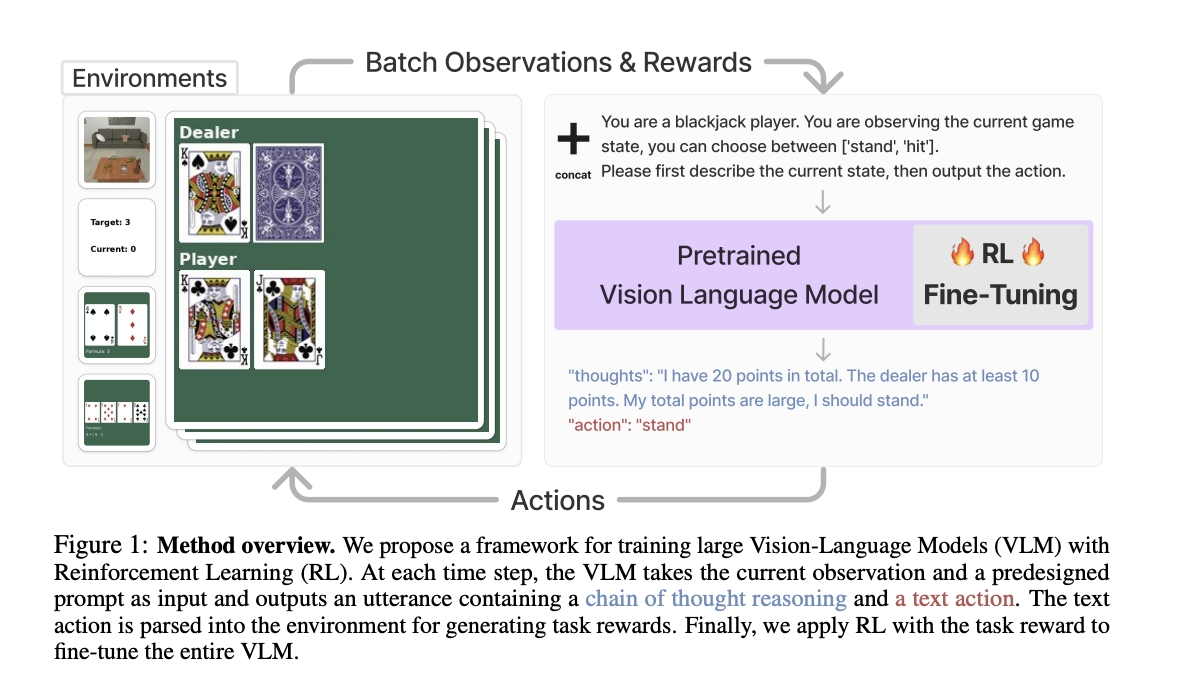

В недавних исследованиях команда ученых создала алгоритмическую структуру, использующую обучение с подкреплением для оптимизации VLM для решения этой проблемы. Сначала структура предоставляет описание задачи VLM, вызывая у модели цепную логику мышления (CoT). Это важный этап, потому что он позволяет VLM изучать промежуточные шаги в рассуждениях, которые логически приводят к последнему текстовому действию, необходимому для завершения задачи.

Текстовый вывод, созданный VLM, обрабатывается в исполнимые действия, чтобы агент мог взаимодействовать со своим окружением. Агент награждается через эти взаимодействия в зависимости от того, насколько успешно его действия достигают целей задачи. Эти награды затем используются для настройки всего VLM с помощью RL, улучшая его способность принимать решения.

Практическое Применение

Эмпирические результаты тестов показали, что этот подход значительно улучшает производительность агентов VLM в задачах принятия решений. Например, этот подход позволил 7-миллиардному параметрическому моделю превзойти популярные коммерческие модели, такие как GPT-4V и Gemini. Команда поделилась, что они обнаружили, что эти преимущества производительности возможны только с использованием компонента CoT рассуждения. Общая производительность модели значительно снизилась, когда они оценили эту стратегию без использования CoT рассуждения. Это демонстрирует важность CoT рассуждения в обучающей структуре RL и ее критическую функцию в улучшении способностей VLM в принятии решений.

Если вы заинтересованы в развитии вашего бизнеса с использованием ИИ, обратитесь к нам для получения консультации по внедрению ИИ и ознакомьтесь с нашими решениями на сайте Flycode.ru.

«`