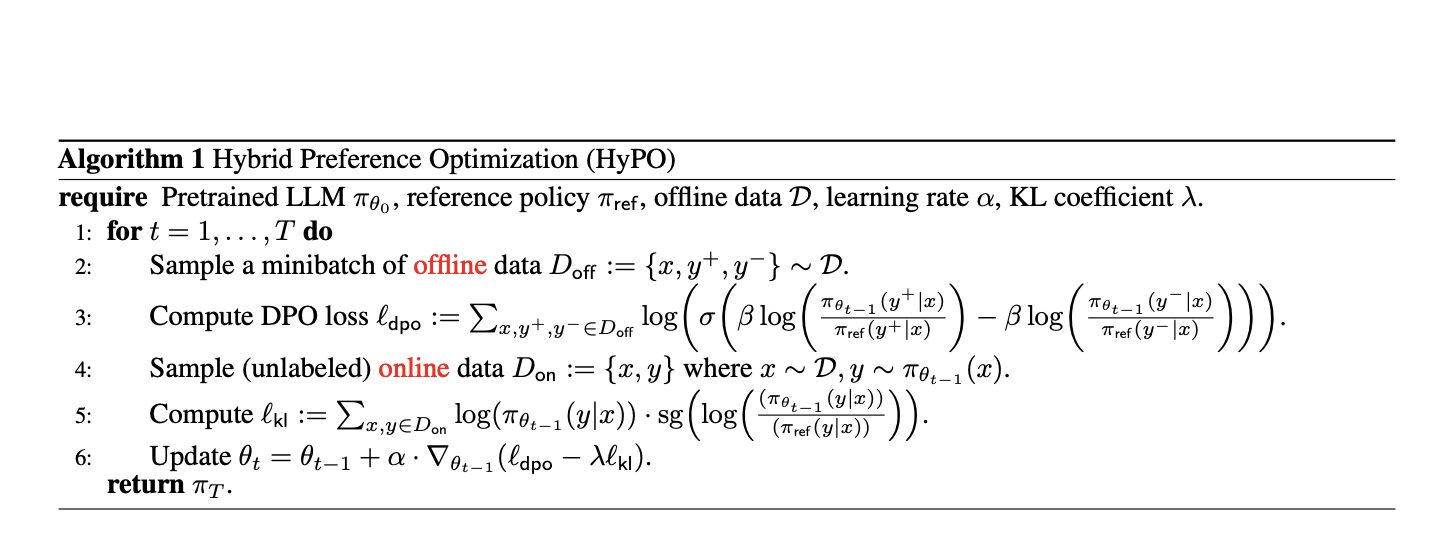

HyPO: Гибридный алгоритм обучения с подкреплением, использующий офлайн-данные для контрастивной оптимизации предпочтений и онлайн-неразмеченные данные для регуляризации KL

Исследование в области искусственного интеллекта акцентирует внимание на тонкой настройке больших языковых моделей (LLM) для соответствия приоритетам человека. Эта настройка обеспечивает генерацию полезных, актуальных и соответствующих ответов систем ИИ ожиданиям пользователей. Текущий подход в области ИИ подчеркивает обучение на предпочтительных данных человека для улучшения этих моделей, решая проблему сложности ручной спецификации функций вознаграждения для различных задач. Два основных подхода в этой области — онлайн обучение с подкреплением (RL) и офлайн контрастивные методы, каждый из которых имеет уникальные преимущества и вызовы.

Применимые практические решения

Одной из центральных проблем тонкой настройки LLM на предпочтения человека является ограниченный охват статических наборов данных. Эти наборы могут не соответствовать разнообразию и динамике предпочтений человека в реальных приложениях. Проблема охвата наборов данных особенно остро проявляется, когда модели обучаются исключительно на заранее собранных данных, что может привести к недостаточной производительности. Это подчеркивает необходимость методов эффективного использования статических наборов данных и данных в реальном времени для улучшения соответствия модели предпочтениям человека.

Существующие методы тонкой настройки предпочтений в LLM включают онлайн методы обучения с подкреплением, такие как оптимизация приближенной политики (PPO), и офлайн контрастивные методы, такие как прямая оптимизация предпочтений (DPO). Онлайн методы обучения с подкреплением включают двухэтапную процедуру, при которой модель вознаграждения обучается на фиксированном офлайн-наборе предпочтений, за которым следует обучение с использованием онлайн-данных. Этот подход имеет преимущества реальной обратной связи, но требует вычислительных ресурсов. В отличие от этого, офлайн контрастивные методы оптимизируют политики на основе только предварительно собранных данных, избегая необходимости выборки в реальном времени, но потенциально страдая от переобучения и ограниченных возможностей обобщения.

Исследователи из Университета Карнеги-Меллон, компании Aurora Innovation и Корнеллского университета представили новый метод под названием HyPO. Этот гибридный подход объединяет преимущества онлайн и офлайн методов с целью повышения производительности модели при сохранении вычислительной эффективности.

HyPO использует сложный алгоритмический каркас, который использует офлайн-данные для цели DPO и онлайн выборки для контроля обратной дивергенции KL. Алгоритм итеративно обновляет параметры модели, оптимизируя потери DPO и включая регуляризационный член KL, полученный из онлайн-выборок. Этот гибридный подход эффективно решает недостатки чисто офлайн методов, таких как переобучение и недостаточный охват наборов данных, интегрируя преимущества онлайн методов обучения с подкреплением, но без их вычислительной сложности.

Эмпирические результаты

Производительность HyPO была оценена на нескольких показателях, включая задачу TL;DR и общие бенчмарки чата, такие как AlpacaEval 2.0 и MT-Bench. Результаты были впечатляющими, с HyPO, достигшим победного результата 46.44% в задаче TL;DR с использованием модели Pythia 1.4B, по сравнению с 42.17% для метода DPO. Для модели Pythia 2.8B HyPO достиг победного результата 50.50%, значительно превзойдя 44.39% для DPO. Кроме того, HyPO продемонстрировал превосходный контроль над обратной дивергенцией KL, со значениями 0.37 и 2.51 для моделей Pythia 1.4B и 2.8B соответственно, по сравнению с 0.16 и 2.43 для DPO.

В общих бенчмарках чата HyPO также показал заметные улучшения. Например, в оценке MT-Bench модели, настроенные с помощью HyPO, достигли оценок 8.43 и 8.09 в среднем по первому и второму ходу соответственно, превосходя оценки моделей, настроенных с помощью DPO в 8.31 и 7.89. Аналогично, в AlpacaEval 2.0 HyPO достиг 30.7% и 32.2% победных результатов на первом и втором ходах соответственно, по сравнению с 28.4% и 30.9% для DPO.

Эмпирические результаты подчеркивают способность HyPO уменьшать проблемы переобучения, которые часто наблюдаются в офлайн контрастивных методах. Например, когда модель обучалась на наборе данных TL;DR, HyPO сохранял средний KL-показатель валидации значительно ниже, чем у DPO, указывая на лучшее соответствие эталонной политике и снижение переобучения. Эта способность использовать онлайн данные для регуляризации помогает HyPO достигать более надежной производительности на различных задачах.

В заключение, введение гибридной оптимизации предпочтений (HyPO), эффективно объединяющей офлайн и онлайн данные, адресует ограничения существующих методов и улучшает соответствие больших языковых моделей предпочтениям человека. Повышение производительности, продемонстрированное в эмпирических оценках, подчеркивает потенциал HyPO в достижении более точных и надежных систем искусственного интеллекта.

Для подробностей найдите статью. Вся заслуга за данное исследование принадлежит его исследователям. Также не забудьте подписаться на наш Telegram канал и присоединиться к нашей группе по продажам. Если вам нравится наша работа, вы полюбите нашу рассылку.