Решение для мультизадачного обучения

Мультизадачное обучение (MLT) предполагает обучение одной модели для выполнения нескольких задач одновременно, используя общую информацию для улучшения производительности. Оптимизация среднего потери может привести к субоптимальной производительности, если задачи развиваются неравномерно. Балансировка производительности задач и стратегий оптимизации критична для эффективного MLT.

Проблемы и существующие решения

Существующие решения для устранения проблемы недооптимизации в мультизадачном обучении включают техники манипуляции градиентами. Однако эти подходы могут стать вычислительно затратными при большом количестве задач и размере модели.

Новое решение: Fast Adaptive Multitask Optimization (FAMO)

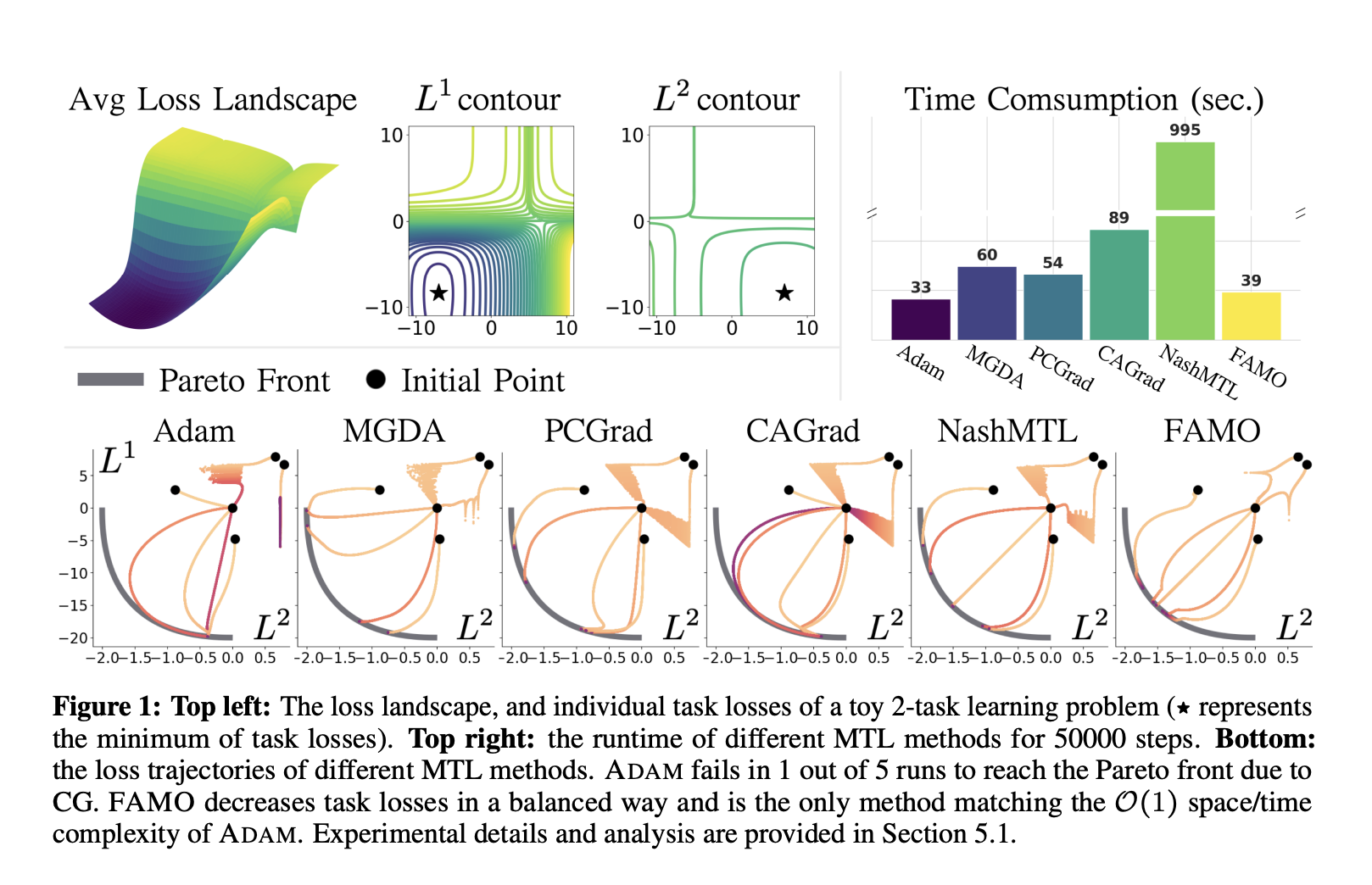

Исследовательская группа из Университета Техаса в Остине, Salesforce AI Research и Sony AI представили новый метод FAMO, который динамически корректирует веса задач для обеспечения сбалансированного снижения потерь, используя историю потерь вместо вычисления всех градиентов задач. FAMO демонстрирует сравнимую или более высокую производительность по сравнению с существующими методами при значительном улучшении вычислительной эффективности.

Практическое применение

FAMO предлагает вычислительно эффективный подход к оптимизации мультизадачного обучения путем динамической коррекции весов задач и амортизации вычислений во времени. Это приводит к улучшенной производительности без необходимости обширных вычислений градиентов.

Эмпирические эксперименты

Авторы провели эксперименты на различных настройках, демонстрируя способность FAMO эффективно устранять конфликтующие градиенты и обеспечивать стабильную производительность в различных сценариях мультизадачного обучения.

Если вы хотите узнать больше о применении FAMO и других решений в области искусственного интеллекта, свяжитесь с нами.