«`html

LMMS-EVAL: единый и стандартизированный мультимодальный фреймворк для прозрачной и воспроизводимой оценки искусственного интеллекта

Фундаментальные большие языковые модели (LLM) такие как GPT-4, Gemini и Claude продемонстрировали заметные возможности, соответствующие или превосходящие человеческую производительность. В этом контексте бенчмарки становятся сложными, но необходимыми инструментами для различения различных моделей и выявления их ограничений. Комплексные оценки языковых моделей были проведены с целью изучения моделей в различных измерениях. Единый фреймворк оценки становится все более важным по мере того, как генеративный искусственный интеллект движется за пределы только языкового подхода, чтобы включать другие модальности.

LMMS-EVAL: стандартизированный и надежный набор бенчмарков для оценки мультимодальных моделей в целом

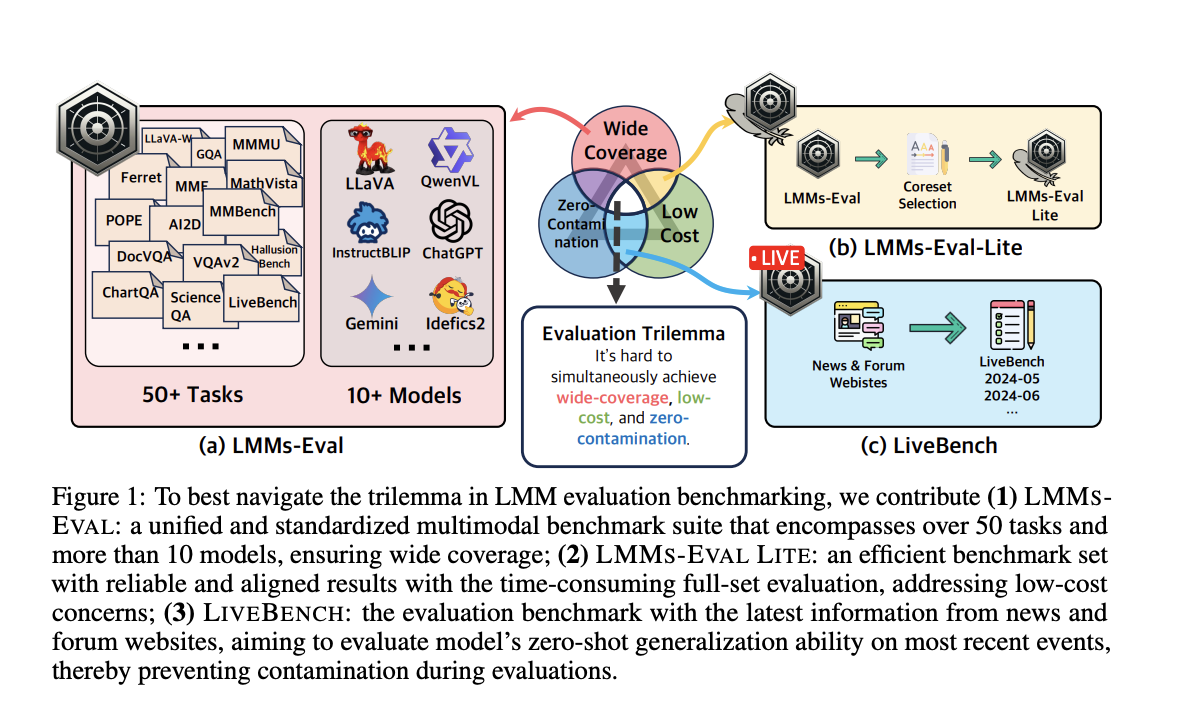

Для решения этой проблемы команда исследователей из LMMs-Lab Team и S-Lab, NTU, Сингапур, создала LMMS-EVAL, стандартизированный и надежный набор бенчмарков, предназначенный для оценки мультимодальных моделей в целом. Более десяти мультимодальных моделей и около 30 вариантов оцениваются LMMS-EVAL, охватывающий более 50 задач в различных контекстах. Он имеет единый интерфейс, чтобы упростить интеграцию новых моделей и наборов данных, и предлагает стандартизированный процесс оценки для обеспечения открытости и повторяемости.

LMMS-EVAL LITE и LiveBench: разнообразные и доступные методы оценки мультимодальных моделей

Понимая сложность достижения бенчмарка, который является свободным от загрязнений, недорогим и широко охватывающим, команда добавила LMMS-EVAL LITE и LiveBench в сцену оценки LMM. LMMS-EVAL LITE сосредотачивается на различных задачах и устраняет излишние экземпляры данных, предлагая доступную и всестороннюю оценку. LiveBench, с другой стороны, предоставляет дешевый и широко применимый метод проведения бенчмарков путем создания тестовых данных с использованием последней информации, полученной из новостных и интернет-форумов.

Оценка моделей в реальном времени и в условиях нулевой обучаемости

LMMS-EVAL представляет собой объединенный набор бенчмарков для оценки мультимодальных моделей, оценивающий более десяти моделей с более чем 30 подвидами и охватывающий более 50 задач. Цель LMMS-EVAL заключается в обеспечении беспристрастных и последовательных сравнений между различными моделями путем упрощения и стандартизации процесса оценки.

LMMS-EVAL LITE представляет собой эффективную версию всего набора оценок. Устранение бесполезных экземпляров данных снижает расходы, обеспечивая надежные и последовательные результаты с тщательной оценкой. Поскольку LMMS-EVAL LITE сохраняет высокое качество оценки, это доступная альтернатива для глубоких оценок моделей.

Бенчмарк LIVEBENCH оценивает способность моделей к нулевой обучаемости на текущих событиях, используя актуальные данные из новостных и форумных веб-сайтов. LIVEBENCH предлагает доступный и широко применимый подход для оценки мультимодальных моделей, обеспечивая их непрерывную применимость и точность в постоянно меняющихся реальных ситуациях.

Заключение

Надежные бенчмарки являются неотъемлемым элементом развития искусственного интеллекта. Они предоставляют необходимую информацию для различения моделей, выявления недостатков и направления будущих усовершенствований. Стандартизированные, четкие и повторяемые бенчмарки становятся все более важными по мере развития искусственного интеллекта, особенно в отношении мультимодальных моделей. LMMS-EVAL, LMMS-EVAL LITE и LiveBench призваны закрыть пробелы в существующих фреймворках оценки и способствовать непрерывному развитию искусственного интеллекта.

«`