Управление и оптимизация вызовов API к различным поставщикам больших языковых моделей (LLM) могут быть сложными, особенно при работе с различными форматами, ограничениями по количеству вызовов и управлением затратами. Создание однородных интерфейсов для различных платформ LLM часто представляет собой проблему, что затрудняет оптимизацию операций, особенно в корпоративной среде, где эффективность и управление затратами имеют решающее значение.

Существующие решения для управления вызовами API LLM обычно включают в себя ручную интеграцию различных API, каждый из которых имеет свой формат и структуру ответа. Некоторые платформы предлагают ограниченную поддержку резервных механизмов или унифицированного ведения журнала, но эти инструменты часто лишены гибкости или масштабируемости для эффективного управления несколькими поставщиками.

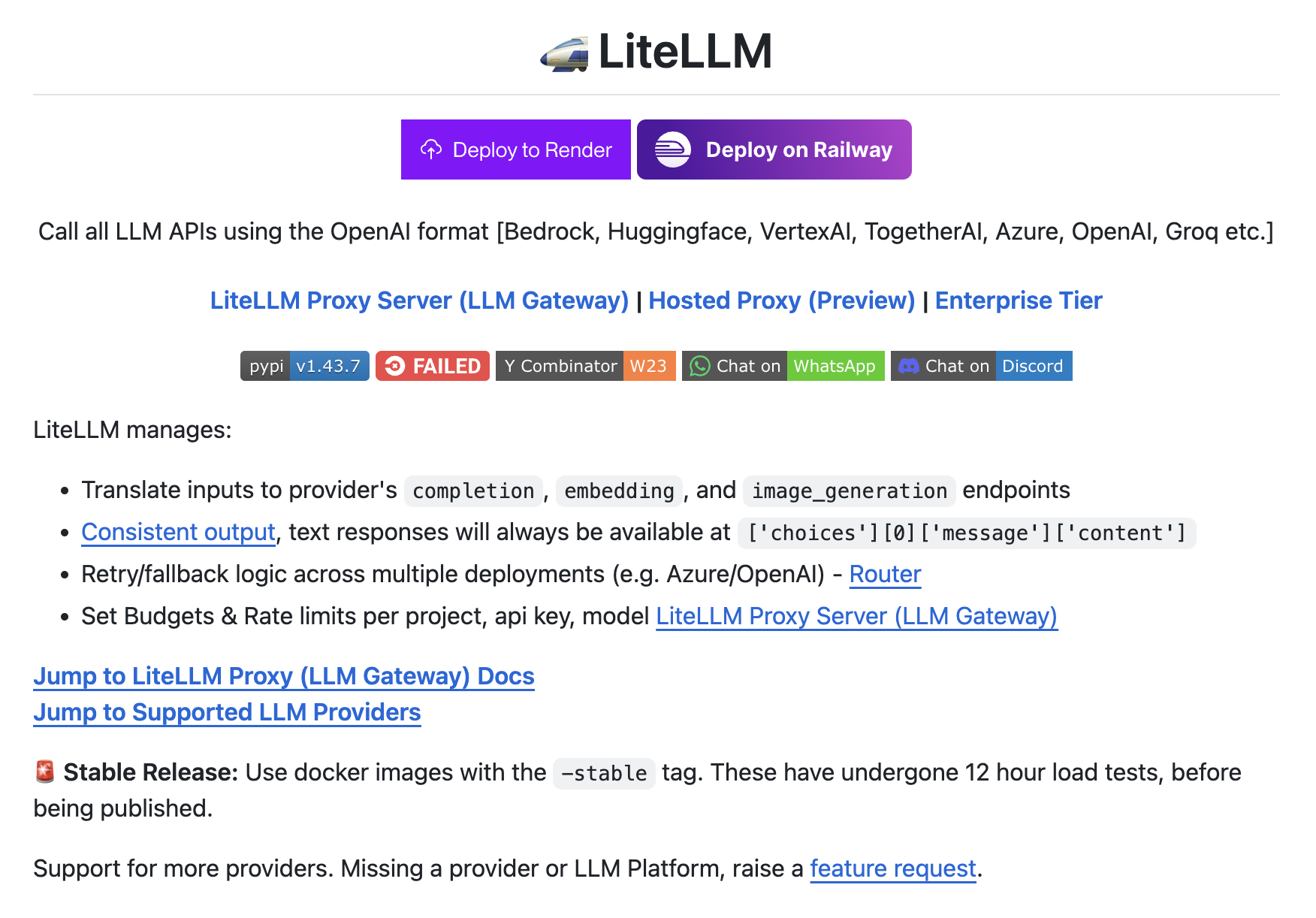

Введение LiteLLM

Прокси-сервер LiteLLM решает эти проблемы, предоставляя унифицированный интерфейс для вызова API LLM с использованием однородного формата, независимо от поставщика. Он поддерживает широкий спектр поставщиков LLM, включая OpenAI, Huggingface, Azure и Google VertexAI, преобразуя входные и выходные данные в стандартный формат. Это упрощает процесс разработки, позволяя разработчикам переключаться между поставщиками без изменения основной логики своих приложений. Кроме того, LiteLLM предлагает функции, такие как механизмы повторной попытки и резервирования, управление бюджетом и ограничением количества вызовов, а также полноценное ведение журнала и наблюдаемость благодаря интеграциям с такими инструментами, как Lunary и Helicone.

Что касается производительности, LiteLLM демонстрирует надежные возможности с поддержкой как синхронных, так и асинхронных вызовов API, включая потоковые ответы. Платформа также позволяет балансировать нагрузку между несколькими развертываниями и предоставляет инструменты для отслеживания расходов и безопасного управления ключами API. Метрики и функции подчеркивают ее масштабируемость и эффективность, что делает ее подходящей для приложений на корпоративном уровне, где управление несколькими поставщиками LLM является необходимым. Кроме того, ее способность интегрироваться с различными инструментами ведения журнала и мониторинга обеспечивает возможность разработчикам поддерживать видимость и контроль над своим использованием API.

В заключение, LiteLLM предлагает комплексное решение для управления вызовами API по различным поставщикам LLM, упрощая процесс разработки и предоставляя важные инструменты для контроля затрат и наблюдаемости. Предлагая унифицированный интерфейс и поддерживая широкий спектр функций, он помогает разработчикам оптимизировать свои рабочие процессы, уменьшить сложность и обеспечить эффективность и масштабируемость своих приложений.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте LiteLLM: Call 100+ LLMs Using the Same Input/Output Format.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram.

Попробуйте ИИ ассистент в продажах. Этот ИИ ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.