Как важна модель ссылки в прямой оптимизации предпочтений (DPO)? Эмпирическое исследование оптимальных ограничений KL-дивергенции и необходимости

Прямая оптимизация предпочтений (DPO) — это передовой метод обучения для настройки больших языковых моделей (LLM). В отличие от традиционной надзорной настройки, которая зависит от одной эталонной ссылки, DPO обучает модели различать качество различных кандидатских результатов. Эта техника критически важна для выравнивания LLM с человеческими предпочтениями и повышения их способности эффективно генерировать желаемые ответы. Путем включения методов обучения с подкреплением DPO позволяет моделям учиться на обратной связи, что делает его ценным подходом в обучении языковых моделей.

Оптимизация предпочтений

Основной проблемой, рассмотренной в этом исследовании, являются ограничения, накладываемые тяжестью на эталонные модели или политики в процессе DPO. Хотя они важны для поддержания стабильности и направления в обучении, эти ссылки могут ограничить потенциальные улучшения производительности LLM. Понимание оптимального использования и силы этих ссылок важно для максимизации эффективности и качества результатов обучения моделей DPO. Исследование исследует баланс между поддержанием сильной эталонной политики и обеспечением достаточной гибкости для улучшения модели за пределами начальных ограничений.

Методы обучения предпочтениям

Текущие методы обучения предпочтениям включают надзорную настройку (SFT), подходы обучения с подкреплением (RL) и методы обучения на основе вознаграждения. SFT полагается на одну эталонную ссылку, в то время как RL и методы обучения на основе вознаграждения, такие как контрастное обучение, обучают модели ранжировать и предпочитать лучшие результаты на основе обратной связи. DPO включает ограничение KL-дивергенции для управления отклонениями от эталонной модели. Это ограничение обеспечивает, что модель не отклоняется слишком сильно от эталона, сбалансировав соблюдение эталона с оптимизацией производительности.

Исследователи из Университета Йель, Шанхайского университета Цзяотун и Института AI Аллена представили всесторонний анализ зависимости DPO от эталонных политик. Они исследовали оптимальную силу ограничения KL-дивергенции и оценили необходимость эталонных политик в надзорной настройке. Исследование включало изменение силы ограничения для определения лучшего баланса, который максимизирует производительность DPO без чрезмерной зависимости от эталонной модели. Цель исследования заключалась в предоставлении понимания запутанной роли эталонных политик и предложении руководства по лучшим практикам для будущих исследований.

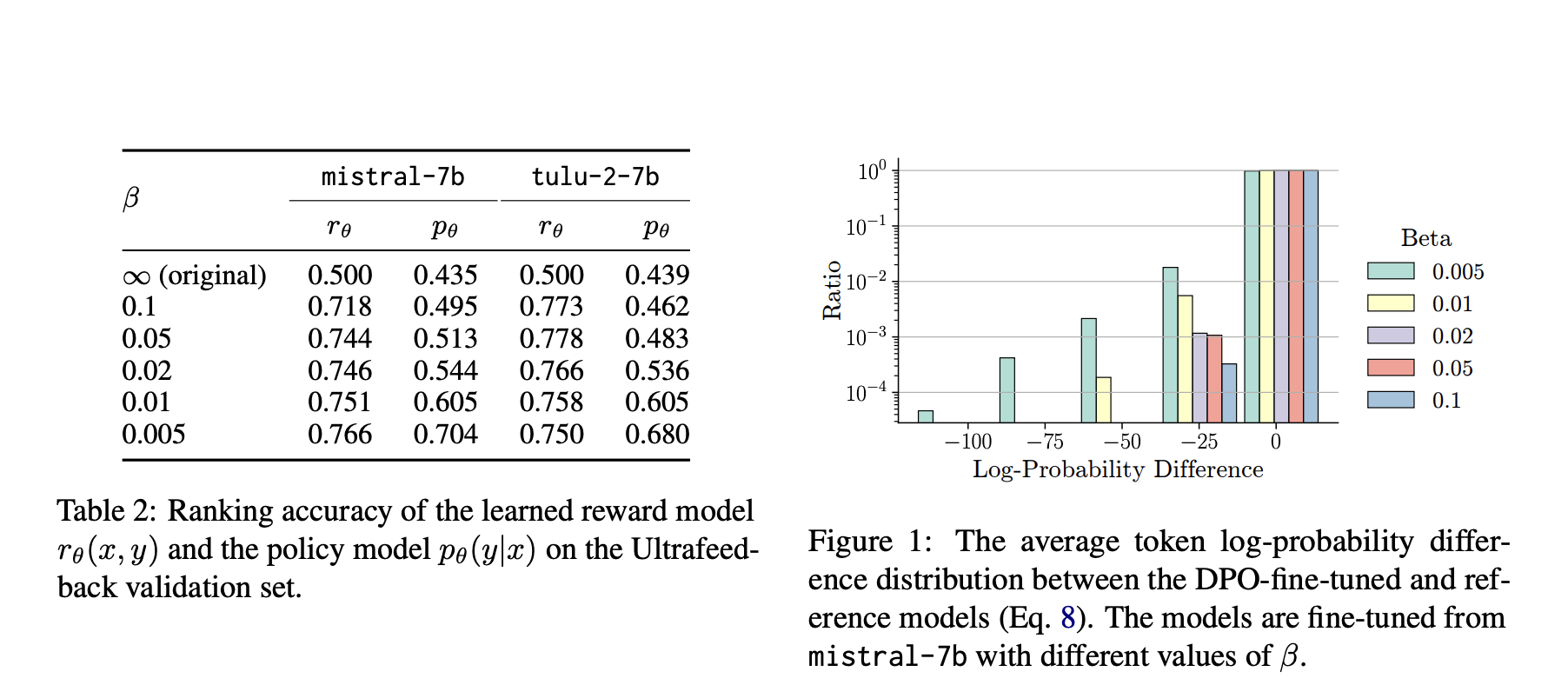

Предложенный метод включает детальное исследование различных сил ограничения KL-дивергенции, используемых в DPO. Исследователи провели эксперименты с использованием открытых предварительно обученных LLM, Tulu 2 и Mistral, на бенчмарке AlpacaEval. Они проанализировали производительность на уровне последовательности и токена, чтобы понять, как изменение силы ограничения влияет на точность и стабильность модели. Эксперименты показали, что меньшее ограничение KL-дивергенции в целом улучшало производительность до тех пор, пока оно не стало слишком маленьким, что привело к ухудшению. Кроме того, они изучили необходимость эталонных политик, сравнив DPO с альтернативными целями обучения, демонстрируя превосходство DPO при использовании соответствующей эталонной модели.

Исследование выявило значительные результаты относительно влияния ограничения KL-дивергенции на производительность DPO. Меньшее ограничение обычно приводило к лучшей производительности, с оптимальным значением β около 0,01-0,02. Например, модель, настроенная на Mistral-7b, достигла оценки AlpacaEval2 в 16,25 при β 0,01 по сравнению с исходной оценкой 7,57 без DPO. Анализ показал, что уменьшение силы ограничения улучшило производительность до тех пор, пока оно не стало слишком маленьким, после чего производительность модели ухудшилась. Кроме того, более сильные эталонные модели, такие как Mistral-v0.2 и Llama-3-70b, предоставляли дополнительные преимущества, но только при совместимости с настроенной моделью. Исследование подчеркнуло важность выбора подходящей эталонной политики для достижения оптимальных результатов.

Исследование подчеркивает тонкую роль эталонных политик в DPO. Тщательная калибровка силы ограничения и выбор совместимых эталонных моделей может значительно улучшить производительность LLM. Полученные результаты подчеркивают необходимость дальнейших исследований для изучения взаимосвязи между эталонными политиками и производительностью обучения DPO. Кроме того, исследование призывает к более теоретическим и эмпирическим рекомендациям для лучшего понимания совместимости между обученными и эталонными моделями. В целом, это исследование предоставляет ценные и практические рекомендации для улучшения DPO и развития области настройки языковых моделей.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 47 тыс. ML SubReddit

Найдите предстоящие вебинары по ИИ здесь

Статья «Как важна модель ссылки в прямой оптимизации предпочтений (DPO)? Эмпирическое исследование оптимальных ограничений KL-дивергенции и необходимости» впервые появилась на MarkTechPost.

Как важна модель ссылки в прямой оптимизации предпочтений (DPO)? Эмпирическое исследование оптимальных ограничений KL-дивергенции и необходимости

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте How Important is the Reference Model in Direct Preference Optimization DPO? An Empirical Study on Optimal KL-Divergence Constraints and Necessity.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram

Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/ Этот ИИ ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru