Исследование контекстного обучения с подкреплением в крупных языковых моделях с помощью разреженных автокодировщиков

Практические решения и ценность:

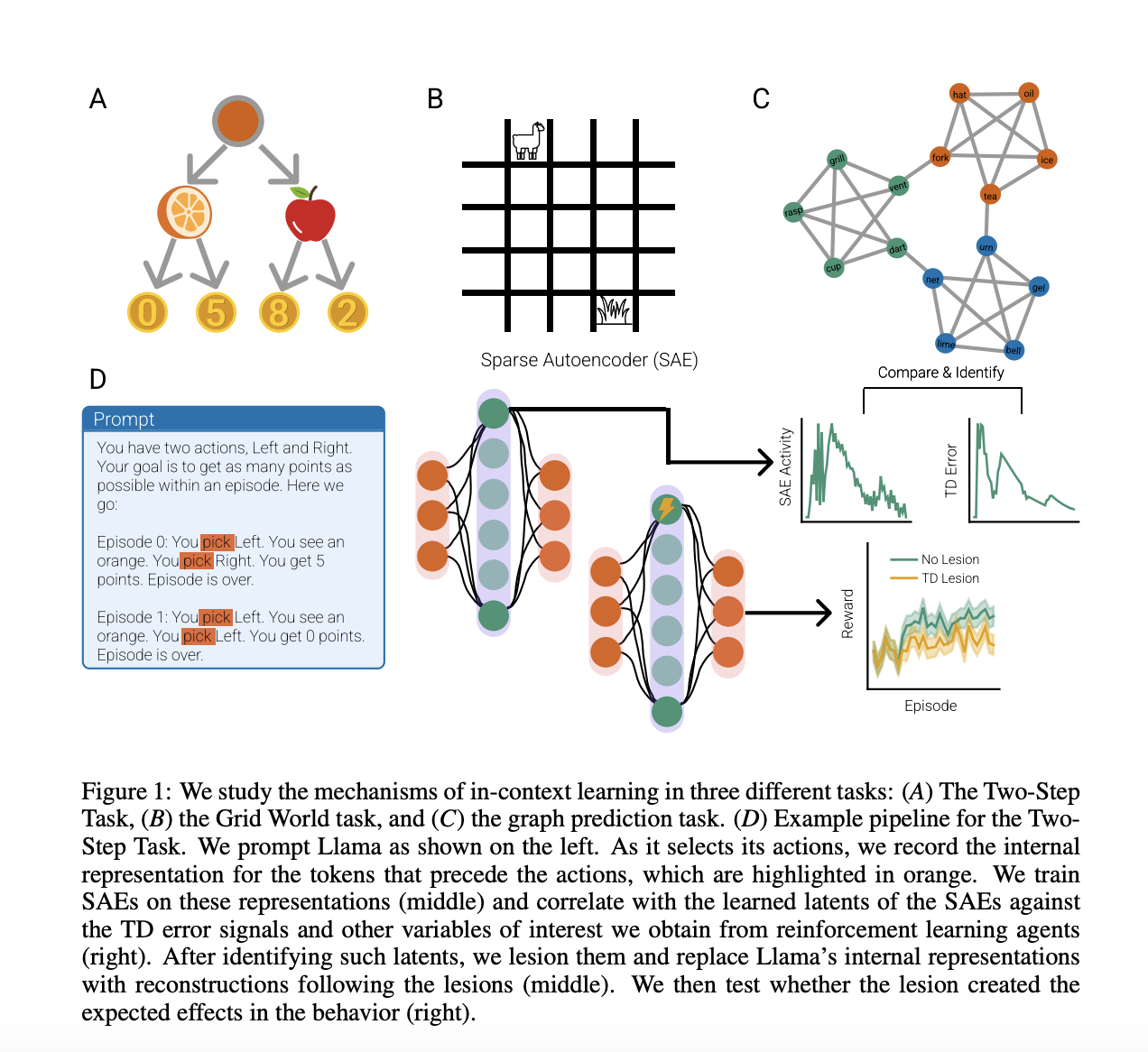

Большие языковые модели (LLM) продемонстрировали удивительные возможности обучения в контексте в различных областях, включая перевод, функциональное обучение и обучение с подкреплением. Ранее исследования показали, что LLM могут реализовывать различные методы регрессии и обучения с подкреплением в контексте. Использование разреженных автокодировщиков позволило исследователям идентифицировать ключевые особенности, влияющие на контекстное обучение, что в свою очередь повлияло на поведение и представления LLM.

Исследователи разработали методику анализа контекстного обучения с подкреплением в Llama 3 70B с использованием разреженных автокодировщиков. Они провели серию экспериментов, где Llama принимала последовательные решения для максимизации вознаграждения. Анализ показал, что обучение разреженных автокодировщиков на выходах трансформаторных блоков Llama позволило выявить представления, аналогичные ошибкам TD и Q-значениям, что дало понимание того, как Llama реализует алгоритмы обучения с подкреплением через предсказание следующего токена.

Исследователи также расширили свой анализ до более сложной задачи навигации по сетке 5×5, где Llama предсказывала действия агентов Q-обучения. Они обнаружили, что Llama улучшала свои предсказания действий со временем, особенно при наличии правильной информации о вознаграждении. Обучение разреженных автокодировщиков на представлениях Llama показало высокую корреляцию с Q-значениями и ошибками TD, что доказывает важность TD-подобных вычислений в способности Llama учиться структурным знаниям.

Это исследование подтверждает, что крупные языковые модели (LLM) реализуют обучение методом временной разницы (TD) для решения задач обучения с подкреплением в контексте. Используя разреженные автокодировщики, исследователи выявили и управляли ключевыми особенностями контекстного обучения, демонстрируя их влияние на поведение и представления LLM. Этот подход открывает пути для изучения различных способностей контекстного обучения и устанавливает связь между механизмами обучения LLM и наблюдаемыми у биологических агентов.