“`html

Раскрытие цепочки мыслей: исследование итеративных алгоритмов в языковых моделях

Цепочка мыслей (CoT) улучшает возможности LLM, позволяя им выполнять более сложные задачи рассуждения. Несмотря на то, что LLM в основном обучены для предсказания следующего токена, они могут генерировать подробные шаги в своих ответах, когда их просят объяснить свой мыслительный процесс. Эта способность, напоминающая логическое рассуждение, противоречива, поскольку LLM не являются явно разработанными для рассуждения. Исследования показали, что LLM испытывают трудности при решении проблем через предсказание одного токена, но преуспевают, когда могут генерировать последовательность токенов, эффективно используя эти последовательности как форму вычислительной ленты для решения более сложных проблем.

Исследователи из FAIR, Meta AI, Datashape, INRIA и других институтов исследуют, как CoT рассуждение возникает в трансформерах. Они представляют “итерационные головы”, специализированные механизмы внимания, важные для итеративного рассуждения, и отслеживают их развитие и функции в сети. Исследование показывает, как эти головы позволяют трансформерам решать сложные задачи через многошаговое рассуждение, фокусируясь на простых, контролируемых задачах, таких как копирование и полиномиальные итерации. Эксперименты показывают, что эти навыки хорошо переносятся между задачами, что подтверждает, что трансформеры могут развивать внутренние цепи для рассуждения, влияя на их данные обучения, что объясняет сильные возможности CoT, наблюдаемые в более крупных моделях.

Исследование сосредотачивается на понимании того, как трансформеры, особенно в контексте языковых моделей, могут изучать и выполнять итеративные алгоритмы, включающие последовательную обработку шагов. Исследуя контролируемые задачи, такие как задача копирования и полиномиальная итерация, исследователи стремятся прояснить, как трансформеры используют CoT рассуждение для эффективного решения таких задач. Через алгоритмические представления и синтетические данные они исследуют появление механизмов CoT рассуждения, таких как “итерационные головы”, в архитектурах трансформеров. Это позволяет подробно проанализировать, как трансформеры решают итеративные задачи, проливая свет на их рассуждательные способности за пределами простого предсказания токенов.

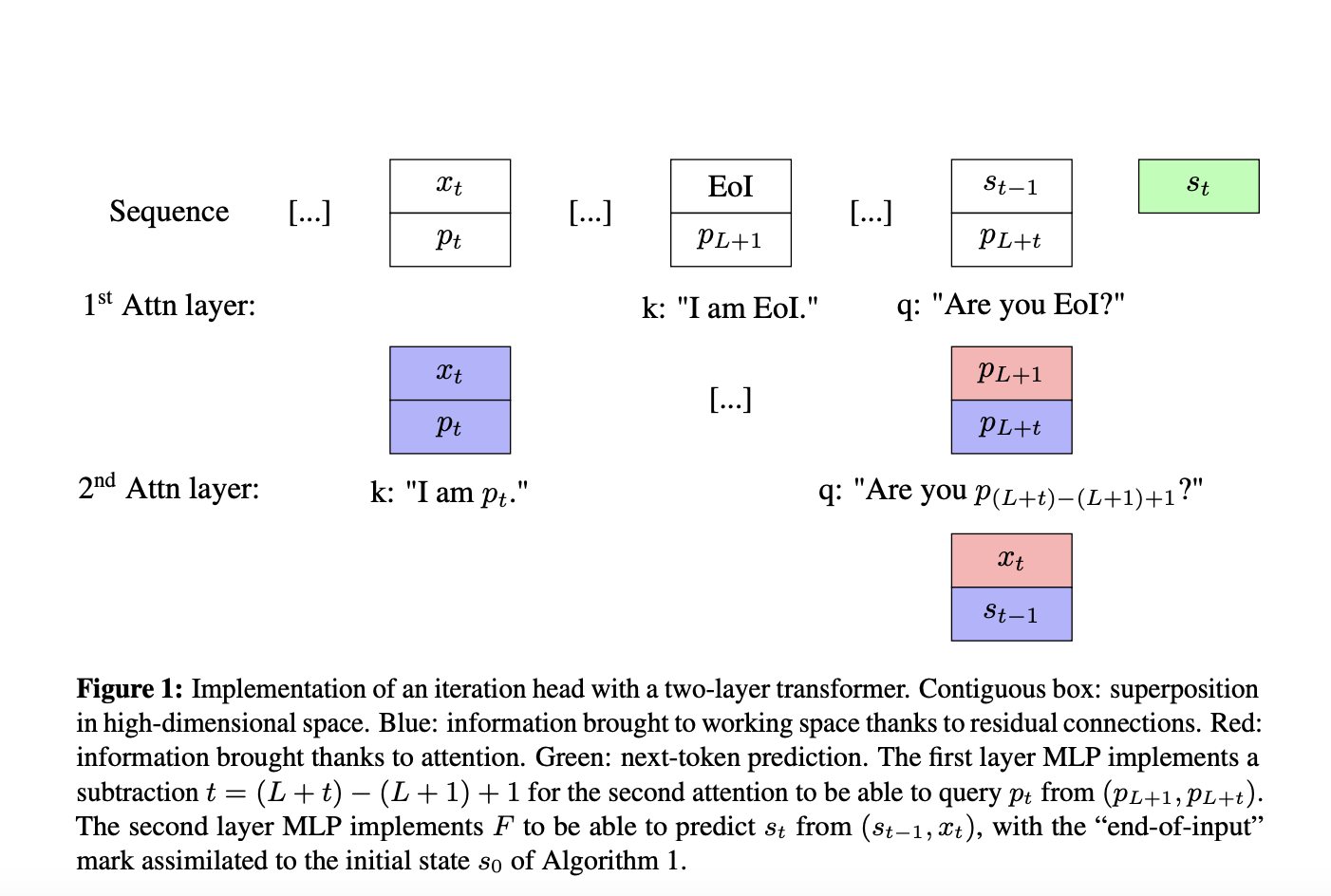

Исследователи углубляются в то, как трансформеры, особенно в языковых моделях, могут эффективно реализовывать итеративные алгоритмы через CoT рассуждение. Они описывают теоретическую концепцию, называемую “итерационной головой”, которая позволяет двухслойному трансформеру эффективно выполнять итеративные задачи с использованием механизмов внимания. Экспериментальные результаты подтверждают появление этой теоретической цепи во время обучения, подчеркивая ее устойчивость на различных задачах и архитектурах моделей. Кроме того, абляционные исследования исследуют вариации в изученных цепях и их влияние на производительность, проливая свет на механизмы, лежащие в основе CoT рассуждения в трансформерах.

Исследование исследует, как стратегическая кураторство данных может облегчить передачу навыков и улучшить эффективность обучения в языковых моделях. Модель может использовать ранее приобретенные знания, предварительно обучаясь на более простой задаче, а затем настраиваясь на более сложную, что приводит к более быстрой сходимости и улучшенной производительности. Например, обучение на задаче полиномиальной итерации перед переходом к задаче четности значительно сокращает время обучения, необходимое для изучения задачи четности. Этот контролируемый подход демонстрирует важность выбора данных и роль индуктивных предубеждений в формировании динамики обучения и производительности модели.

В заключение, исследование углубляется в появление CoT рассуждения в LLM, исследуя их способность решать итеративные алгоритмы. Оно демонстрирует, как трансформеры, обученные в основном для задач предсказания следующего токена, могут эффективно решать итеративные задачи, используя CoT рассуждение. Кураторство данных является ключевым фактором в формировании поведения модели, направляя их к конкретным цепям решения проблем. Хотя исследование сосредоточено на контролируемых сценариях, оно предполагает, что трансформеры, вероятно, развивают внутренние многошаговые цепи рассуждения, применимые к различным задачам. Кроме того, оно указывает на ограничение трансформеров в поддержании внутренних состояний, что может повлиять на их применимость к сложным алгоритмам и языковому моделированию.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 44k+ ML SubReddit

Попробуйте ИИ ассистент в продажах здесь. Этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru

“`