«`html

Исследование возможностей рассуждения больших языковых моделей (LLM) через их геометрическое понимание

Практические решения и ценность

Большие языковые модели (LLM) продемонстрировали выдающуюся производительность в различных задачах, и способность к рассуждениям является ключевым аспектом их развития. Однако основные факторы, определяющие эти улучшения, остаются неясными. В настоящее время основные подходы к улучшению рассуждения включают увеличение размера модели и расширение длины контекста через методы цепочки мыслей, улучшенного генерирования с использованием поиска и примерно-ориентированных подсказок. Хотя эти методы эффективны, они представляют лишь часть потенциальных путей улучшения и часто приводят к увеличению вычислительных затрат и задержке вывода в реальных приложениях.

Исследователи из Tenyx проводят это исследование, чтобы исследовать геометрию слоев трансформера в LLM, сосредотачиваясь на ключевых свойствах, связанных с их выразительной силой. Исследование определяет два критических фактора: плотность взаимодействия токенов в модуле многоголового внимания (MHA), отражающая сложность представления функции, достижимой последующим многослойным перцептроном (MLP), и отношение между увеличением размера модели и длиной контекста с более высокой плотностью внимания и улучшенными рассуждениями.

Исследование также демонстрирует сильную корреляцию между внутренней размерностью последних слоев и корректностью ответов, независимо от размера модели. Они также обнаруживают, что увеличение контекста в подсказках может увеличить внутреннюю размерность, особенно когда контекст соответствует вопросу. Это приводит к более адаптивным преобразованиям для каждого токена и, как следствие, к более высокой вероятности корректных ответов.

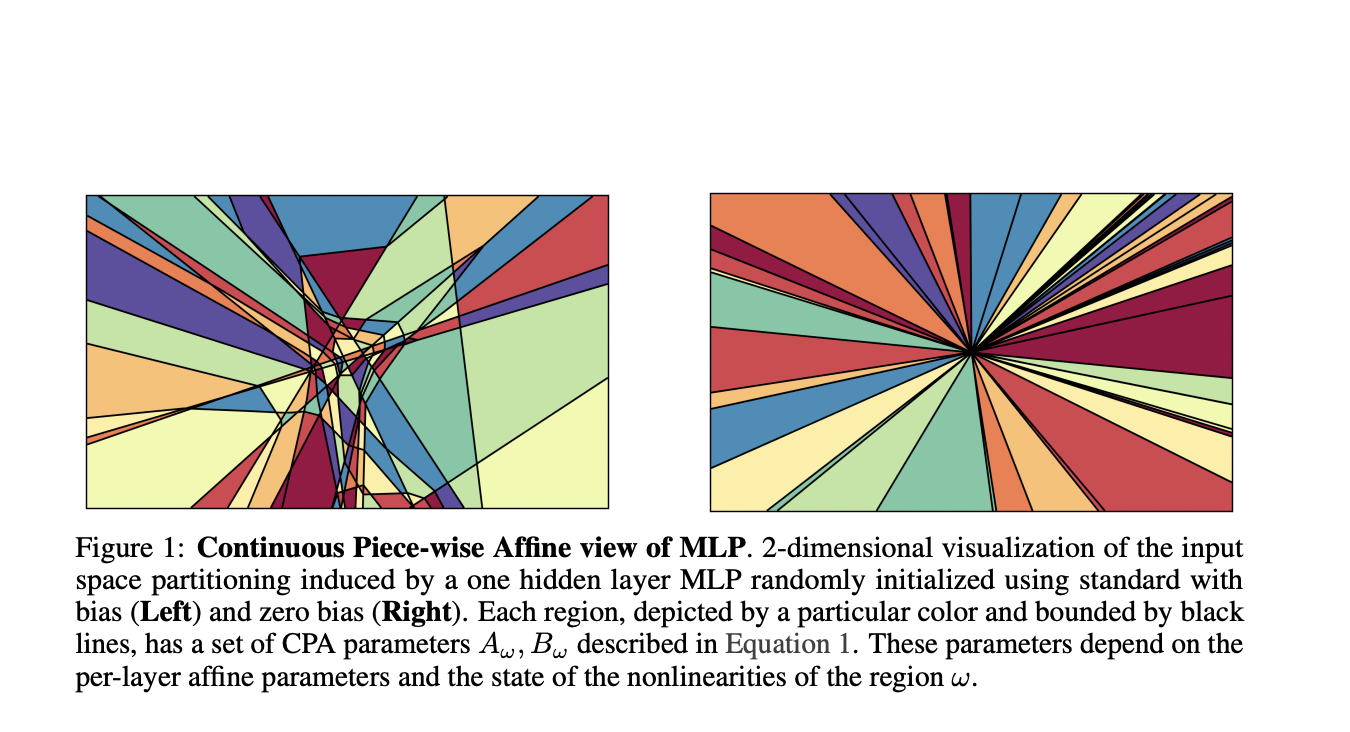

Исследование подчеркивает важность разделения пространства ввода, обусловленного MLP, в глубоких нейронных сетях и LLM. Оно также предлагает, что сила выразительности модели сильно коррелирует с ее рассуждательными способностями.

Это исследование представляет важные практические решения для улучшения рассуждений LLM и может помочь меньшим моделям сократить разрыв в производительности по сравнению с более крупными моделями в будущем.

«`