Применение искусственного интеллекта для решения проблемы мультиязычной токсичности в больших языковых моделях

Большие языковые модели (LLM) привлекли значительное внимание в последние годы, но их безопасность в мультиязычных контекстах остается критической проблемой. Исследователи сталкиваются с вызовом смягчения токсичности в мультиязычных LLM, исследования выявили высокие уровни токсичности в таких моделях. Текущие подходы к снижению токсичности в мультиязычных LLM сталкиваются с серьезными препятствиями из-за ресурсоемкости существующих решений.

Практические решения и ценность

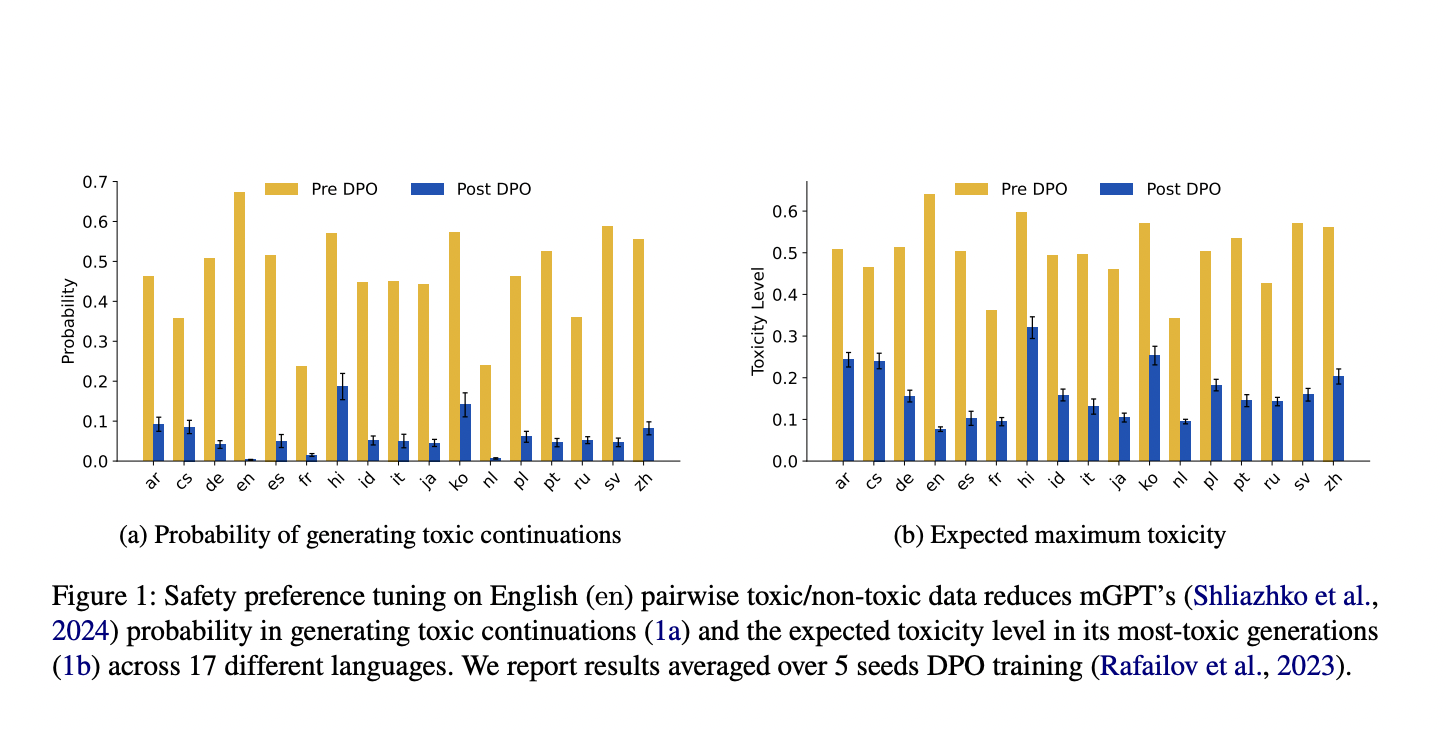

Исследователи из Университета Брауна изучают мультиязычную детоксикацию LLM с использованием настройки предпочтений на английском языке без перевода для мультиязычной детоксикации LLM. Они продемонстрировали, что использование этой техники существенно снижает уровни токсичности в LLM-поколениях на 17 различных языках. Этот метод демонстрирует нулевую кросс-языковую обобщаемость, противоречащую предыдущим предположениям о ограниченной кросс-языковой передаче в задачах безопасности LLM.

Архитектура метода включает локализацию токсичности в LLM с использованием зондов и проведение причинных вмешательств. Результаты показывают двойную мультиязычность MLP в LLM. Эффективность этого метода заключается в общих мультиязычных представлениях, позволяющих кросс-языковую передачу предпочтений безопасности.