Эволюция машинного обучения и новые решения

Эволюция машинного обучения привела к значительным достижениям в языковых моделях, которые важны для задач, таких как генерация текста и ответ на вопросы. Одним из таких решений является модель Mamba, обладающая линейной сложностью и эффективностью для задач с длинным контекстом.

Проблемы и решения

Большие языковые модели сталкиваются с высокими вычислительными затратами, особенно при увеличении числа параметров. Модель Mamba предлагает преимущества линейной сложности, но её размер приводит к значительному потреблению энергии и высоким затратам на обучение. Это создает необходимость в исследовании методов экстремальной квантизации для практического развертывания в условиях ограниченных ресурсов.

Техники оптимизации

Исследователи изучили методы, такие как обрезка, квантизация с низкой битностью и оптимизация кэширования. Квантизация позволяет уменьшить размер модели без значительной потери производительности. Однако поведение SSM, таких как Mamba, при экстремальной квантизации ещё не было исследовано.

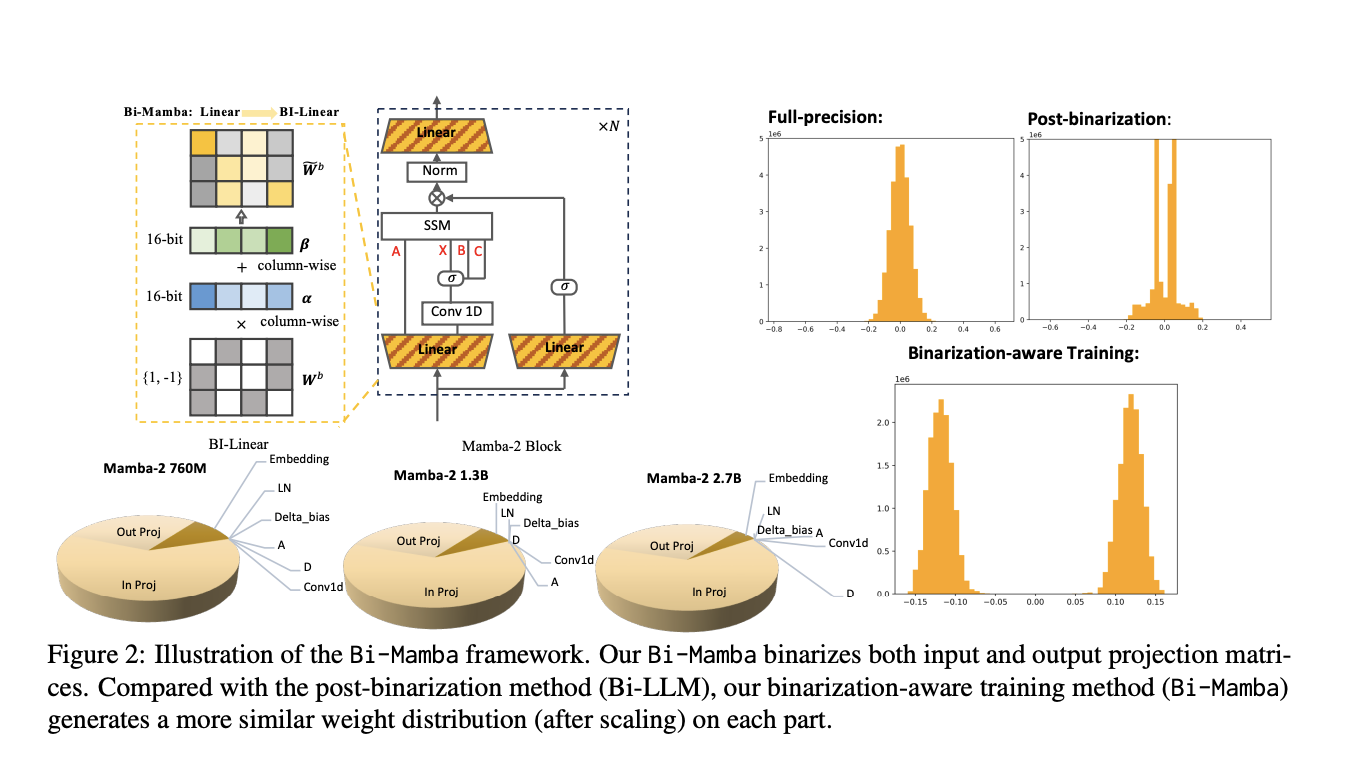

Инновации Bi-Mamba

Исследователи из Муниверситета искусственного интеллекта имени Мохаммеда бин Заида и Университета Карнеги-Меллон представили Bi-Mamba — архитектуру, разработанную для сценариев с низким потреблением памяти и высокой эффективностью. Эта модель использует обучение с учетом двоичной квантизации, что позволяет достигать высокой производительности при экстремальной квантизации.

Преимущества Bi-Mamba

- Эффективность: Bi-Mamba достигает более 80% сжатия по сравнению с моделями полной точности.

- Согласованность производительности: Модель сохраняет производительность на уровне моделей полной точности при значительно меньших требованиях к памяти.

- Масштабируемость: Архитектура Bi-Mamba позволяет эффективно обучать модели различных размеров с конкурентоспособными результатами.

- Устойчивость к бинаризации: Выборочная бинаризация линейных модулей предотвращает снижение производительности.

Заключение

Bi-Mamba представляет собой важный шаг вперёд в решении задач масштабируемости и эффективности больших языковых моделей. Используя обучение с учетом бинаризации и ключевые архитектурные оптимизации, исследователи продемонстрировали, что модели пространственного состояния могут достигать высокой производительности при экстремальной квантизации.

Как внедрить ИИ в вашу компанию

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта, следуйте этим шагам:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Выберите подходящее решение из множества доступных ИИ.

- Внедряйте ИИ постепенно: начните с малого проекта, анализируйте результаты и KPI.

- На основе полученных данных расширяйте автоматизацию.

Получите помощь

Если вам нужны советы по внедрению ИИ, пишите нам.

Попробуйте ИИ ассистент в продажах, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.