Внедрение двуязычного чат-ассистента

В этом руководстве мы реализуем двуязычный чат-ассистент, используя модель Meraj-Mini от Arcee AI. Ассистент будет развернут на Google Colab с использованием GPU T4, демонстрируя возможности открытых языковых моделей и предлагая практический опыт в развертывании передовых AI-решений с использованием бесплатных облачных ресурсов.

Необходимые инструменты

- Модель Meraj-Mini от Arcee

- Библиотека Transformers для загрузки модели и токенизации

- Accelerate и bitsandbytes для эффективной квантизации

- PyTorch для вычислений глубокого обучения

- Gradio для создания интерактивного веб-интерфейса

Шаги по реализации

1. Включение GPU-ускорения

Начните с включения GPU-ускорения и установки необходимых библиотек:

!nvidia-smi --query-gpu=name,memory.total --format=csv !pip install -qU transformers accelerate bitsandbytes !pip install -q gradio

2. Настройка модели

Далее, настройте параметры для 4-битной квантизации и загрузите модель:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM, pipeline, BitsAndBytesConfig

quant_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.float16,

bnb_4bit_use_double_quant=True

)

model = AutoModelForCausalLM.from_pretrained(

"arcee-ai/Meraj-Mini",

quantization_config=quant_config,

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("arcee-ai/Meraj-Mini")

3. Создание чат-пайплайна

Настройте пайплайн для генерации текста, подходящий для чат-взаимодействий:

chat_pipeline = pipeline(

"text-generation",

model=model,

tokenizer=tokenizer,

max_new_tokens=512,

temperature=0.7,

top_p=0.9,

repetition_penalty=1.1,

do_sample=True

)

4. Определение функций чата

Создайте две функции для управления чат-взаимодействиями:

def format_chat(messages):

prompt = ""

for msg in messages:

prompt += f"<|im_start|>{msg['role']}n{msg['content']}<|im_end|>n"

prompt += "<|im_start|>assistantn"

return prompt

def generate_response(user_input, history=[]):

history.append({"role": "user", "content": user_input})

formatted_prompt = format_chat(history)

output = chat_pipeline(formatted_prompt)[0]['generated_text']

assistant_response = output.split("<|im_start|>assistantn")[-1].split("<|im_end|>")[0]

history.append({"role": "assistant", "content": assistant_response})

return assistant_response, history

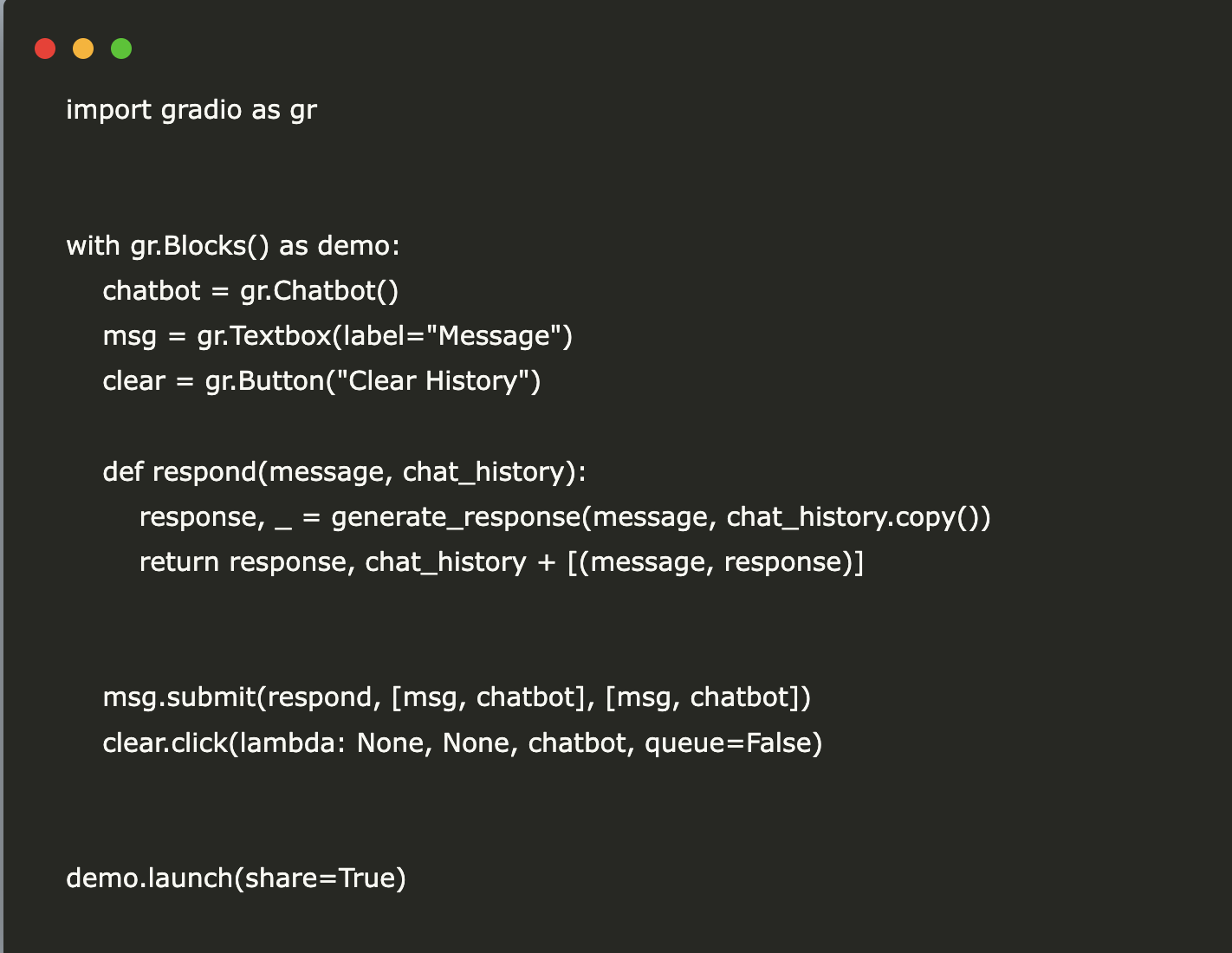

5. Создание интерфейса чата

Наконец, создайте пользовательский интерфейс для чата с помощью Gradio:

import gradio as gr

with gr.Blocks() as demo:

chatbot = gr.Chatbot()

msg = gr.Textbox(label="Message")

clear = gr.Button("Clear History")

def respond(message, chat_history):

response, _ = generate_response(message, chat_history.copy())

return response, chat_history + [(message, response)]

msg.submit(respond, [msg, chatbot], [msg, chatbot])

clear.click(lambda: None, None, chatbot, queue=False)

demo.launch(share=True)

Следующие шаги

Изучите, как AI может трансформировать ваши бизнес-процессы. Найдите возможности для автоматизации и определите ключевые показатели эффективности (KPI) для оценки результативности ваших AI-решений. Начните с небольших проектов, собирайте данные и постепенно расширяйте использование AI.

Контакты

Если вам нужна дополнительная помощь в управлении AI в вашем бизнесе, свяжитесь с нами:

- Email: hello@itinai.ru

- Telegram: ITinAI Telegram

- X: ITinAI X Profile

- LinkedIn: ITinAI LinkedIn