Проявление памяти: динамические механизмы памяти в языковых моделях на основе трансформеров

Улучшение памяти в языковых моделях

Исследования показывают, что языковые модели на основе трансформеров обладают удивительными языковыми способностями. Они используют запоминание на основе входных данных, отличаясь от человека, который хранит информацию в памяти. Ученые активно работают над улучшением способности моделей к запоминанию путем увеличения контекста и внедрения внешних систем памяти. Эти усовершенствования позволяют моделям сохранять информацию долгосрочно, что важно для развития их применений в искусственном интеллекте.

Использование Универсальной Теоремы Приближения

Исследователи из Гонконгского Политехнического университета применяют Универсальную Теорему Приближения для объяснения памяти в языковых моделях на основе трансформеров. Они предполагают, что память LLM, названная «памятью Шрёдингера», проявляется только при запросе и иначе остается неопределенной. Используя эту теорему, ученые утверждают, что LLM динамически аппроксимирует прошлую информацию на основе входных сигналов, что напоминает работу памяти. Исследование предлагает новый метод оценки способностей памяти LLM и сравнивает их с памятью и способностью рассуждения у людей, выявляя как сходства, так и различия.

Базис глубокого обучения и память в моделях на основе трансформеров

Универсальная Теорема Приближения лежит в основе глубокого обучения и объясняет работу памяти в моделях на основе трансформеров. Она утверждает, что нейронные сети могут аппроксимировать любую непрерывную функцию. В моделях трансформеров этот принцип применяется динамически на основе входных данных. Слои трансформера настраивают свои параметры по мере обработки информации, что позволяет модели адаптироваться к различным входам. Механизм многоголового внимания способствует эффективной обработке и сохранению информации, позволяя LLM проявлять возможности, схожие с памятью, и использовать прошлые данные при ответе на запросы.

Исследование способностей памяти LLM

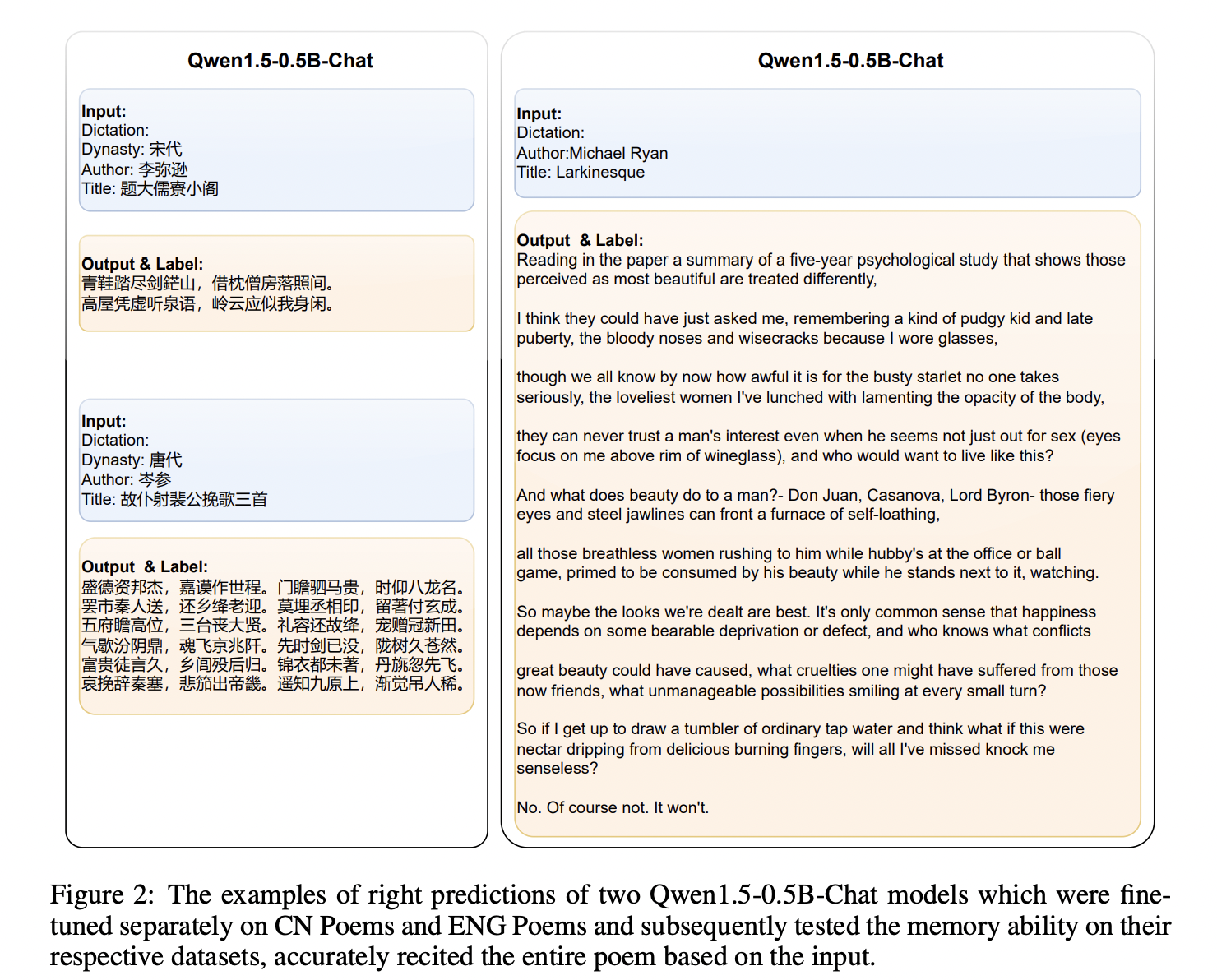

Исследование анализирует способности памяти LLM. Память определяется как процесс, требующий как входные, так и выходные данные. LLM проявляет память, подбирая выходные данные к соответствующим входным, аналогично работе человеческой памяти. Эксперименты на китайских и английских поэтических наборах данных показали, что более крупные модели с лучшим пониманием языка показывали значительно лучшие результаты. Увеличение длины входного текста снижало точность памяти, указывая на корреляцию между длиной ввода и производительностью памяти.

Параллели между памятью человека и LLM

Исследование утверждает, что LLM обладает способностями к памяти и рассуждениям, аналогичными человеческому мышлению. Подобно людям, LLM динамически генерирует выходные данные на основе изученных знаний, не храня фиксированную информацию. Ученые предполагают, что мозг человека и LLM функционируют как динамические модели, которые адаптируются к входам, способствуя креативности и гибкости. Ограничения в рассуждениях LLM связаны с размером модели, качеством данных и архитектурой. Динамический механизм подгонки мозга, проиллюстрированный случаями, например, Генри Молейзона, позволяет непрерывному обучению, креативности и инновациям, что аналогично потенциалу LLM для сложных рассуждений.

Заключение

Исследование демонстрирует, что LLM, поддерживаемые своей архитектурой на основе трансформеров, обладают способностями к памяти, аналогичными человеческому мышлению. Память LLM, названная «памятью Шрёдингера», проявляется только при определенных запросах, отражая динамичную адаптивность по Универсальной Теореме Приближения. Исследование подтверждает память LLM через эксперименты и сравнивает ее с функционированием мозга человека, находя параллели в динамике их реакций. Исследование указывает на то, что память LLM функционирует подобно человеческой памяти, проявляясь только через конкретные запросы, и исследует сходства и различия между когнитивными процессами человека и LLM.