DCMAC: Demand-Aware Customized Communication for Efficient Multi-Agent Reinforcement Learning

Описание и Практическое Применение

Коллаборативное обучение с подкреплением многих агентов (MARL) стало мощным подходом в различных областях, таких как управление светофорами, робототехника и сети датчиков. Однако MARL сталкивается с существенными проблемами из-за сложных взаимодействий между агентами, что вносит нестационарность в среду. Для преодоления этих вызовов и обеспечения эффективного взаимодействия агентов в динамических и сложных средах исследователи разработали метод DCMAC.

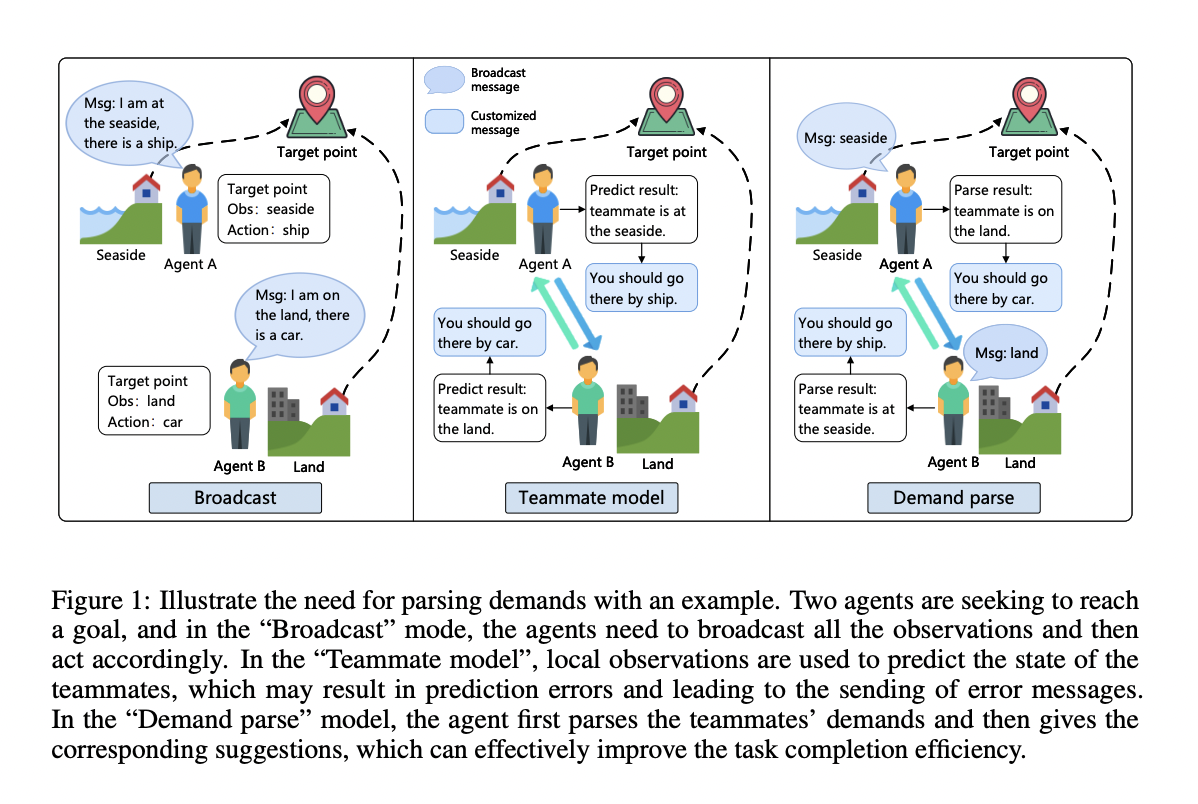

DCMAC оптимизирует использование ограниченных коммуникационных ресурсов, снижает неопределенность обучения и улучшает сотрудничество агентов в системах обучения с подкреплением многих агентов. Этот метод позволяет агентам транслировать краткие сообщения, которые затем анализируются для понимания потребностей партнеров, что влияет на их Q-значения на основе локальной информации и воспринимаемых потребностей.

DCMAC демонстрирует эффективность через эксперименты в различных средах, показывая способность достигать производительности, сравнимой с алгоритмами без ограничений в общении, превосходя их в сценариях с ограничениями в общении.

Архитектура DCMAC включает три основных модуля: генерация крошечных сообщений, анализ потребностей партнеров и генерация настраиваемых сообщений. Методика начинается с извлечения признаков из наблюдений с использованием механизма самоорганизации для минимизации избыточной информации.

DCMAC представляет собой инновационную парадигму обучения, основанную на верхней границе максимального возврата, чередующуюся между режимом обучения и режимом тестирования. Этот подход направлен на облегчение эффективной коммуникации в ограниченных ресурсах, решая ключевые проблемы в многих агентных системах.

DCMAC представляет собой решение для эффективного сотрудничества в разнообразных и сложных задачах обучения с подкреплением многих агентов, превосходя существующие методы и предлагая надежное решение.