«`html

Важность оптимизации использования графических процессоров для обучения крупных языковых моделей

Проблема

Крупные языковые модели (LLM) стали важным инструментом в машинном обучении, и эффективное использование графических процессоров (GPU) в этой области представляет значительный интерес. Однако существующие метрики, такие как утилизация GPU, не всегда точно отражают вычислительную эффективность.

Решения

Для повышения эффективности обучения LLM инженеры предлагают использовать альтернативные метрики, такие как MFU (Model FLOPS Utilization), предложенные в Google’s PaLM paper. Эти метрики позволяют более точно оценить производительность GPU и оптимизировать вычислительные задачи.

Компания Trainy AI преуспела в достижении 100% утилизации GPU и улучшении производительности путем применения рекомендованных методов оптимизации для PyTorch, включая настройку параметров загрузчика данных, использование многослоеных оптимизаторов и тренировочных техник специально разработанных для таких задач.

Дополнительно важно отметить, что решения по оптимизации неравномерно распределены между слоями, что требует комбинирования нескольких слоев в одно ядро и замены нативных определений слоев PyTorch на ядра для GPU, реализованные в CUDA или Triton.

Результаты

Оптимизация позволила ускорить время обучения в 4 раза и увеличить использование Model FLOPS до 38%. Это свидетельствует о значительных улучшениях в производительности и использовании вычислительных ресурсов.

Заключение

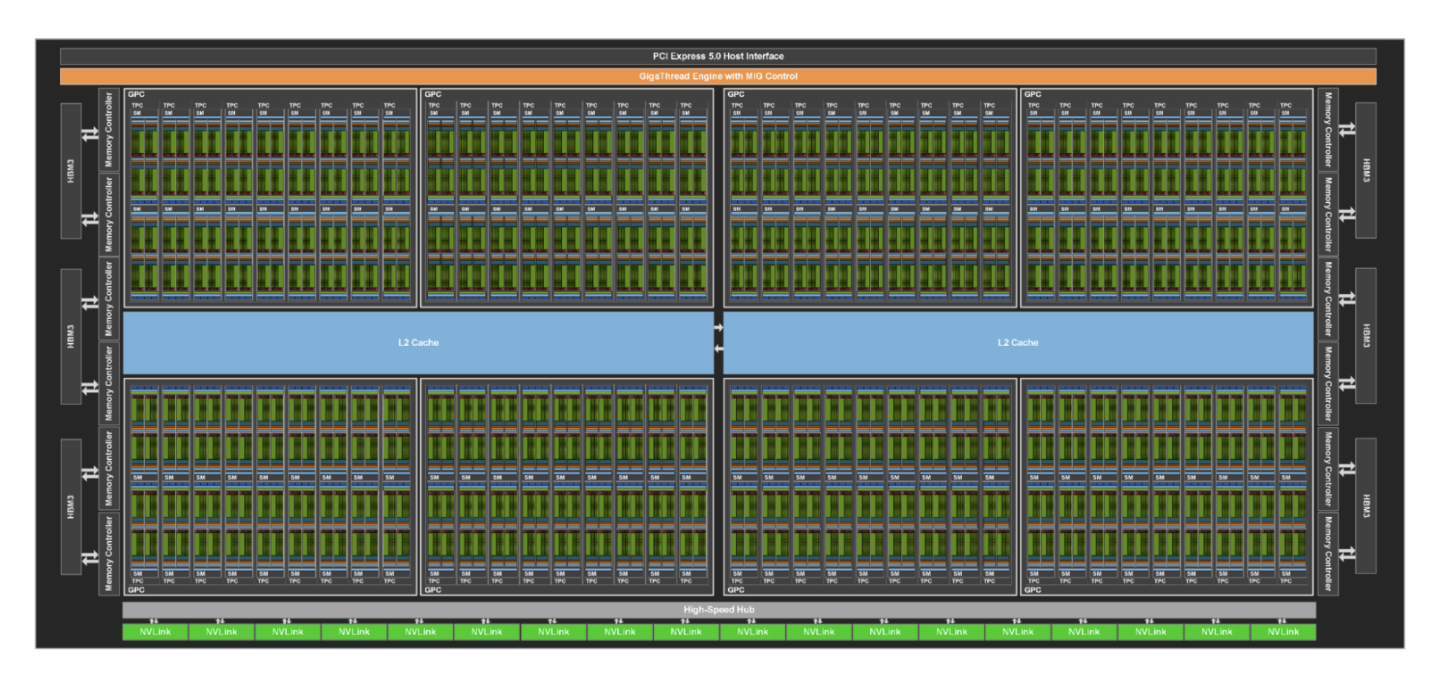

Для более точной оценки производительности рекомендуется отслеживать эффективность SM (Streaming Multiprocessor) и утилизацию GPU на кластерах GPU. При этом следует учитывать, что расчет MFUs является сложным процессом и требует тщательного мониторинга.

Обращайтесь к специалистам по внедрению ИИ в свой бизнес, используйте пошаговый подход к автоматизации и экспериментируйте с решениями, чтобы достичь значимых улучшений в производительности и эффективности вашего предприятия.

«`