LightLLM: Решение для развертывания крупных языковых моделей в ограниченных средах

Большие языковые модели (LLM) значительно продвинулись за последние годы, однако их применение в реальном мире ограничено из-за высоких требований к вычислительной мощности и памяти. Для решения этой проблемы был разработан эффективный, масштабируемый и легковесный фреймворк для вывода LLM — LightLLM.

Оптимизация LightLLM

LightLLM использует методы оптимизации, такие как квантизация, обрезка и дистилляция, чтобы сделать LLM более доступными на устройствах с ограниченными ресурсами. Эти техники позволяют уменьшить размер модели, сохраняя при этом ее производительность.

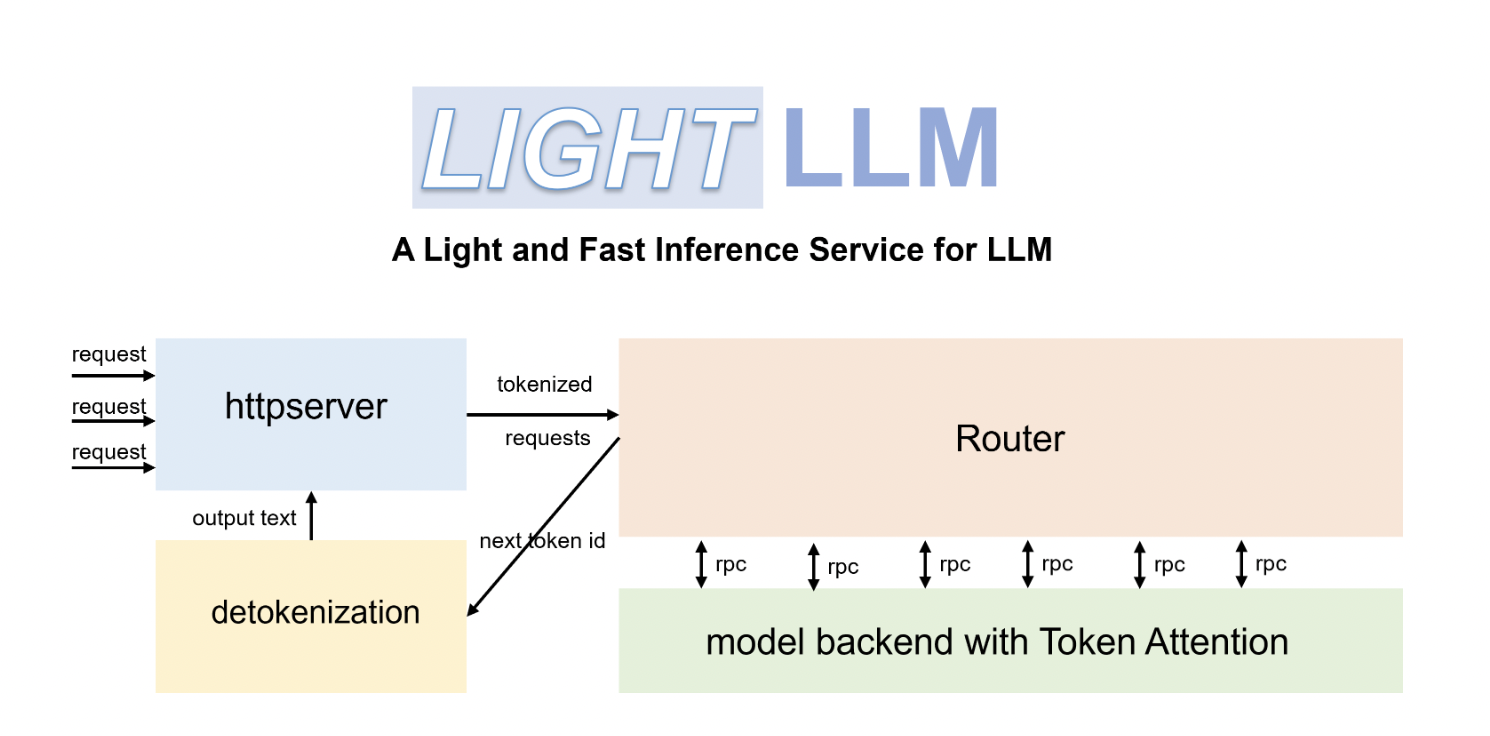

Компоненты LightLLM

Архитектура LightLLM включает несколько компонентов, включая загрузчик моделей, движок вывода, модули оптимизации и интерфейс аппаратного обеспечения, обеспечивая высокую производительность в терминах скорости вывода и использования ресурсов.

Практическое применение ИИ

Используя LightLLM, вы можете расширить возможности своих приложений на устройствах с ограниченной вычислительной мощностью, что делает его ценным инструментом для разработчиков. LightLLM предлагает эффективный и масштабируемый фреймворк для вывода LLM, что открывает новые возможности для применения ИИ.

Применение ИИ в вашем бизнесе

Анализ возможностей ИИ

Оцените, как искусственный интеллект может улучшить вашу работу и где можно автоматизировать процессы для выгоды клиентов.

Выбор ключевых показателей эффективности

Определите KPI, которые вы хотите улучшить с помощью ИИ.

Внедрение ИИ постепенно

Выберите подходящее решение и начните с малого проекта, анализируя результаты и постепенно расширяя автоматизацию на основе данных и опыта.

Для консультаций по внедрению ИИ обращайтесь к нам на Telegram: flycodetelegram

Используйте ИИ ассистент в продажах от Flycode.ru для ответов на вопросы клиентов, генерации контента и снижения нагрузки на первую линию.

Изучите, как решения от Flycode.ru могут изменить ваши процессы с помощью искусственного интеллекта.