«`html

Новый подход к ускорению обучения нейронных сетей через взаимодействие нейронов и прогнозирование

В области глубокого обучения оптимизация нейронных сетей давно является ключевой областью внимания. Обучение больших моделей, таких как трансформеры и сверточные сети, требует значительных вычислительных ресурсов и времени. Исследователи ищут передовые методы оптимизации, чтобы сделать этот процесс более эффективным.

Проблема длительного времени обучения

Одна из центральных проблем в этой области — это продолжительное время, необходимое для обучения сложных нейронных сетей. Традиционные методы оптимизации, такие как Adam, все еще требуют множества итераций, и хотя они очень эффективны в настройке параметров, в целом процесс остается длительным для моделей большого масштаба. Оптимизация процесса обучения критически важна для более быстрого и эффективного развертывания приложений ИИ.

Решение: NINO

Исследователи из Samsung’s SAIT AI Lab, Concordia University, Université de Montréal и Mila представили новый подход, известный как Neuron Interaction and Nowcasting (NINO) networks. Этот метод направлен на значительное сокращение времени обучения путем прогнозирования будущего состояния параметров сети. Вместо применения оптимизации на каждой итерации, как это делают традиционные методы, NINO использует обучаемую функцию для периодического прогнозирования будущих обновлений параметров. Путем интеграции нейронных графов, NINO может делать редкие, но очень точные прогнозы. Этот периодический подход снижает вычислительную нагрузку, сохраняя при этом точность, особенно в сложных архитектурах, таких как трансформеры.

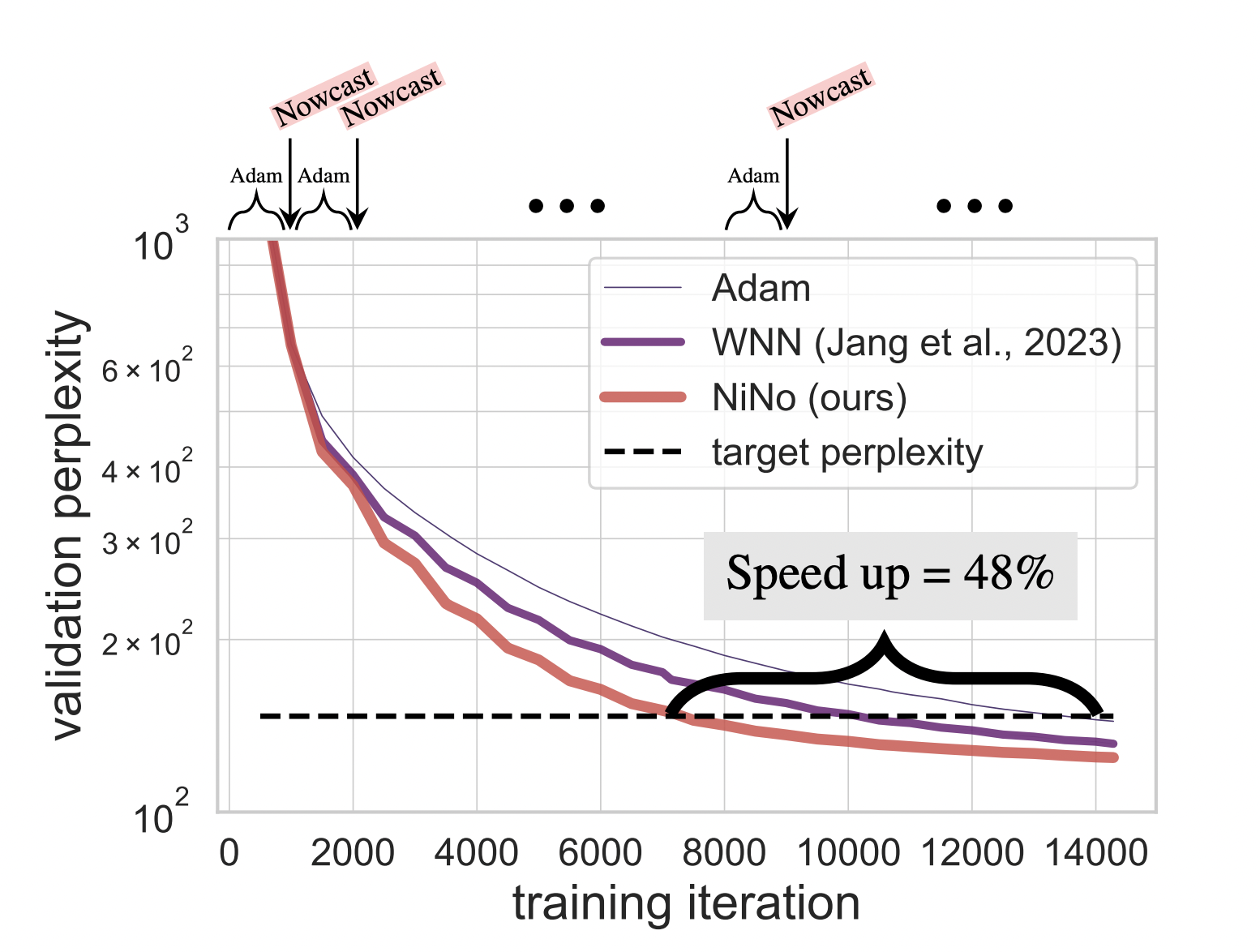

В центре методологии NINO лежит его способность использовать связь между нейронами через графовые нейронные сети (GNNs). Традиционные оптимизаторы, такие как Adam, обрабатывают обновления параметров независимо, не учитывая взаимодействия между нейронами. NINO, однако, использует нейронные графы для моделирования этих взаимодействий, делая прогнозы о будущих параметрах сети, отражая внутреннюю структуру сети. Исследователи улучшили метод Weight Nowcaster Networks (WNN), включив в него моделирование взаимодействия нейронов. Это позволяет NINO применяться на различных этапах обучения без постоянной переобучения, что делает его подходящим для различных нейронных архитектур, включая задачи компьютерного зрения и обработки естественного языка.

Эксперименты показали, что NINO значительно превзошел существующие методы, особенно в задачах компьютерного зрения и обработки языка. Например, на одной из задач по обработке языка базовый оптимизатор Adam потребовал 23 500 шагов, чтобы достичь целевой сложности, в то время как NINO достиг того же результата всего за 11 500 шагов. Аналогично, в задаче компьютерного зрения с сверточными нейронными сетями NINO сократил количество шагов с 8 606 до 4 582, что составляет 46,8% сокращение времени обучения. Это сокращение приводит к более быстрому обучению и значительной экономии вычислительных ресурсов.

В заключение, внедрение методологии NINO представляет собой значительное совершенствование оптимизации нейронных сетей. Этот подход ускоряет процесс обучения и открывает двери для более быстрого развертывания моделей ИИ в различных областях.

«`