«`html

Инновационный метод Spectrum для эффективного обучения крупных языковых моделей

Крупные языковые модели (LLM) играют важную роль в обработке естественного языка (NLP), но их обучение требует огромных вычислительных ресурсов и времени, что представляет собой одну из основных проблем для исследователей и разработчиков. Эффективное обучение таких моделей без ущерба для их производительности является ключевым аспектом для расширения доступности и масштабируемости технологии LLM.

Практические решения

Для решения этой проблемы были разработаны несколько методов. Например, метод QLoRA комбинирует адаптацию низкого ранга с квантованием для снижения использования памяти во время обучения, что позволяет настраивать крупные модели на менее мощном оборудовании. Другой подход, LASER, использует отношение сигнал/шум (SNR) для применения низкоранговых приближений к определенным слоям, улучшая производительность модели на определенных задачах без излишних вычислительных затрат.

Исследователи из Cognitive Computations, Arcee.AI и Vago Solutions представили новый метод под названием Spectrum для повышения эффективности обучения LLM. Spectrum выборочно настраивает слои модулей на основе их SNR, замораживая менее информативные модули и направляя вычислительные ресурсы на наиболее важные. Этот подход значительно снижает использование памяти GPU, сохраняя при этом высокую производительность.

Методология Spectrum основана на теории случайных матриц и использует распределение Марченко-Пастура для определения наиболее информативных слоев в модели. Spectrum оптимизирует процесс обучения, фокусируясь на слоях с высоким SNR и снижая потребность в обширных вычислительных ресурсах.

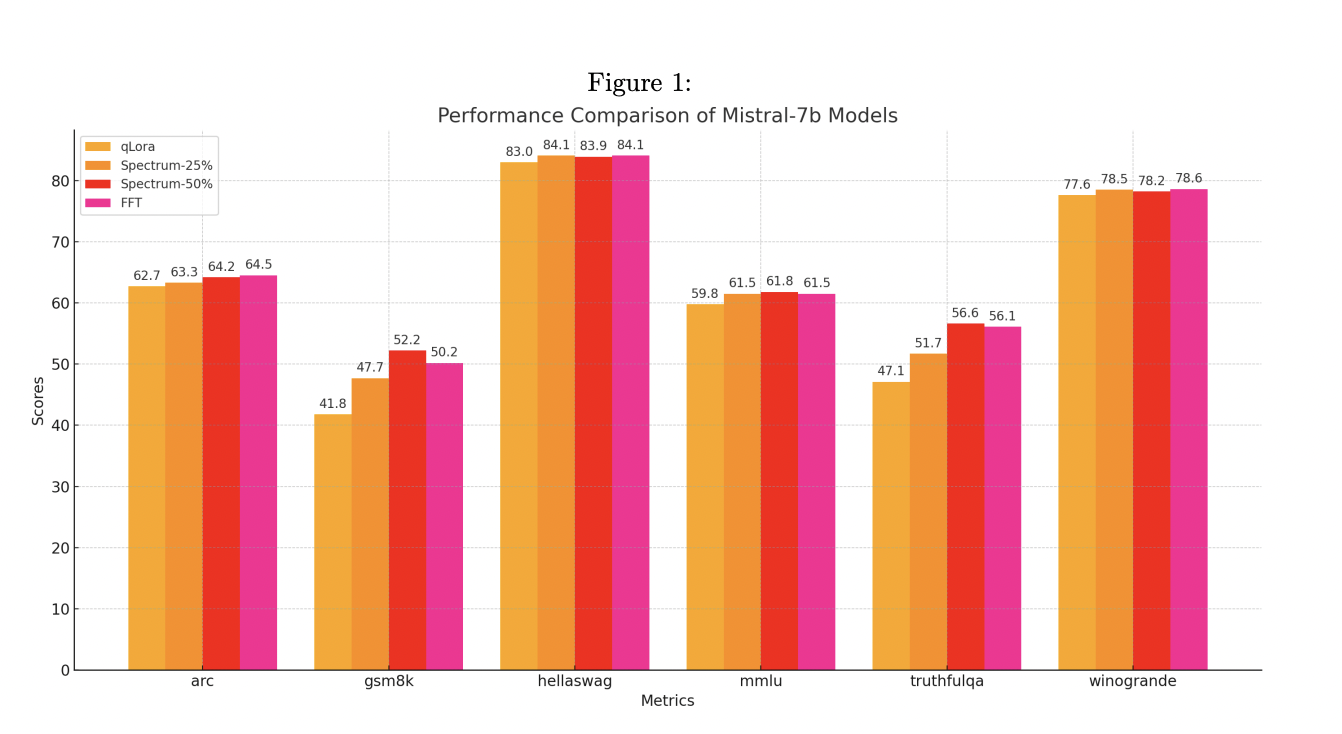

Исследователи провели эксперименты с использованием пяти моделей Llama 3 8B и оценили их на различных бенчмарках. Модели, обученные с помощью Spectrum, продемонстрировали конкурентоспособную производительность, часто соответствуя или превосходя результаты полностью настроенных моделей. Кроме того, Spectrum показал эффективность в распределенных средах обучения с использованием DeepSpeed ZeRO-3, достигнув значительной экономии памяти на GPU.

В заключение, Spectrum предлагает инновационный подход к эффективному обучению крупных языковых моделей. Путем селективной фокусировки на наиболее информативных слоях Spectrum снижает вычислительные затраты и ускоряет процесс обучения без ущерба для производительности модели. Это открытие имеет большой потенциал для демократизации исследований в области LLM и расширения области применения в различных областях.

«`