Революционная мультиязычная модель ИИ XVERSE-MoE-A36B

XVERSE Technology сделала значительный прорыв, выпустив XVERSE-MoE-A36B, крупную мультиязычную языковую модель на основе архитектуры Mixture-of-Experts (MoE). Эта модель выделяется своим впечатляющим масштабом, инновационной структурой, продвинутым подходом к обучению и поддержкой различных языков. Релиз представляет собой переломный момент в языковом моделировании ИИ, выдвигая XVERSE Technology на передовые позиции в инновациях ИИ.

Глубокий анализ архитектуры

XVERSE-MoE-A36B построен на сети трансформера только декодера, хорошо известной архитектуре в языковом моделировании, но вводит улучшенную версию подхода Mixture-of-Experts. Общий масштаб параметров модели составляет поразительные 255 миллиардов, с активированным подмножеством 36 миллиардов параметров, которые задействуются в процессе использования. Этот механизм селективной активации отличает архитектуру MoE от традиционных моделей.

Впечатляющие языковые возможности

Одним из ключевых преимуществ XVERSE-MoE-A36B являются его мультиязычные возможности. Модель обучена на масштабном качественном наборе данных более чем на 40 языках, с акцентом на китайский и английский. Это обеспечивает выдающиеся результаты в этих двух языках и хорошую производительность в различных других языках, включая русский, испанский и другие.

Инновационная стратегия обучения

Разработка XVERSE-MoE-A36B включала несколько инновационных подходов к обучению. Один из наиболее заметных аспектов стратегии обучения модели — ее динамический механизм переключения данных. Этот процесс включал периодическое переключение набора данных для динамического введения новых высококачественных данных. Благодаря этому модель могла непрерывно совершенствовать свое понимание языка, адаптируясь к постоянно изменяющимся лингвистическим образцам и контенту в данных, с которыми она сталкивалась.

Преодоление вычислительных препятствий

Обучение и развертывание модели такого масштаба, как XVERSE-MoE-A36B, представляет существенные вычислительные вызовы, особенно в отношении потребления памяти и накладных расходов на связь. XVERSE Technology решила эти проблемы с помощью стратегий перекрытия вычислений и коммуникаций наряду с техниками CPU-Offload. Путем разработки оптимизированного оператора слияния и учета уникальной логики маршрутизации экспертов и расчета веса модели MoE разработчики смогли значительно улучшить вычислительную эффективность.

Производительность и бенчмаркинг

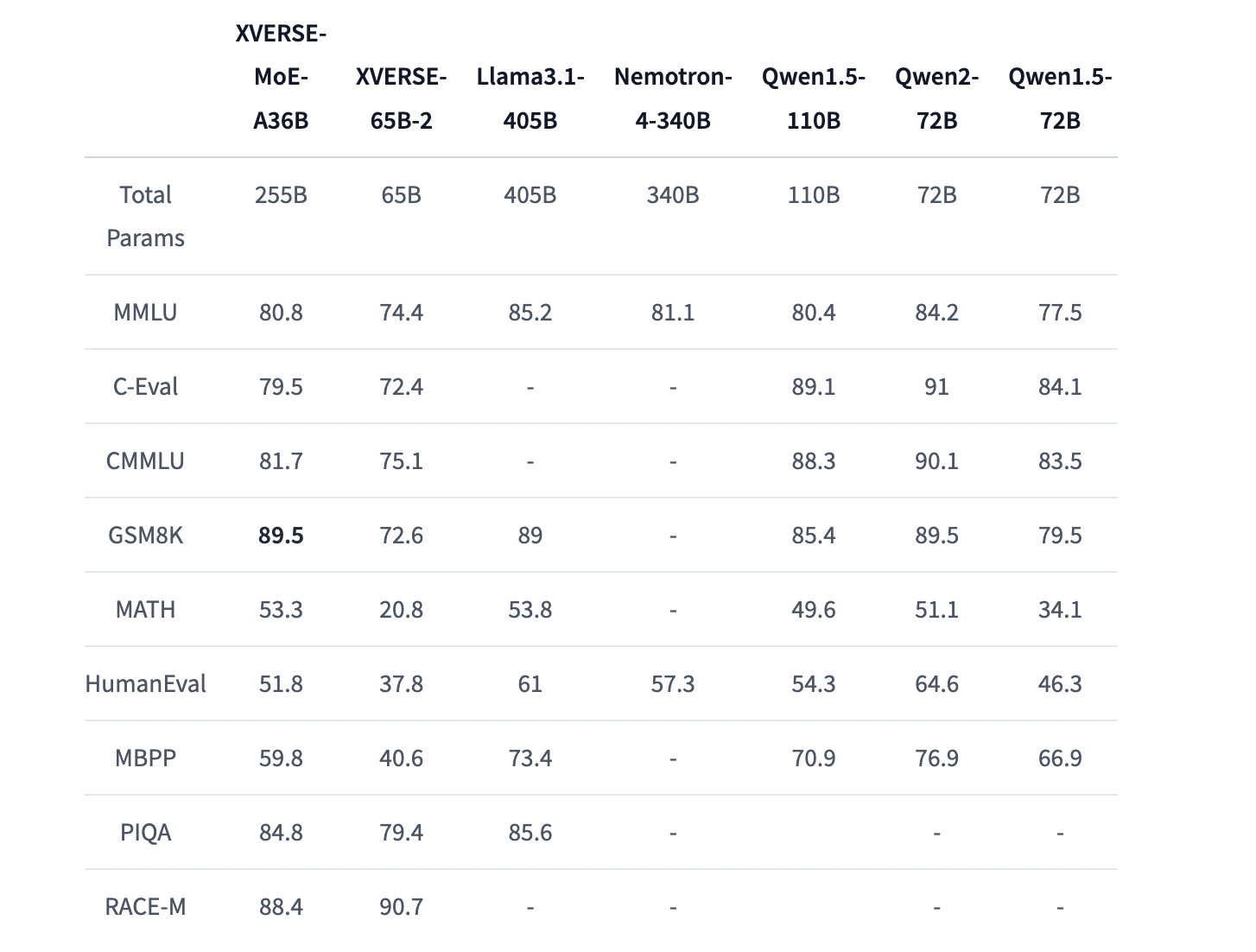

Для оценки производительности XVERSE-MoE-A36B было проведено обширное тестирование по нескольким широко признанным бенчмаркам, включая MMLU, C-Eval, CMMLU, RACE-M, PIQA, GSM8K, Math, MBPP и HumanEval. Модель была сравнена с другими открытыми моделями MoE схожего масштаба, и результаты были впечатляющими. XVERSE-MoE-A36B последовательно превзошел многих своих конкурентов, достигнув лучших результатов в задачах общего понимания языка и специализированного математического рассуждения.

Приложения и потенциальные области применения

Модель XVERSE-MoE-A36B предназначена для различных приложений, от понимания естественного языка до продвинутых AI-ориентированных разговорных агентов. Благодаря своим мультиязычным возможностям, она обладает особым потенциалом для бизнеса и организаций, работающих на международных рынках, где необходимо общение на нескольких языках.

Этические соображения и ответственное использование

Как и все крупные языковые модели, выпуск XVERSE-MoE-A36B несет этические обязательства. XVERSE Technology подчеркнула важность ответственного использования, особенно в избегании распространения вредного или предвзятого контента.

Заключение

Релиз XVERSE-MoE-A36B является значительным событием в развитии крупных языковых моделей. Он предлагает новаторские архитектурные инновации, стратегии обучения и мультиязычные возможности. XVERSE Technology вновь продемонстрировала свое стремление к развитию области ИИ, предоставляя мощный инструмент для бизнеса, исследователей и разработчиков.