«`html

Преимущества архитектуры SAMBA в области языкового моделирования

Большие языковые модели (LLM) сталкиваются с проблемами в захвате сложных долгосрочных зависимостей и достижении эффективной параллелизации для масштабного обучения. Модели, основанные на внимании, доминируют в архитектуре LLM из-за их способности решать эти проблемы. Однако они борются с вычислительной сложностью и экстраполяцией на более длинные последовательности. Модели пространства состояний (SSM) появились как многообещающая альтернатива, предлагая линейную вычислительную сложность и потенциал для лучшей экстраполяции. Несмотря на эти преимущества, SSM борются с воспроизведением памяти из-за их марковской природы и менее конкурентоспособны в задачах связанных с извлечением информации по сравнению с моделями, основанными на внимании.

Исследователи пытались объединить модели пространства состояний (SSM) и механизмы внимания, чтобы использовать преимущества обоих подходов. Однако эти гибридные модели не достигли экстраполяции неограниченной длины с линейной сложностью времени. Существующие техники обобщения длины, разработанные для механизмов внимания, имеют ограничения, такие как квадратичная вычислительная сложность или ограниченная способность экстраполяции контекста. Несмотря на эти усилия, ни одно решение не смогло успешно решить все проблемы одновременно.

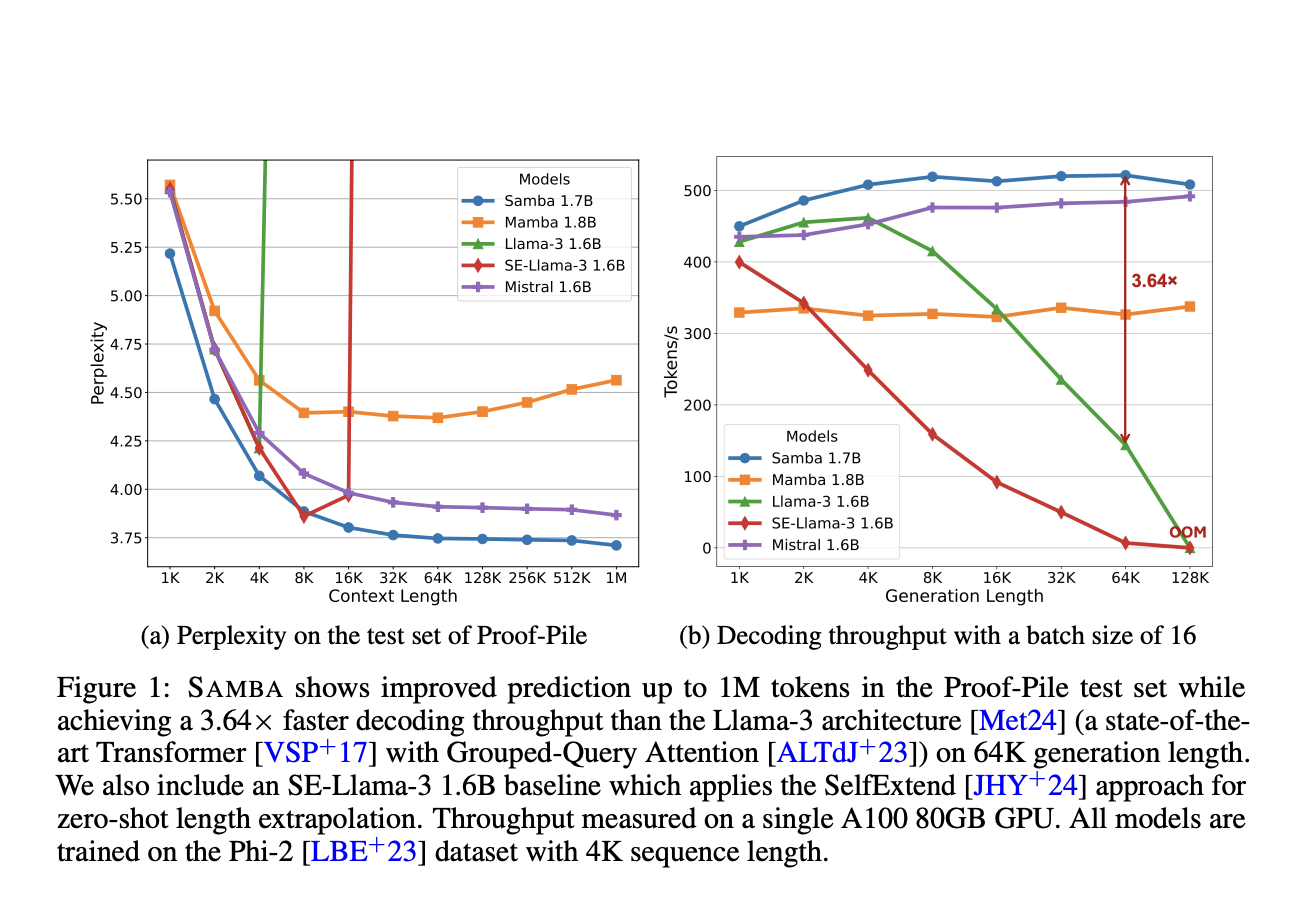

Исследователи из Microsoft и Университета Иллинойса в Урбане-Шампейне представляют SAMBA, простую нейронную архитектуру, которая гармонизирует преимущества как SSM, так и моделей, основанных на внимании, достигая экстраполяции последовательности неограниченной длины с линейной сложностью времени. Архитектура SAMBA включает слои Mamba, SwiGLU и Sliding Window Attention (SWA). Слои Mamba захватывают зависимости от времени и обеспечивают эффективное декодирование, в то время как SWA моделирует сложные, не марковские зависимости.

Применение в реальном мире

Архитектура SAMBA представляет значительное совершенствование в языковом моделировании, объединяя преимущества механизмов внимания и моделей пространства состояний. Ее гибридная архитектура демонстрирует превосходную производительность на различных бенчмарках, превосходя чисто механизмы внимания и модели, основанные на SSM. Способность SAMBA эффективно обрабатывать контекст произвольной длины, в сочетании с его удивительными возможностями экстраполяции памяти, делает его особенно подходящим для реальных приложений, требующих глубокого понимания контекста.

Оптимальный баланс между вниманием и рекуррентными структурами в архитектуре приводит к мощной и эффективной модели, расширяющей границы языкового моделирования и предлагающей многообещающие решения для сложных задач обработки естественного языка.

«`