«`html

Использование DiT-MoE для улучшения процессов с помощью искусственного интеллекта

Недавно модели диффузии стали мощными инструментами в различных областях, таких как генерация изображений и 3D-объектов. Их успех обусловлен способностью эффективно обрабатывать задачи денойзинга с различными типами шума, преобразуя случайный шум в целевое распределение данных через повторяющиеся шаги денойзинга. Используя структуры на основе трансформаторов, было показано, что добавление большего количества параметров обычно улучшает производительность. Однако обучение и выполнение этих моделей затратны. Это связано с тем, что глубокие сети плотные, что означает, что каждый пример использует все параметры, что приводит к высоким вычислительным затратам по мере их масштабирования.

Практические решения и ценность

Текущий метод, Условный Расчет, является многообещающей техникой масштабирования, которая направлена на увеличение объема модели при сохранении постоянных затрат на обучение и вывод. Это достигается путем использования только подмножества параметров для каждого примера. Еще один метод, Смесь Экспертов (MoEs), объединяет результаты подмоделей или экспертов через вход зависимый маршрутизатор и успешно использовался в различных областях. В области NLP было представлено топ-k маршрутизация в LSTMs, вместе с вспомогательными потерями для сохранения баланса экспертов. Наконец, в MoEs для моделей диффузии были проведены исследования с использованием нескольких экспертных моделей, каждая из которых фокусируется на определенном диапазоне временных интервалов.

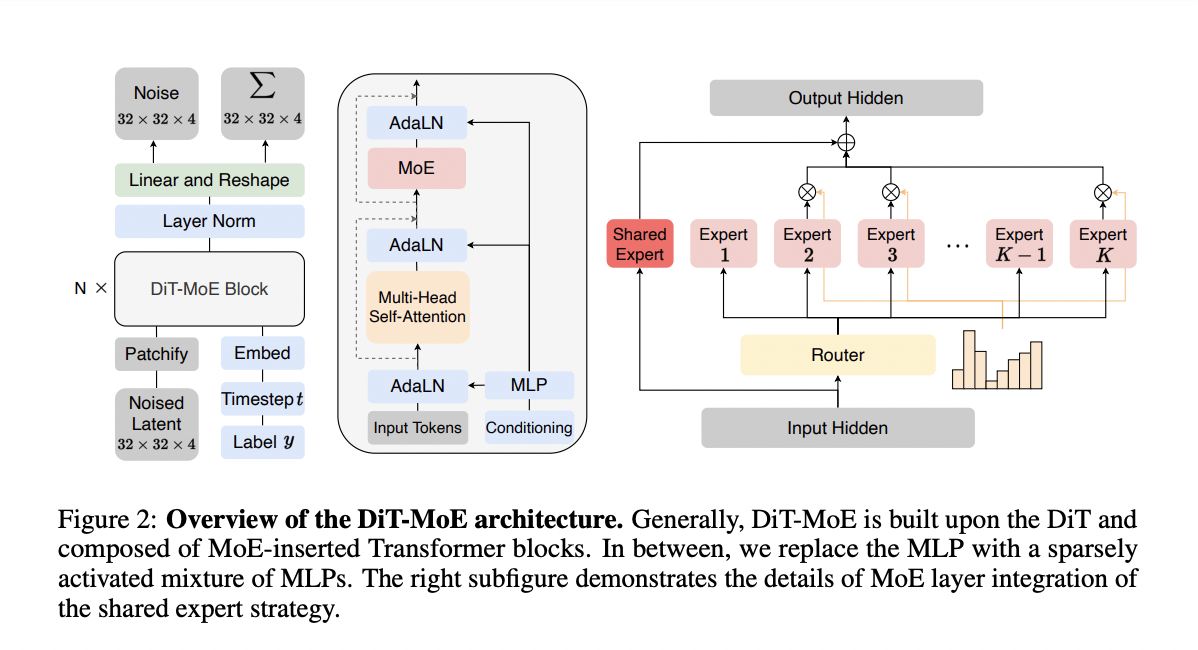

Исследователи из Kunlun Inc. Пекин, Китай, предложили DiT-MoE, новую версию архитектуры DiT для генерации изображений. DiT-MoE модифицирует некоторые плотные слои прямого распространения в DiT, заменяя их разреженными слоями MoE. В этих слоях каждый токен изображения направляется в конкретное подмножество экспертов, которые являются слоями MLP. Кроме того, архитектура включает два основных дизайна, один из которых заключается в совместном использовании части экспертов для улавливания общих знаний, а второй — в балансировке потерь экспертов для уменьшения избыточности в различных маршрутизированных экспертах.

Оптимизатор AdamW используется без уменьшения веса по всем наборам данных с постоянной скоростью обучения. Во время обучения используется экспоненциальное скользящее среднее (EMA) весов DiT-MoE с коэффициентом затухания 0,9999, и результаты основаны на этой модели EMA. Предложенные модели обучаются на графическом процессоре Nvidia A100 с использованием набора данных ImageNet различных разрешений. Кроме того, во время обучения применяются техники, такие как классификация без руководства, и используется предварительно обученная модель вариационного автокодировщика от Stable Diffusion на huggingface2. Производительность генерации изображений оценивается с использованием расстояния Фрешера-Инцепшн (FID), общей метрики для оценки качества генерируемых изображений.

Результаты оценки условной генерации изображений по различным метрикам показывают отличную производительность по сравнению с плотными конкурентами. На наборе данных ImageNet 256×256 с условной классификацией модель DiT-MoE достигает оценки FID 1,72, превзойдя все предыдущие модели с различной архитектурой. Кроме того, DiT-MoE использует всего 1,5 миллиарда параметров и значительно превосходит конкурентов на основе трансформаторов, таких как Large-DiT-3B, Large-DiT-7B и LlamaGen-3B. Это показывает потенциал MoE в моделях диффузии. Подобные улучшения видны в почти всех метриках оценки на наборе данных ImageNet 512×512 с условной классификацией.

В заключение, исследователи разработали DiT-MoE, обновленную версию архитектуры DiT для генерации изображений. DiT-MoE улучшает некоторые плотные слои прямого распространения в DiT, заменяя их разреженными слоями MoE. Этот метод использует разреженный условный расчет для обучения больших моделей диффузии трансформаторов, что приводит к эффективному выводу и значительному улучшению задач генерации изображений. Также используются простые дизайны для эффективного использования разреженности модели на основе входных данных. Этот документ представляет начало исследования крупномасштабного условного расчета для моделей диффузии. Будущая работа включает в себя обучение более стабильных и быстрых гетерогенных архитектур экспертов и улучшение дистилляции знаний.

Как ИИ может изменить вашу работу

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте DiT-MoE для генерации изображений. Проанализируйте, как ИИ может изменить вашу работу, определите, где возможно применение автоматизации и на чем вы хотите улучшить свои процессы с помощью ИИ. Подберите подходящее решение и внедряйте его постепенно, начиная с небольших проектов и анализируя результаты.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram. Попробуйте ИИ ассистент в продажах от Flycode.ru, который помогает автоматизировать взаимодействие с клиентами и улучшить процессы продаж.

Узнайте, как ИИ от Flycode.ru может изменить ваши бизнес-процессы и улучшить эффективность вашей компании.

«`