Исследование AI: Llama-3-8B-Instruct-80K-QLoRA

Недавние достижения в области обработки естественного языка (NLP) значительно повлияли на машинный перевод, чат-ботов и автоматический анализ текста. Однако, ряд проблем, таких как поддержание контекста в длинных разговорах и вычислительная сложность моделей, требует разработки эффективных и способных понимать и сохранять контекст на протяжении длинных текстовых последовательностей.

Решение: Llama-3-8B-Instruct-80K-QLoRA

Исследователи из Китая представили модель, которая значительно увеличивает длину контекста с 8K до 80K токенов. Она обладает улучшенными механизмами внимания и инновационными стратегиями обучения, что делает ее способной обрабатывать более длинные контексты с меньшими вычислительными требованиями.

Результаты и преимущества

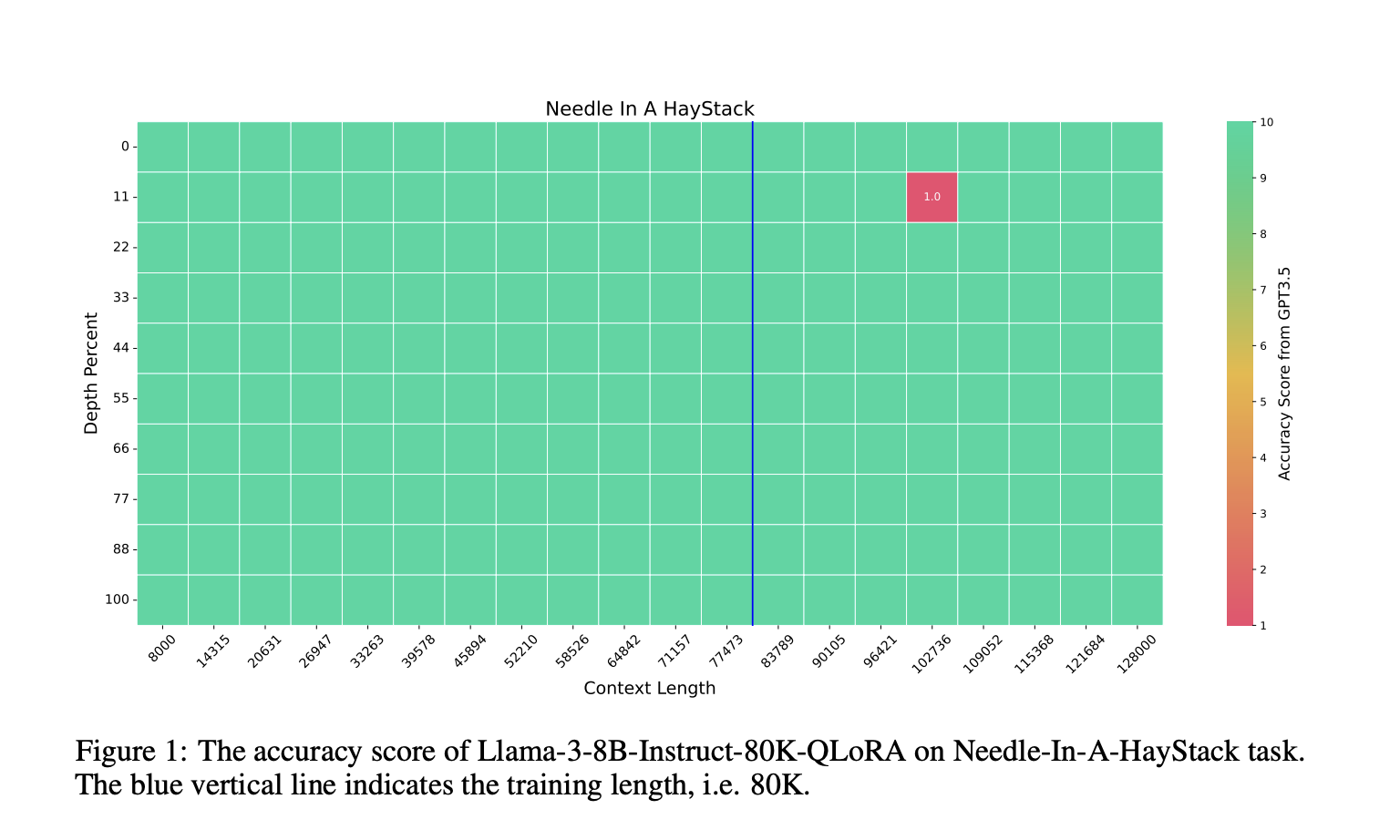

Модель показала 100% точность в задаче Needle-In-A-Haystack и превзошла другие модели в бенчмарках LongBench и InfBench. Также она продемонстрировала конкурентоспособные результаты на MMLU бенчмарке, подчеркивая свою способность эффективно обрабатывать задачи с длинным контекстом.

Практическое применение

Эта модель открывает новые горизонты в области понимания языка и предлагает эффективное решение для обработки длинных текстовых последовательностей. Она может быть использована в различных приложениях, требующих продвинутого понимания языка.

Контакты

Для консультаций по внедрению ИИ обращайтесь к нам в Telegram: flycodetelegram. Также вы можете ознакомиться с нашими решениями и преимуществами на сайте Flycode.ru.