Революционные техники адаптеров: Sparse High Rank Adapters (SHiRA) компании Qualcomm AI для эффективного и быстрого внедрения в большие языковые модели

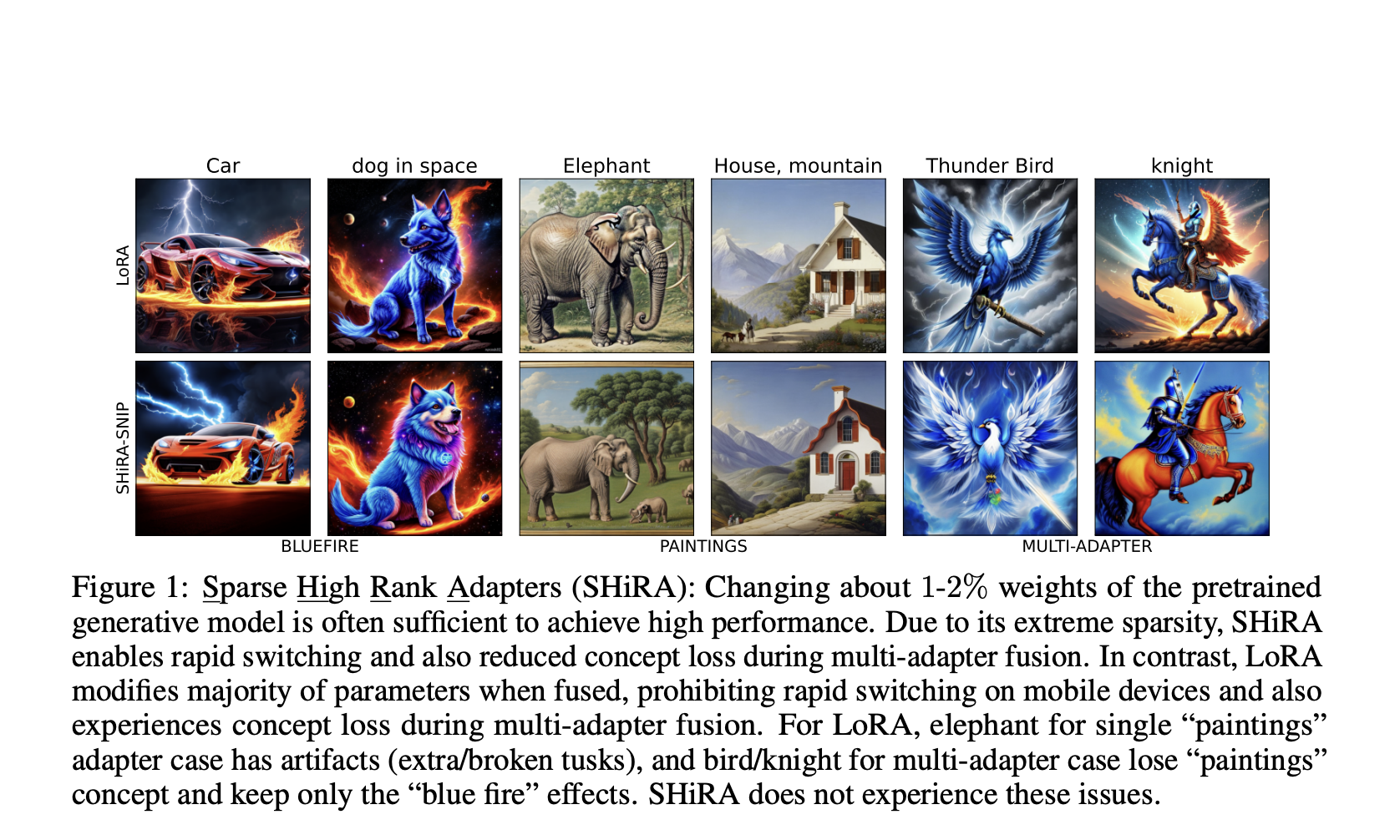

Одной из значительных проблем в развертывании больших языковых моделей (LLM) и моделей с латентными переменными (LVM) является балансировка низких накладных расходов на вывод с возможностью быстрого переключения адаптеров. Традиционные методы, такие как Low Rank Adaptation (LoRA), либо объединяют параметры адаптера с весами базовой модели, теряя возможность быстрого переключения, либо содержат параметры адаптера отдельно, что сопряжено с значительной задержкой.

Дополнительно существующие методы имеют проблемы с потерей концепций при одновременном использовании нескольких адаптеров. Решение этих проблем критично для развертывания моделей ИИ в ресурсоемких средах, таких как мобильные устройства, и обеспечения надежной производительности в различных областях применения.

Решение проблем

Исследователи из Qualcomm AI предлагают Sparse High Rank Adapters (SHiRA) — сильно разреженную структуру адаптеров, которая модифицирует только 1-2% весов базовой модели. Эта структура позволяет быстрое переключение, минимизируя количество весов, которые необходимо обновлять, и смягчает потерю концепций благодаря своей разреженной структуре.

Практическая ценность

SHiRA демонстрирует превосходную производительность в экспериментах как на LLM, так и на LVM. Подход снижает задержку вывода и обеспечивает высокую эффективность, что делает его практичным для развертывания в ресурсоемких средах, таких как мобильные устройства. Кроме того, SHiRA показывает значительно лучшие результаты на стилистических датасетах, указывая на превосходное качество генерации изображений.

Выводы

Метод Sparse High Rank Adapters (SHiRA) представляет собой значительное достижение в технике адаптеров для ИИ моделей. SHiRA решает критические проблемы быстрого переключения адаптеров и потери концепций в многозадачной среде, обеспечивая при этом низкую нагрузку на вывод. Этот подход предлагает практичное и эффективное решение для развертывания больших моделей в ресурсоемких средах, продвигая тем самым область исследований и развертывания ИИ.