Jina AI выпустила Reader-LM-0.5B и Reader-LM-1.5B: Революционные модели малых языковых моделей для преобразования HTML в Markdown

Выпуск Reader-LM-0.5B и Reader-LM-1.5B Jina AI является значительным событием в технологии малых языковых моделей (SLM). Эти модели разработаны для решения уникальной и конкретной задачи: преобразование сырого, шумного HTML с открытого веб-сайта в чистый формат markdown. Хотя эта задача кажется простой, она представляет собой сложные вызовы, особенно в обработке большого количества шума в современном веб-контенте, такого как заголовки, подвалы и боковые панели. Серия Reader-LM нацелена на эффективное решение этой проблемы, с упором на экономичность и производительность.

Фон и цель

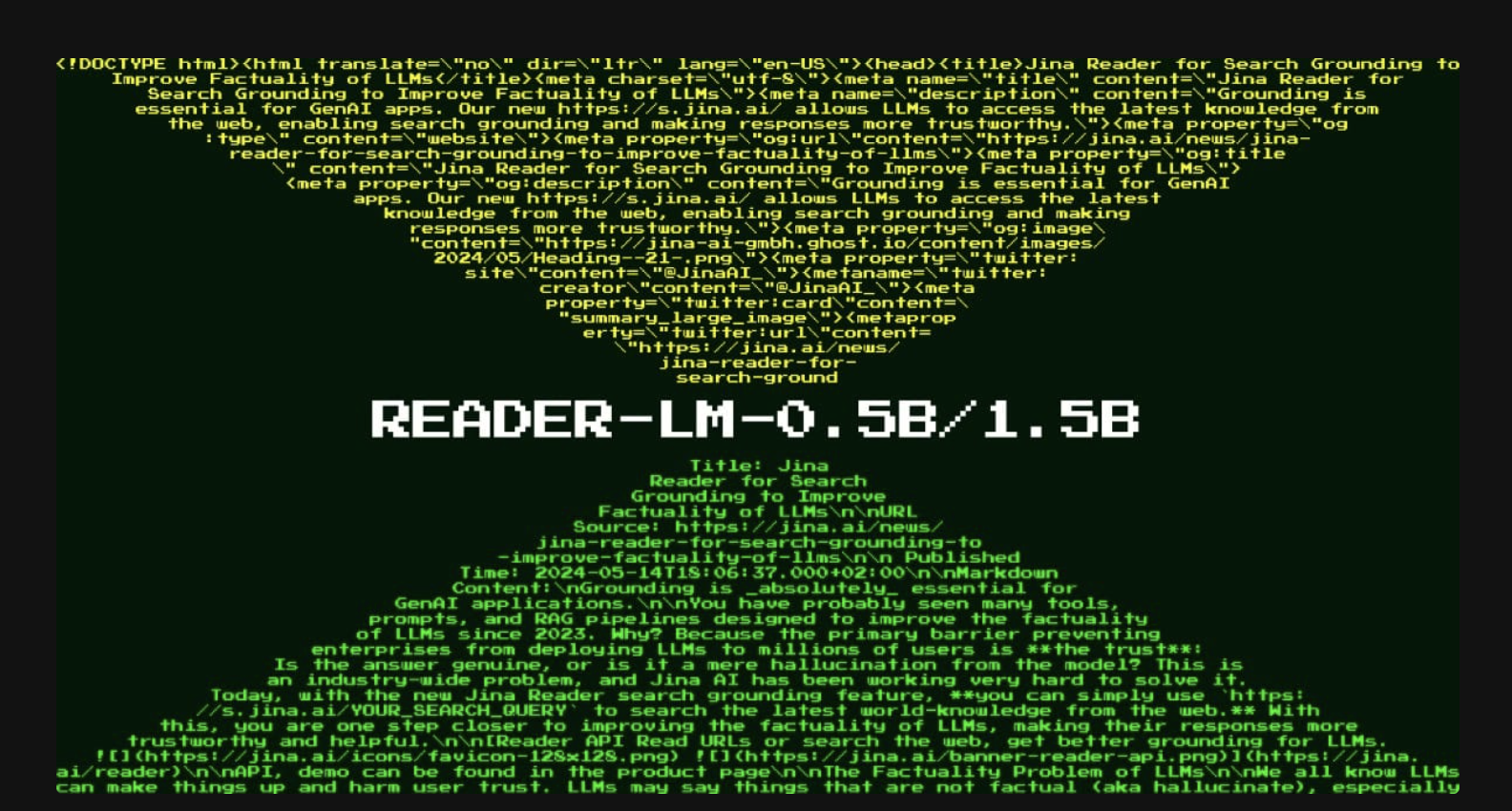

В апреле 2024 года Jina AI представила Jina Reader, API, который преобразует любой URL в markdown, подходящий для больших языковых моделей (LLM). Этот API использует инструменты, такие как пакет Readability от Mozilla, для извлечения основного содержимого веб-страницы, а затем регулярные выражения и библиотеку Turndown для преобразования очищенного HTML в markdown. Однако этот метод столкнулся с проблемами, такими как неправильная фильтрация контента и трудности в преобразовании сложных структур HTML. Получив обратную связь от пользователей, Jina AI поняла, что патчинг существующего конвейера с помощью дополнительных регулярных выражений и эвристик не является устойчивым решением.

Чтобы преодолеть эти ограничения, Jina AI задала важный вопрос: может ли эта проблема быть решена end-to-end с использованием языковой модели? Вместо ручных правил, языковая модель может более эффективно обрабатывать задачу преобразования HTML в markdown, особенно с менее чем миллиардом параметров, что делает ее выполнимой для работы на краю.

Введение моделей Reader-LM

Jina AI выпустила две малые языковые модели: Reader-LM-0.5B и Reader-LM-1.5B. Эти модели обучены специально для преобразования сырого HTML в markdown, и обе поддерживают мультиязычность и контекст длиной до 256 токенов. Эта способность обрабатывать большие контексты критична, поскольку содержимое HTML современных веб-сайтов часто содержит больше шума, чем когда-либо, с встроенным CSS, JavaScript и другими элементами, значительно увеличивающими количество токенов.

В то время как большие языковые модели известны своими высокими вычислительными требованиями, малые языковые модели, такие как Reader-LM, разработаны для обеспечения эффективной производительности без дорогостоящей инфраструктуры. Reader-LM-0.5B и Reader-LM-1.5B превосходят многие более крупные модели в конкретной задаче преобразования HTML в markdown, при этом имея лишь долю их размера.

Архитектура и спецификации

Модели Reader-LM разработаны для обработки входных данных с длинным контекстом и выполнения выборочного копирования из HTML в markdown. Эта задача более проста, чем типичные функции LLM, такие как генерация текста или написание кода. Это поведение выборочного копирования в первую очередь направлено на идентификацию соответствующего контента, пропуская ненужные элементы, такие как боковые панели и заголовки, и форматируя оставшийся контент в синтаксисе markdown.

Спецификации моделей

Reader-LM-0.5B: С 494 миллионами параметров, данная модель включает 24 слоя, 896 скрытых размеров и 14 запросов. Она компактна, но способна эффективно обрабатывать задачу выборочного копирования.

Reader-LM-1.5B: Эта более крупная модель имеет 1,54 миллиарда параметров, 28 слоев, 1536 скрытых размеров и 12 запросов. Она проявляет себя лучше, особенно при работе с более сложными структурами HTML.

Обе модели поддерживают длину контекста до 256 токенов, что критично для обработки часто длинного и шумного HTML-контента, найденного в сети. Их способность обрабатывать мультиязычный контент делает их универсальными инструментами для глобальных приложений.

Производительность и бенчмаркинг

Производительность Reader-LM-0.5B и Reader-LM-1.5B была тщательно оценена по сравнению с несколькими большими языковыми моделями, включая GPT-4o, Gemini-1.5-Flash, LLaMA-3.1-70B и Qwen2-7BInstruct. Модели были протестированы с использованием метрик, таких как ROUGE-L (для задач суммаризации и вопросно-ответной системы), Token Error Rate (TER, который измеряет уровень галлюцинаций контента) и Word Error Rate (WER, который оценивает несоответствия между сгенерированным markdown и оригинальным HTML).

В этих оценках модели Reader-LM превзошли многие более крупные модели в терминах генерации чистого, точного markdown из HTML. Например, Reader-LM-1.5B достигла оценки ROUGE-L 0,72, WER 1,87 и TER 0,19, значительно лучше, чем GPT-4o и другие протестированные модели. Reader-LM-0.5B, хотя и меньше, также показала конкурентоспособные результаты, особенно в задаче сохранения структуры, что важно для преобразования HTML в markdown.

Обучение и разработка

Для обучения моделей Reader-LM требовалось подготовить высококачественные пары данных с сырым HTML и соответствующим markdown. Jina AI сгенерировала эти данные, используя свой существующий API Jina Reader, дополненный синтетическим HTML, сгенерированным GPT-4o для обучения. Итоговый обучающий набор данных содержал примерно 2,5 миллиарда токенов.

Модели обучались в два этапа:

Краткое и простое HTML: На этом этапе использовались до 32 тысяч токенов и 1,5 миллиарда обучающих токенов.

Длинное и сложное HTML: На этом этапе последовательности увеличились до 128 тысяч токенов с 1,2 миллиарда обучающих токенов. Ключевым новшеством на этом этапе было использование механизма «зигзаг-кольцевого внимания», что улучшило обработку длинных контекстов.

Несмотря на сложность преобразования HTML в markdown, модели были оптимизированы для эффективной обработки этой задачи без излишних вычислительных нагрузок. Они используют такие техники, как контрастный поиск, чтобы предотвратить дегенерацию токенов и повторяющиеся циклы во время генерации markdown.

Прикладные возможности

Reader-LM разработан для практического использования как в индивидуальных, так и в корпоративных средах. Модели могут быть легко протестированы с помощью Google Colab, а производственные среды могут использовать платформы, такие как Azure и AWS, где модели скоро будут доступны. Reader-LM лицензирован под CC BY-NC 4.0, с возможностью коммерческого использования для компаний, ищущих решения для работы на собственных серверах.

Модели идеально подходят для автоматизации извлечения и очистки данных с открытого веба в производственных средах. Преобразуя сырой HTML в чистый markdown, Reader-LM обеспечивает эффективную обработку данных, что упрощает для последующих LLM суммирование, рассуждение и получение инсайтов из веб-контента. Кроме того, их мультиязычные возможности расширяют их применимость в различных отраслях и регионах.

Заключение

Выпуск Reader-LM-0.5B и Reader-LM-1.5B представляет собой прорыв в технологии малых языковых моделей, специально разработанных для преобразования HTML в markdown. Эти модели решают критическую потребность в эффективном, экономичном извлечении данных из шумного и часто ошеломляющего веб-контента, характерного для современного интернета. С их компактным размером, поддержкой длинного контекста и мультиязычными возможностями модели Reader-LM предлагают мощный инструмент для разработчиков и предприятий, стремящихся оптимизировать свои рабочие процессы.