Улучшение математического мышления с помощью OmegaPRM

Искусственный интеллект (ИИ) сосредоточен на создании систем, способных выполнять задачи, требующие человеческого интеллекта. Одним из направлений развития в этой области является создание больших языковых моделей (LLM), которые направлены на понимание и генерацию человеческого языка. Они находят применение в переводе, резюмировании и вопросно-ответных системах. Однако сложные многошаговые задачи, такие как решение математических проблем, все еще требуют улучшения для самых передовых LLM. Повышение способности рассуждения этих моделей имеет ключевое значение для улучшения их производительности в таких задачах.

Проблема и ее решение

Одной из основных проблем в области ИИ является улучшение способностей рассуждения LLM, особенно для задач, требующих множественных логических шагов. Текущие модели часто допускают ошибки на промежуточных этапах, что приводит к неправильным окончательным ответам. Решение этих ошибок на промежуточных этапах существенно для улучшения производительности в сложных задачах рассуждения.

Практические методы улучшения

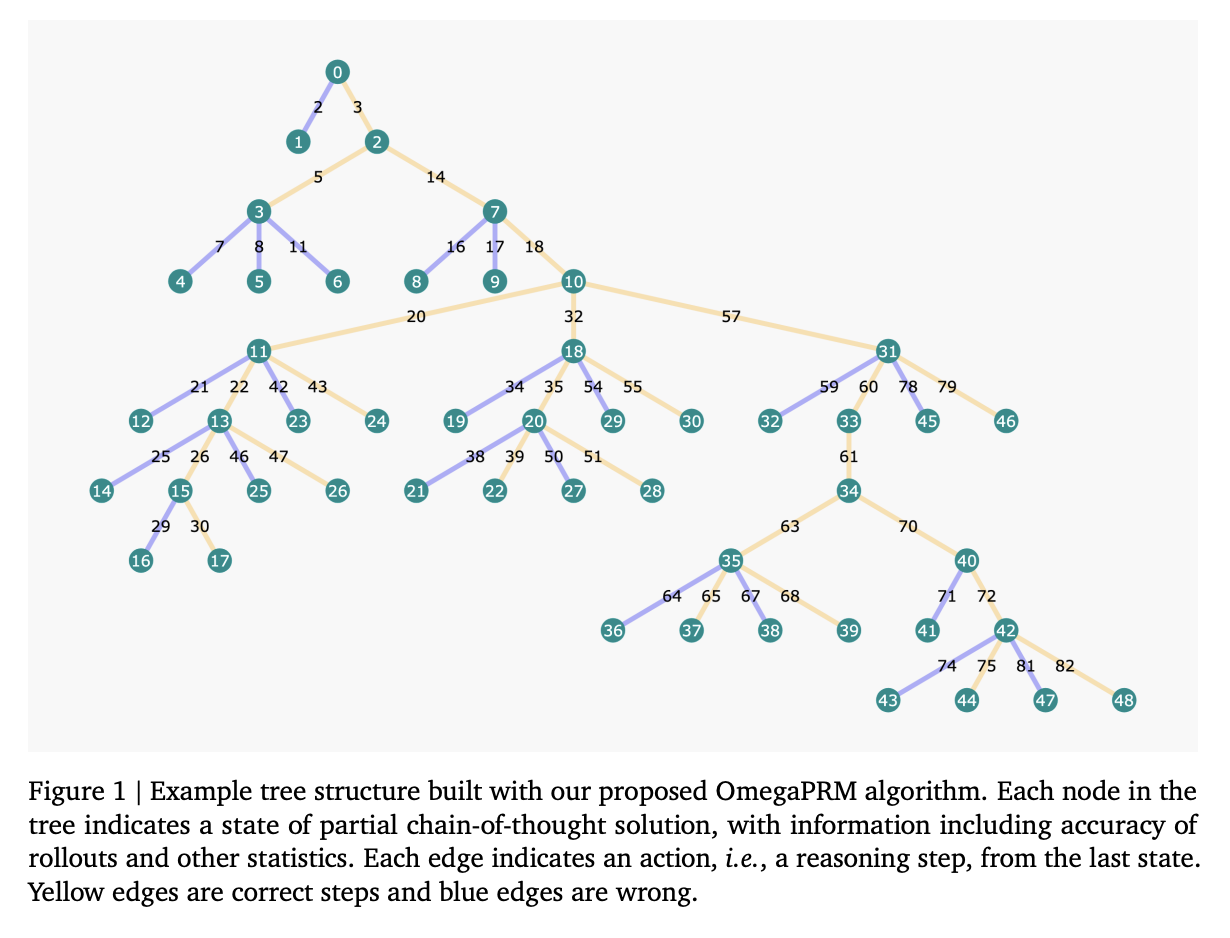

Существующие исследования включают различные методики и модели для улучшения способностей рассуждения LLM. Такие методы, как Chain-of-Thought (CoT) prompting, Outcome Reward Models (ORMs) и Process Reward Models (PRMs), предоставляют обратную связь и направляют модели через каждый шаг рассуждения. Метод OmegaPRM, представленный исследователями из Google DeepMind и Google, представляет собой новый подход к автоматизированному сбору данных для обучения моделей математического рассуждения. Он позволяет значительно снизить затраты на сбор данных по сравнению с методами, требующими человеческого вмешательства.

Результаты и перспективы

Метод OmegaPRM значительно улучшил производительность модели Gemini Pro в математическом рассуждении, что привело к 36% относительному увеличению показателя успешности. Это подчеркивает потенциал OmegaPRM в улучшении способностей LLM в сложных многошаговых задачах рассуждения.