«`html

Современные глубокие нейронные сети (DNN) по своей природе непрозрачны; мы не знаем, как и почему эти компьютеры приходят к своим прогнозам. Это является серьезным препятствием для более широкого использования техник машинного обучения во многих областях. Возникла область изучения под названием Explainable AI (XAI), чтобы прояснить, как DNN принимают решения таким образом, чтобы их могли понять люди.

Практические решения и ценность:

Explainable AI (XAI) расширил свою область изучения, чтобы включить изучение функциональной цели каждого компонента модели для объяснения глобального поведения моделей, вместо простого объяснения того, как DNN принимают решения локально для конкретных входных данных с использованием карт салентности.

Вторым методом глобальной объяснимости является механистическая интерпретация, которая следует за методами, характеризующими конкретные идеи нейронов, базовых вычислительных единиц в нейронной сети, которые они научились распознавать. Это позволяет изучить, как эти общие идеи влияют на прогнозы, сделанные сетью.

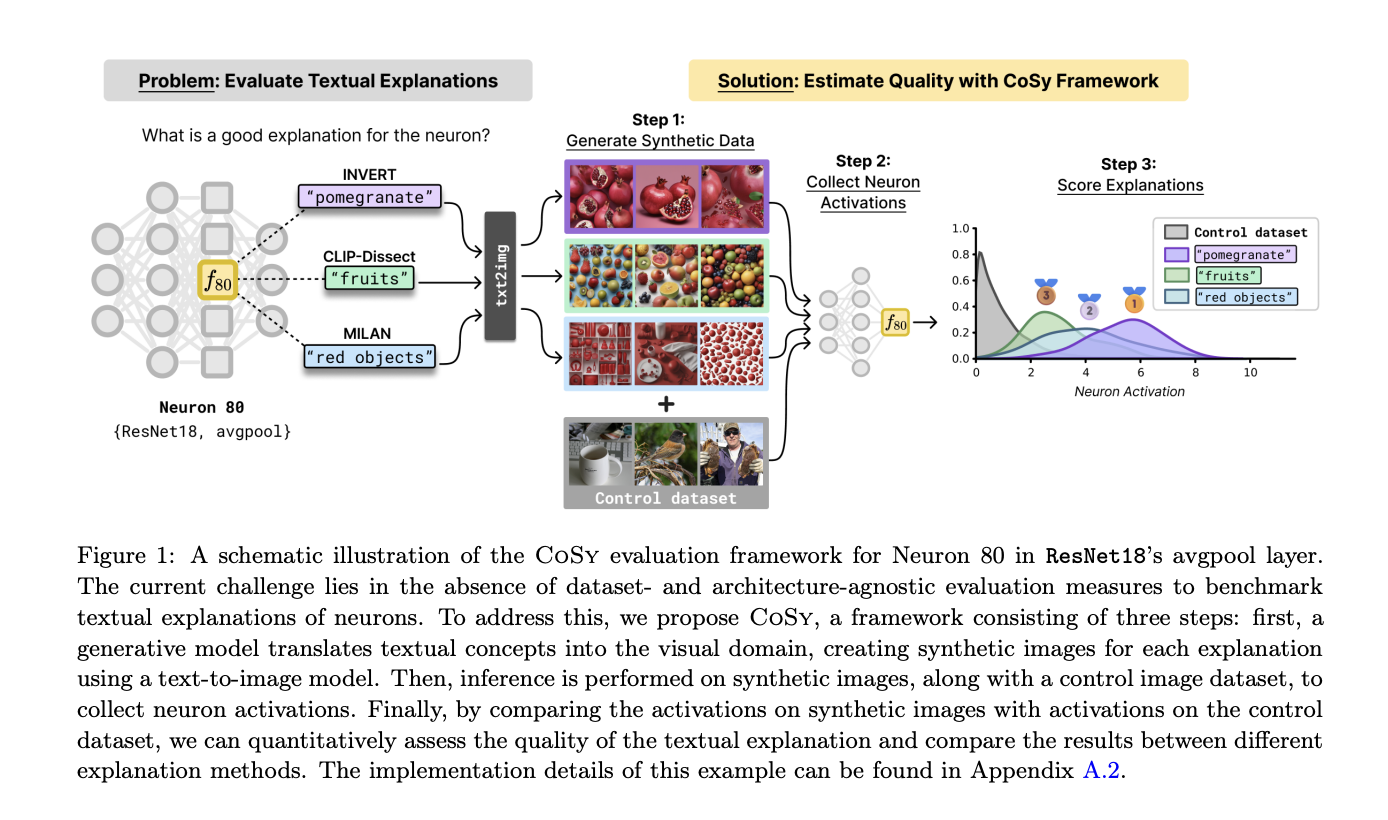

Для заполнения этой ниши исследователи из ATB Potsdam, University of Potsdam, TU Berlin, Fraunhofer Heinrich-Hertz-Institute и BIFOLD представляют CoSy, новаторский количественный метод оценки использования моделями компьютерного зрения (CV) объяснений на основе открытого словаря для нейронов. Этот метод, использующий современные достижения в области генеративного искусственного интеллекта, позволяет создавать синтетические визуальные представления, соответствующие текстовым описаниям концепций.

Проведя тщательный мета-анализ, команда доказала, что CoSy обеспечивает точную оценку объяснений. Исследование показывает, что последние уровни, где происходит обучение высокоуровневых концепций, являются лучшими местами для применения методов объяснений на основе концепций.

Исследователи выделяют, что генеративная модель является основным недостатком CoSy. Они также видят потенциал применения CoSy в различных областях, таких как здравоохранение и обработка естественного языка.

«`