Усовершенствование моделей искусственного интеллекта

LLM (Language Model) в последние годы значительно продвинулся и продемонстрировал впечатляющие возможности в различных задачах. Однако производительность LLM часто ухудшается при работе с длинными входными последовательностями, что затрудняет их применение в областях, требующих обширной обработки информации — например, в суммировании документов, ответах на вопросы и машинном переводе.

Преодоление ограничений и оценка возможностей моделей

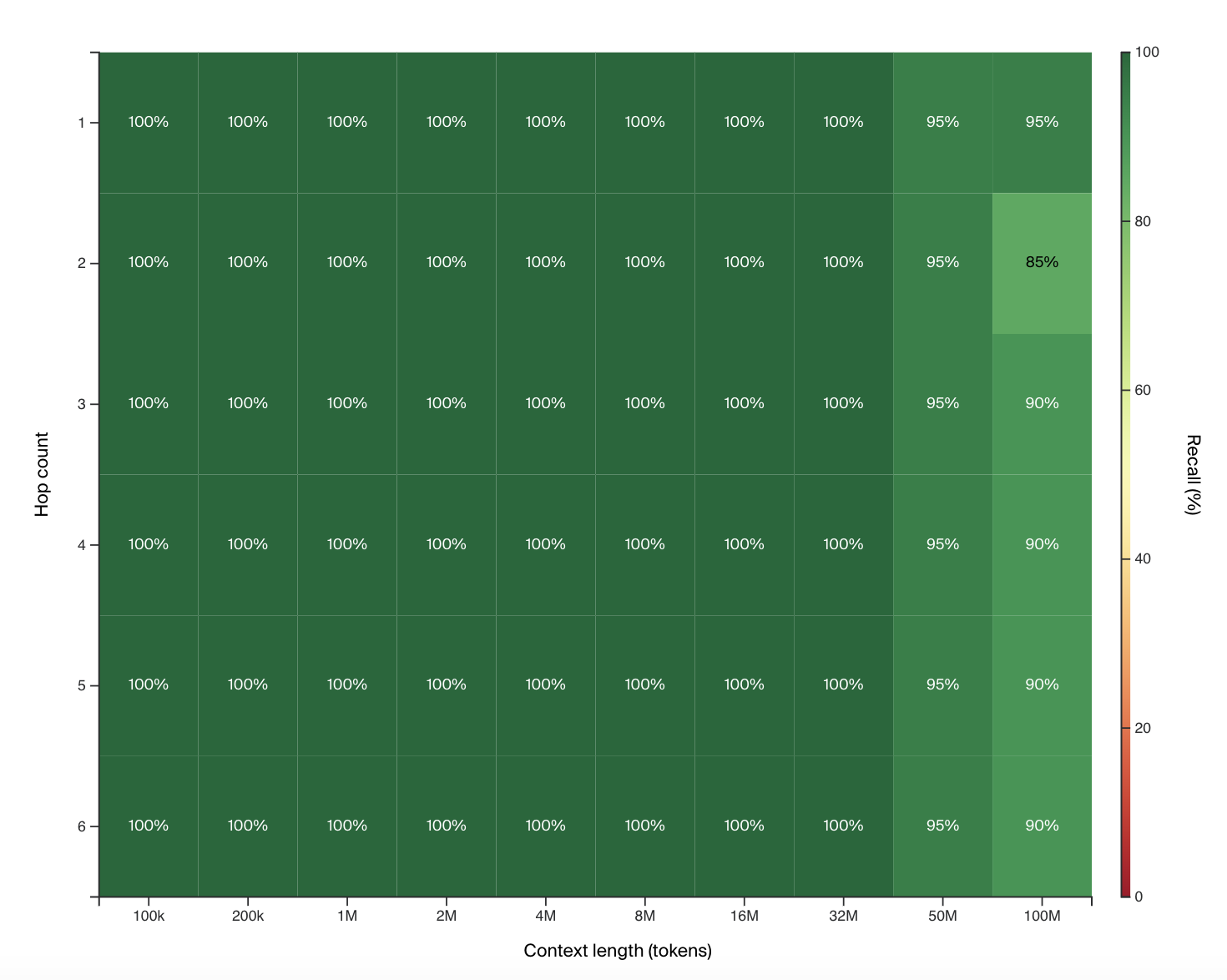

Текущие модели ограничены короткими окнами контекста, что сужает их способность сохранять и использовать большие объемы информации, и приводит к использованию менее точных методов меморизации. Проблему усугубляет недостаточная оценка метрик, неспособных точно измерить возможности модели обрабатывать обширный контекст. Новый инструмент оценки HashHop, разработанный Magic AI Lab, предлагает решение, позволяющее измерить способность модели к воспоминанию и рассуждению через несколько «прыжков» хэш-пар с изменяемым порядком. Эти инновации открывают новые перспективы в области обработки обширного контекста и предлагают эффективное решение для улучшения синтеза кода и других приложений, требующих глубокого контекстного понимания.

Применение практических решений в разработке ПО

Модель LTM-2-mini, разработанная Magic AI Lab, способна обрабатывать до 100 миллионов токенов в контексте, что значительно превосходит существующие модели по эффективности памяти и вычислительной мощности. Это создает новые возможности для приложения в реальных проектах без необходимости больших вычислительных ресурсов.

В заключение, модель LTM-2-mini, оцененная с использованием метода HashHop, представляет собой значительное усовершенствование в способности искусственного интеллекта обрабатывать обширные контексты, особенно в разработке программного обеспечения. Предложенное решение от Magic AI Lab предлагает более надежный и эффективный подход к обработке обширных окон контекста и позволяет преодолеть ограничения существующих моделей и методов оценки.