Практические решения и ценность использования минимальных LSTM и GRU для обучения в параллель

Проблема:

Рекуррентные нейронные сети (RNN) имеют огромное значение в машинном обучении для решения задач, связанных с последовательностями, такими как прогнозирование временных рядов и обработка естественного языка. Однако традиционные RNN часто сталкиваются с проблемами исчезающих и взрывающихся градиентов, что снижает их эффективность для обработки более длинных последовательностей.

Решение:

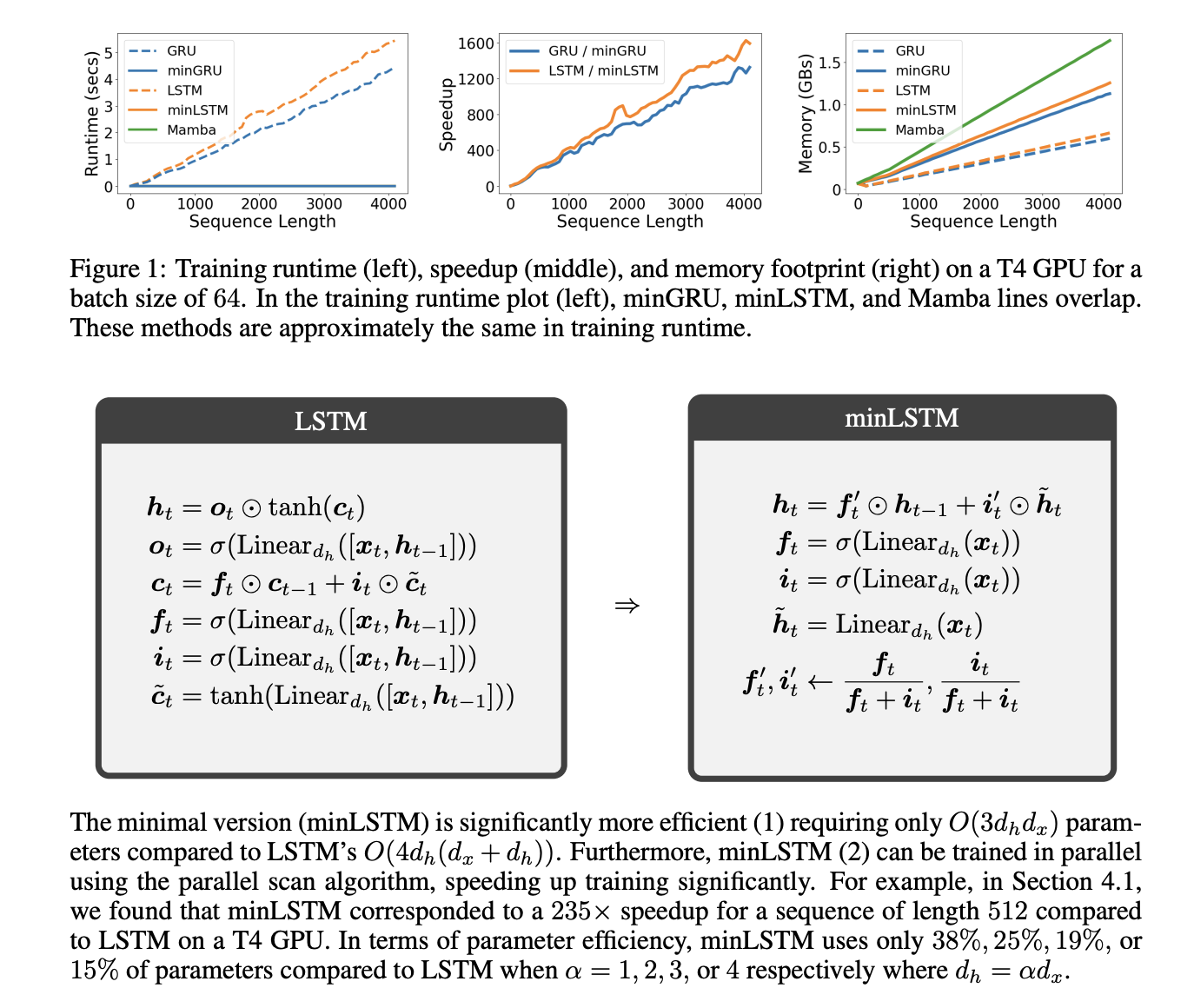

Исследования, проведенные командами Borealis AI и Mila, привели к созданию упрощенных версий LSTM и GRU — minLSTM и minGRU. Эти модели устраняют некоторые сложные механизмы и позволяют проводить обучение в параллель, что значительно повышает эффективность. Они позволяют обрабатывать более длинные последовательности с меньшими вычислительными затратами, делая их конкурентоспособными современным моделям последовательностей.

Ценность:

Минимальные модели LSTM и GRU используют на 33% меньше параметров, чем традиционные RNN, и обучаются до 175 раз быстрее на последовательностях длиной 512. Это позволяет значительно ускорить обучение для реальных приложений, таких как генерация текста и языковое моделирование. Они демонстрируют высокую производительность и эффективность в различных приложениях, включая задачи обучения с подкреплением и языковое моделирование.

Заключение:

Внедрение минимальных LSTM и GRU позволяет эффективно решать проблемы традиционных RNN, сохраняя при этом высокую эмпирическую производительность. Упрощенные модели с параллельным обучением представляют собой жизнеспособную альтернативу сложным современным архитектурам, открывая новые перспективы для исследований и приложений в области машинного обучения.