Разблокирование потенциала многофункциональных языковых моделей (MLLMs) для обработки различных модальностей, таких как речь, текст, изображение и видео, является ключевым шагом в развитии искусственного интеллекта (ИИ).

Это способствует улучшению точности и надежности систем ИИ в таких областях, как понимание естественного языка, рекомендация контента и мультимодальный поиск информации.

Проблема традиционных методов

Традиционные методы обработки мультимодальных задач часто полагаются на плотные модели или подходы с использованием одной модальности. Плотные модели включают все параметры в каждом вычислении, что приводит к увеличению вычислительной нагрузки и уменьшению масштабируемости по мере увеличения размера модели. С другой стороны, подходы с использованием одной модальности лишены гибкости и адаптивности, необходимых для эффективной интеграции и понимания разнообразных мультимодальных данных.

Решение Uni-MoE

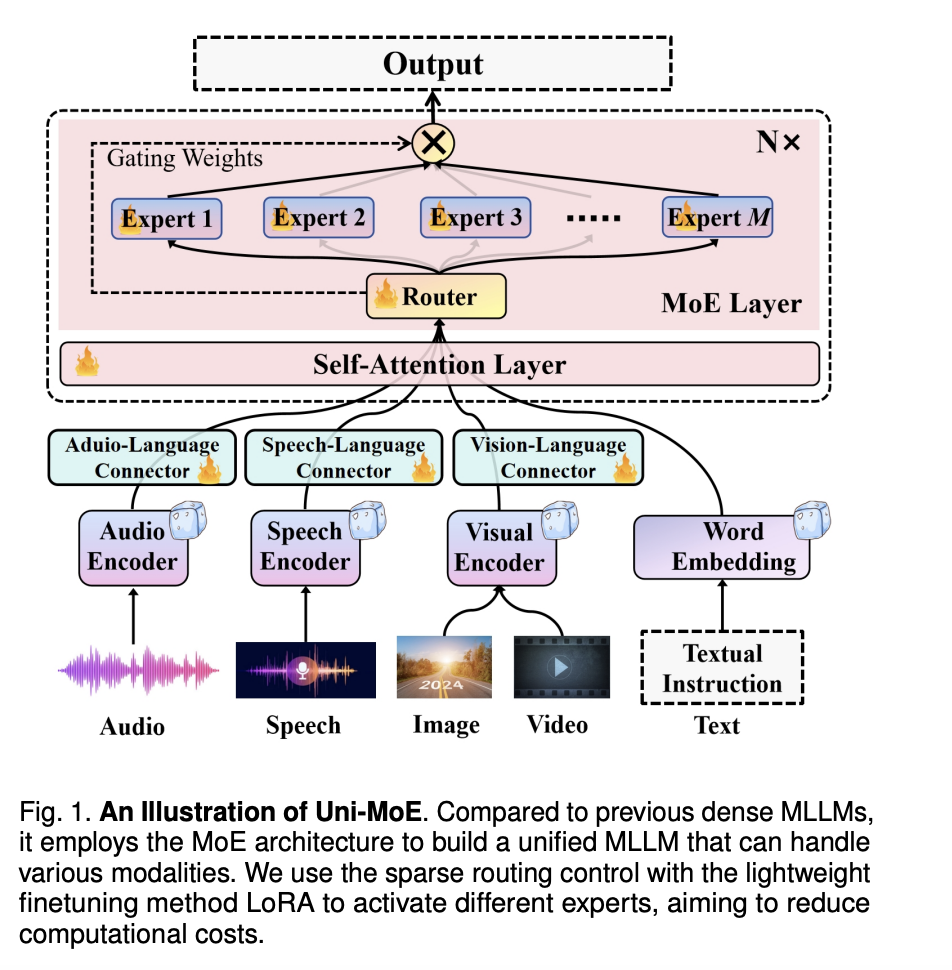

Исследователи из Харбинского института технологии предложили инновационный подход Uni-MoE, который использует архитектуру Mixture of Experts (MoE) вместе со стратегической трехфазной тренировочной стратегией. Uni-MoE оптимизирует выбор и сотрудничество экспертов, позволяя модально-специфическим экспертам синергетически работать для улучшения производительности модели. Трехфазная тренировочная стратегия включает специализированные фазы тренировки для межмодальных данных, что улучшает стабильность, надежность и адаптивность модели.

Результаты показывают превосходство Uni-MoE с показателями точности от 62,76% до 66,46% на оценочных показателях, таких как ActivityNet-QA, RACE-Audio и A-OKVQA. Он превосходит плотные модели, обладает лучшей обобщаемостью и эффективно справляется с задачами понимания длинной речи. Uni-MoE открывает новые возможности для мультимодального обучения, обещая улучшенную производительность, эффективность и обобщаемость для будущих систем ИИ.

Заключение

Uni-MoE представляет собой значительный прорыв в области мультимодального обучения и систем ИИ. Его инновационный подход, основанный на архитектуре Mixture of Experts (MoE) и стратегии трехфазной тренировки, преодолевает ограничения традиционных методов и обеспечивает улучшенную производительность, эффективность и обобщаемость в различных модальностях. Впечатляющие показатели точности на различных оценочных показателях подчеркивают превосходство Uni-MoE в решении сложных задач, таких как понимание длинной речи. Эта передовая технология не только преодолевает существующие проблемы, но также заложит основы для будущих достижений в области мультимодальных систем ИИ, подтверждая свою ключевую роль в формировании будущих технологий ИИ.