HERL (Homomorphic Encryption Reinforcement Learning): Применение подхода на основе обучения с подкреплением, использующего Q-Learning для динамической оптимизации параметров шифрования

Федеративное обучение (FL) — это метод, позволяющий обучать модели машинного обучения на децентрализованных источниках данных, сохраняя при этом конфиденциальность. Этот метод особенно полезен в отраслях, где проблемы конфиденциальности мешают централизации данных, например, в здравоохранении и финансах.

Проблема с Homomorphic Encryption (HE)

Шифрование с сохранением гомоморфности обеспечивает конфиденциальность путем выполнения вычислений над зашифрованными данными без их расшифровки. Однако оно сопряжено с значительными вычислительными и коммуникативными издержками, особенно в средах, где у клиентов различные вычислительные мощности и требования к безопасности.

Решение: Homomorphic Encryption Reinforcement Learning (HERL)

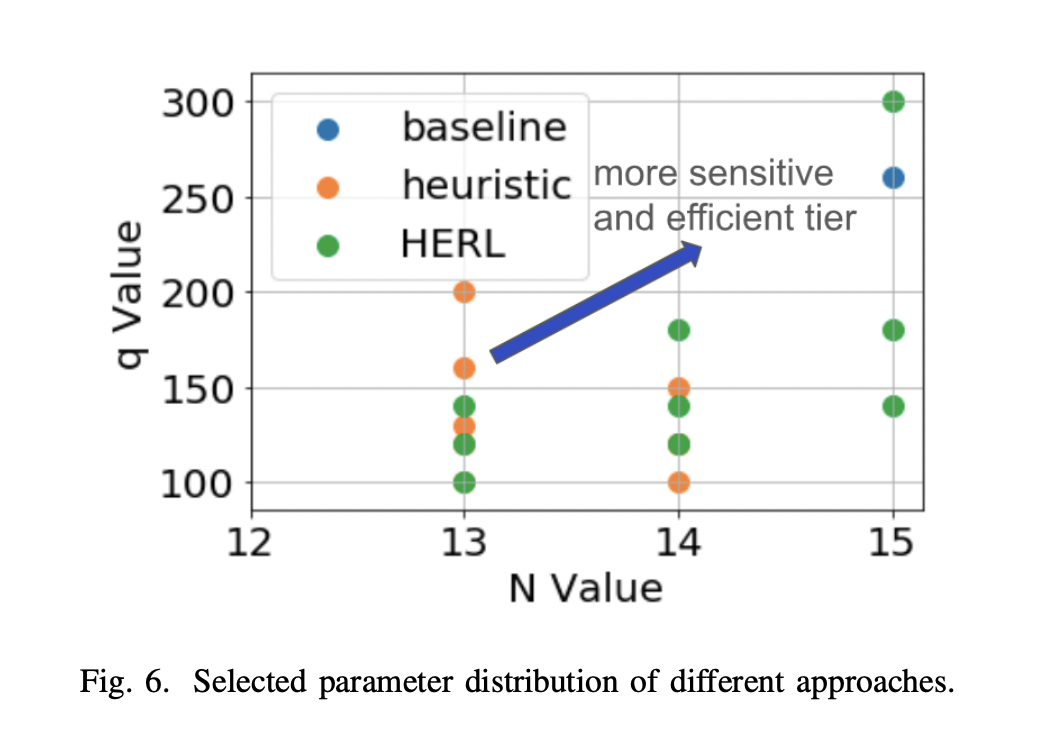

Исследователи представили технику Reinforcement Learning (обучения с подкреплением) на основе шифрования с сохранением гомоморфности. С помощью Q-Learning HERL динамически оптимизирует выбор параметров шифрования для различных групп клиентов. Это позволяет улучшить эффективность сходимости модели FL на 30%, сократить время сходимости до 24% и улучшить полезность на 17%.

Преимущества внедрения HERL:

HERL является надежным вариантом интеграции шифрования с сохранением гомоморфности в FL для различных настроек клиентов. Он обеспечивает баланс между безопасностью, вычислительной эффективностью и полезностью, сокращая издержки вычислений и улучшая эффективность операций FL.

Ключевые моменты исследования:

Исследование охватывает влияние параметров HE на производительность FL, методы использования HE в приложениях FL, а также динамическую настройку параметров шифрования для различных уровней клиентов с помощью RL.