Механизм самовнимания и его вызовы

Механизм самовнимания является основой архитектур трансформеров, но сталкивается с серьезными проблемами как в теории, так и на практике. Несмотря на успехи в обработке естественного языка и компьютерном зрении, его развитие часто основывается на эвристических подходах, что ограничивает интерпретируемость и масштабируемость.

Проблемы традиционных методов самовнимания

Традиционные методы, такие как софтмакс-внимание, используют взвешенные средние для установления динамических отношений между входными токенами. Однако они имеют значительные ограничения:

- Отсутствие формализованной структуры затрудняет адаптацию и понимание.

- Понижение производительности в условиях шумных данных или атак.

- Высокие вычислительные затраты ограничивают применение в условиях ограниченных ресурсов.

Новое решение от Национального университета Сингапура

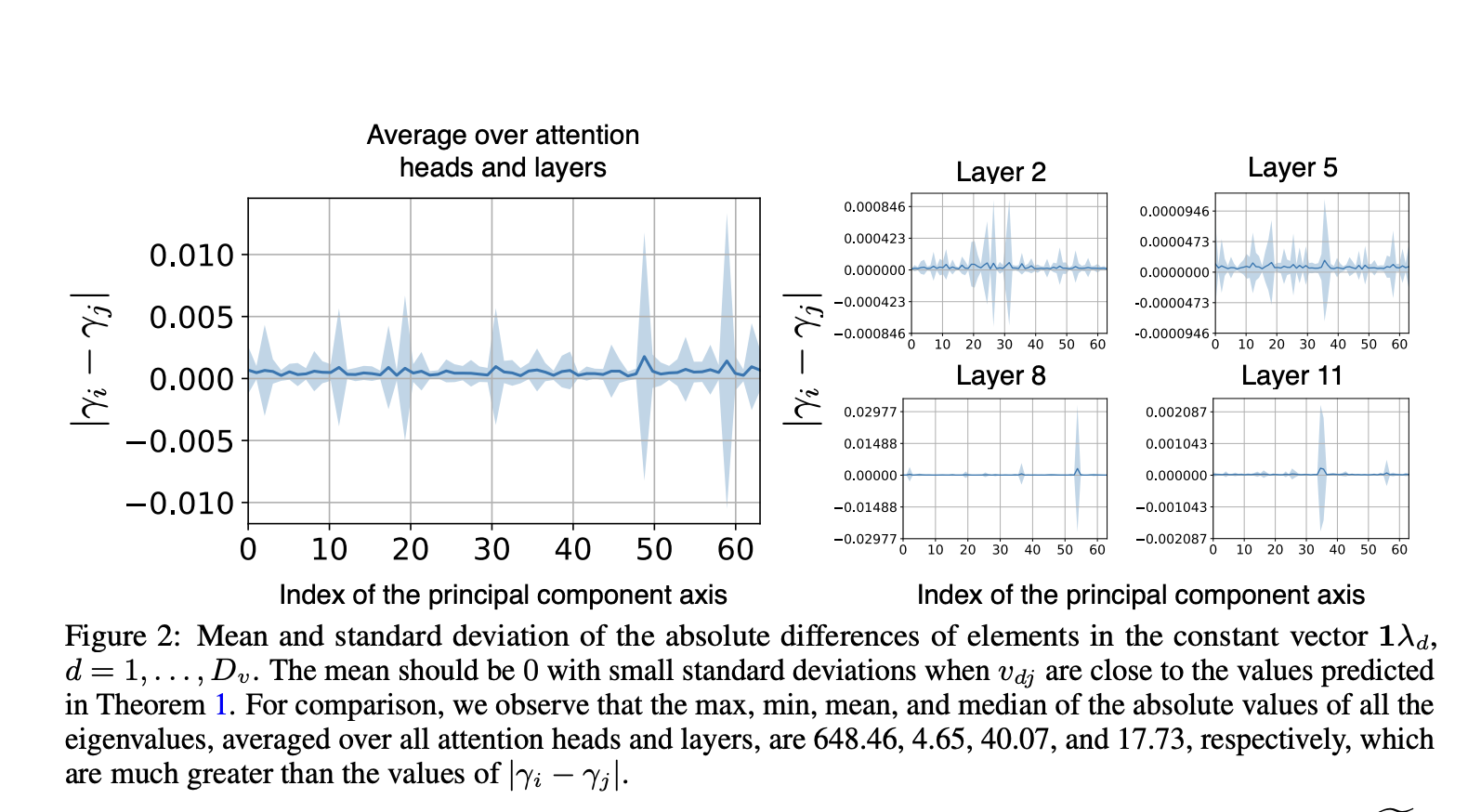

Исследователи предложили новую интерпретацию самовнимания с использованием анализа главных компонент (KPCA), что создает теоретическую основу для более надежного механизма.

Ключевые преимущества нового подхода

- Самовнимание представляется как проекция векторов запросов на главные компоненты матрицы ключей, что делает его более интерпретируемым.

- Механизм «Внимание с надежными главными компонентами» (RPC-Attention) улучшает устойчивость к искажениям данных.

- Использование «Поиска главных компонент» (PCP) для отделения чистых данных от искажений значительно повышает надежность.

Практическое применение и результаты

Новый подход был протестирован на различных наборах данных, таких как ImageNet-1K и ADE20K, и показал:

- Улучшение точности классификации объектов.

- Снижение ошибок при наличии искажений и атак.

- Лучшие результаты в языковом моделировании и сегментации изображений.

Преимущества для бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, рассмотрите возможность применения новых решений:

- Анализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить.

- Внедряйте ИИ постепенно, начиная с небольших проектов.

Заключение

Новые подходы к самовниманию значительно улучшают понимание и возможности архитектур трансформеров, что позволяет создавать более надежные и эффективные приложения в области ИИ.