Использование больших языковых моделей (LLM) в искусственном интеллекте

Большие языковые модели (LLM) революционизировали обработку естественного языка, демонстрируя замечательные возможности в различных приложениях. Однако эти модели сталкиваются с значительными вызовами, такими как временные ограничения базы знаний, сложные математические вычисления и склонность к производству неточной информации или «галлюцинаций». Для преодоления этих ограничений и улучшения производительности LLM исследователи ищут инновационные решения, которые не требуют обширной переобучения. Интеграция LLM с внешними источниками данных и приложениями выделяется как многообещающий подход для решения этих вызовов, нацеленный на повышение точности, актуальности и вычислительных возможностей, сохраняя при этом основные сильные стороны моделей в понимании и генерации языка.

Применение архитектуры трансформера в обработке естественного языка

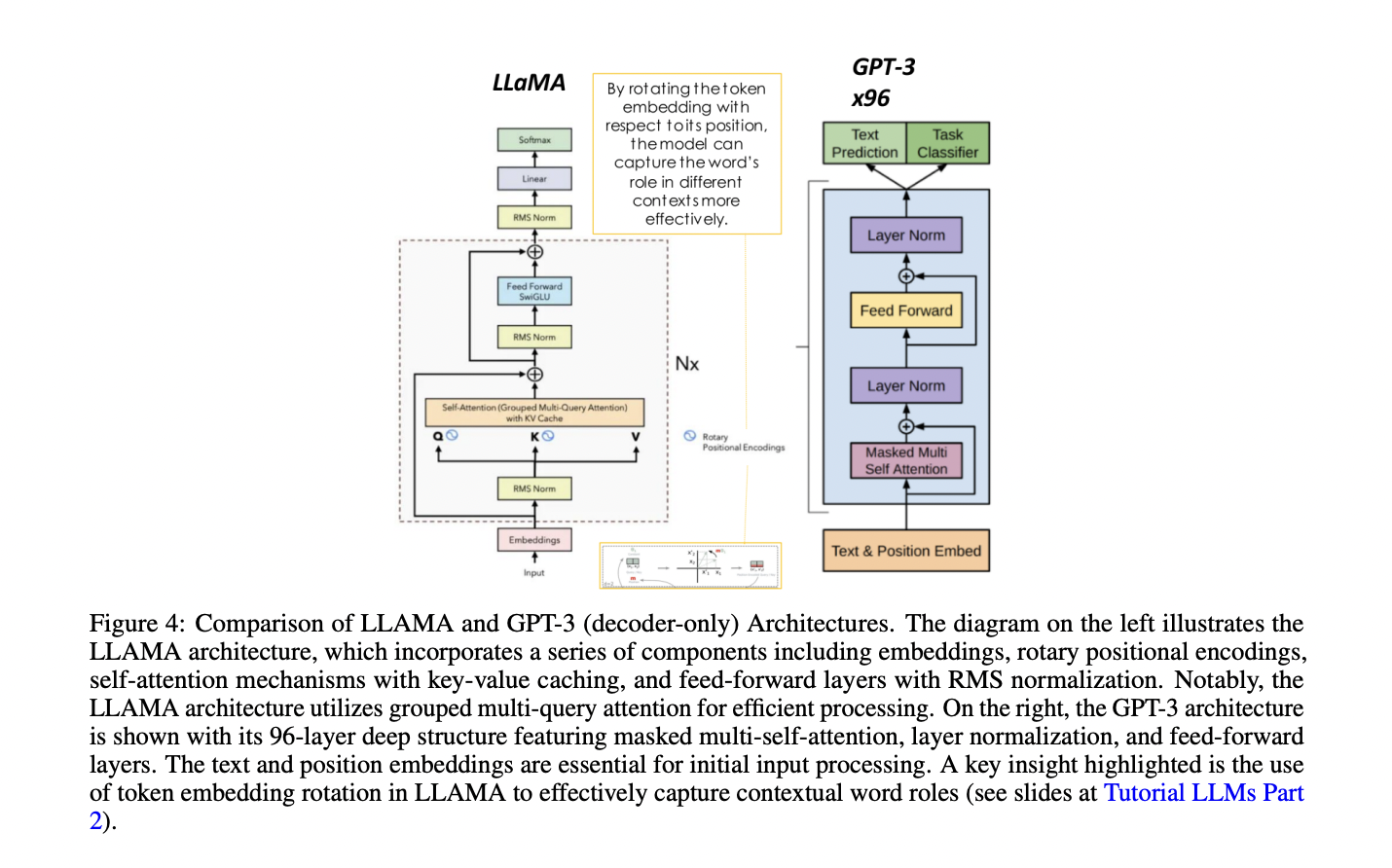

Архитектура трансформера стала значительным прорывом в обработке естественного языка, значительно превосходя предыдущие рекуррентные нейронные сети. Ключ к этому успеху заключается в механизме самовнимания трансформера, который позволяет модели учитывать значимость каждого слова для каждого другого слова в предложении, улавливая сложные зависимости и контекстуальную информацию. Трансформеры состоят из компонентов кодировщика и декодера, каждый из которых включает в себя несколько слоев с механизмами самовнимания и нейронными сетями прямого распространения. Архитектура обрабатывает токенизированный ввод через встраивающие слои, применяет многоголовое самовнимание и включает позиционное кодирование для сохранения информации о последовательности. Для конкретных задач были разработаны различные модели на основе трансформера, включая только кодировщиковые модели, такие как BERT для понимания текста, модели кодировщик-декодер, такие как BART и T5 для задач последовательности-последовательности, и только декодерные модели, такие как семейство GPT для генерации текста. Недавние достижения сосредотачиваются на масштабировании этих моделей и разработке методов эффективной донастройки, расширяя их применимость в различных областях.

Инновационные решения для улучшения производительности LLM

Исследователи представляют комплексное исследование вызовов, с которыми сталкиваются LLM, и инновационные решения для их преодоления. Они представляют Retrieval Augmented Generation (RAG) как метод доступа к информации в реальном времени из внешних источников, улучшающий производительность LLM в различных приложениях. Они обсуждают интеграцию LLM с внешними приложениями для выполнения сложных задач и исследуют методы цепочки мыслей для улучшения способностей к рассуждению. Статья углубляется в такие фреймворки, как Program-Aided Language Model (PAL), который связывает LLM с внешними интерпретаторами кода для точных вычислений, и рассматривает достижения, такие как ReAct и LangChain для решения сложных проблем. Исследователи также излагают архитектурные компоненты для разработки приложений на базе LLM, охватывающие инфраструктуру, развертывание и интеграцию внешних источников информации. Статья предоставляет представления о различных моделях на основе трансформера, методах масштабирования обучения модели и стратегиях донастройки для улучшения производительности LLM для конкретных случаев использования.

Применение современных генеративных систем ИИ

Системы современного генеративного искусственного интеллекта, такие как ChatGPT и Gemini, представляют собой не просто LLM, а интегрируют несколько фреймворков и возможностей, выходящих далеко за рамки автономных LLM. В их основе лежит LLM, служащий основным двигателем для генерации текста, но это лишь один компонент в более широкой и сложной структуре.

Инструменты, такие как Retrieval-Augmented Generation (RAG), улучшают возможности модели, позволяя ей извлекать информацию из внешних источников. Техники, такие как Chain of Thought (CoT) и Program-Aided Language models (PAL), дополнительно улучшают способности к рассуждению. Фреймворки, такие как ReAct (Reasoning and Acting), позволяют ИИ-системам планировать и выполнять стратегии для решения проблем. Эти компоненты работают вместе, создавая сложную экосистему, которая обеспечивает более сложные, точные и контекстуально актуальные ответы, значительно превышающие возможности автономных языковых моделей.

Текущие достижения в обучении LLM

Текущие достижения в обучении LLM сосредотачиваются на эффективном масштабировании через несколько графических процессоров. Техники, такие как Distributed Data Parallel (DDP) и Fully Sharded Data Parallel (FSDP), распределяют вычисления и компоненты модели по графическим процессорам, оптимизируя использование памяти и скорость обучения. FSDP, вдохновленный фреймворком ZeRO (Zero Redundancy Optimizer), вводит три этапа оптимизации для разделения состояний модели, градиентов и параметров. Эти методы позволяют обучать более крупные модели и ускорять процесс для более маленьких. Кроме того, разработка 1-битных LLM, таких как BitNet b1.58, предлагает значительные улучшения в эффективности использования памяти, скорости вывода и энергопотреблении, сохраняя при этом производительность, сравнимую с традиционными 16-битными моделями.

Техники донастройки улучшают производительность больших языковых моделей для конкретных задач. Донастройка по инструкции использует пары завершения запроса для обновления весов модели, улучшая ответы на конкретные задачи. Многозадачная донастройка смягчает катастрофическое забывание путем одновременного обучения на нескольких задачах. Методы PEFT, такие как Low-Rank Adaptation (LoRA) и prompt tuning, уменьшают вычислительные затраты, сохраняя производительность. LoRA вводит матрицы низкорангового разложения, а prompt tuning добавляет обучаемые мягкие подсказки. Эти методы значительно уменьшают количество обучаемых параметров, делая донастройку более доступной и эффективной. Будущие исследования направлены на оптимизацию баланса между эффективностью параметров и производительностью модели, исследуя гибридные подходы и адаптивные методы PEFT.

Обучение с подкреплением на основе обратной связи от человека (RLHF) и усиленное самообучение (ReST) — это передовые техники для выравнивания больших языковых моделей с предпочтениями человека. RLHF использует обратную связь от человека для обучения модели вознаграждения, которая направляет оптимизацию политики языковой модели через алгоритмы обучения с подкреплением, такие как Proximal Policy Optimization (PPO). ReST вводит двухуровневую структуру: шаг Grow, генерирующий выходные прогнозы, и шаг Improve, фильтрующий и донастраивающий этот набор данных с использованием оффлайн обучения с подкреплением. RLHF предлагает прямое выравнивание, но сталкивается с высокими вычислительными затратами и потенциальным взломом вознаграждения. ReST обеспечивает эффективность и стабильность, разделяя генерацию данных и улучшение политики. Оба метода значительно улучшают производительность модели, причем ReST показывает особую перспективу в масштабных приложениях. Будущие исследования могут исследовать гибридные подходы, объединяющие их преимущества.

Использование искусственного интеллекта для вашего бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте From RAG to ReST: A Survey of Advanced Techniques in Large Language Model Development. Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI. Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ. Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI. На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram. Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/. Этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию. Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.