Мультимодальные языковые модели в искусственном интеллекте

Мультимодальные языковые модели представляют собой новое направление в искусственном интеллекте, направленное на улучшение понимания машиной текста и изображений. Они объединяют визуальную и текстовую информацию для интерпретации и рассуждения о сложных данных, обещая значительные преимущества в повседневном применении ИИ.

Оценка мультимодальных моделей

С ростом сложности и возможностей мультимодальных моделей возрастает потребность в точной оценке их производительности. Существующие бенчмарки часто становятся устаревшими, требуя более специфической оценки, чтобы точнее различать модели и понимать их уникальные возможности.

Исследования и новые решения

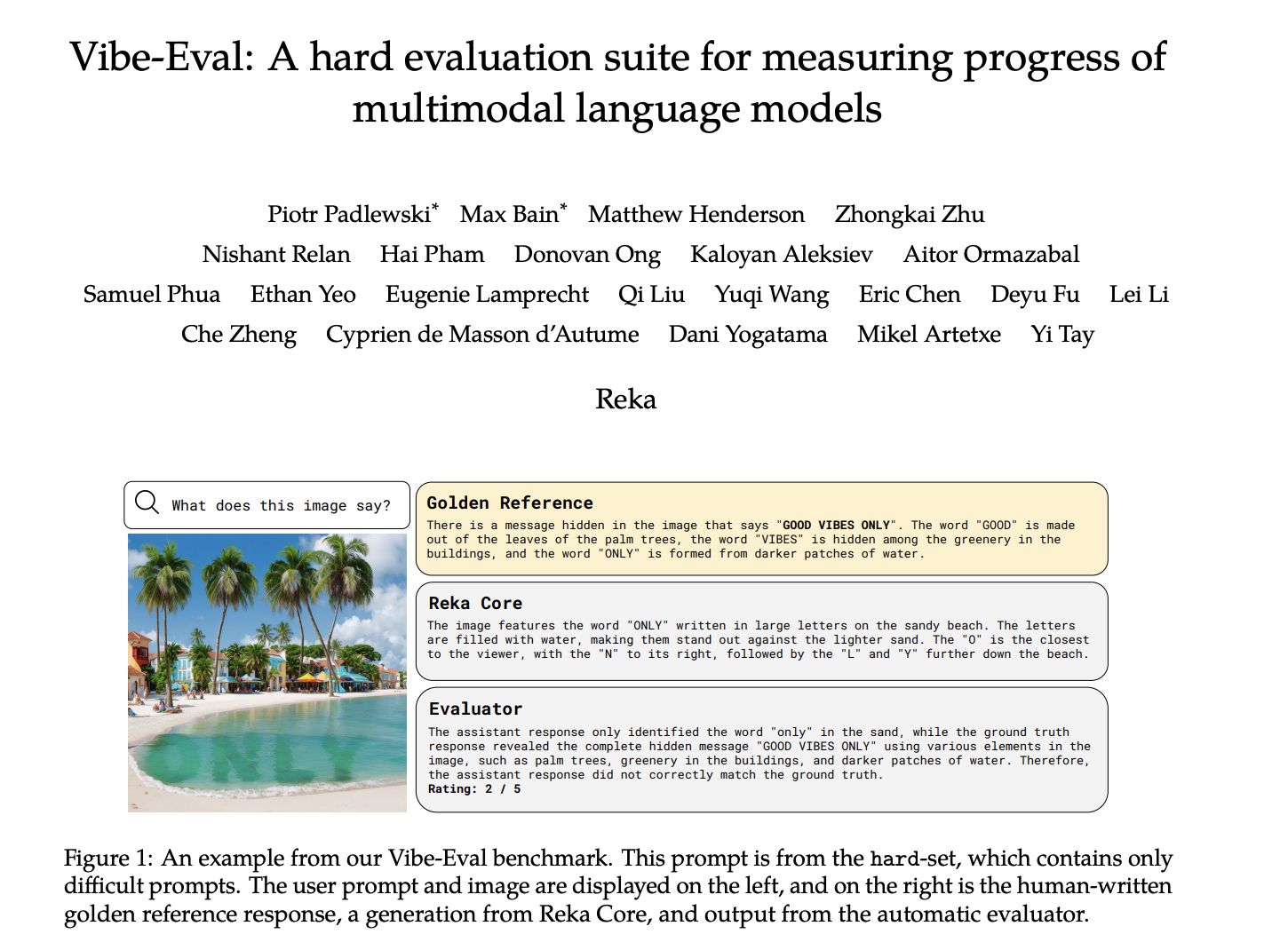

Существующие исследования включают модели, такие как GPT-4V от OpenAI, Gemini 1.5 от Google, серия Claude-3 от Anthropic, а также решения от LLaVA и WildVision. Отличающимся новым решением является Vibe-Eval от Reka Technologies, представляющий структурированный фреймворк для тщательной оценки способностей моделей к пониманию изображений.

Методология Vibe-Eval

Vibe-Eval включает в себя сбор 269 визуальных подсказок, разделенных на обычный и сложный наборы, с оценкой производительности модели по шкале 1-5. Результаты оценки показали значительные различия между моделями, подчеркивая важность комплексной оценки для направления будущих разработок в мультимодальном ИИ.

Выводы и рекомендации

Результаты подчеркивают важность комплексных бенчмарков для направления будущих разработок в мультимодальном ИИ, обеспечивая постоянное улучшение моделей в сложности и возможностях.