«`html

Улучшение надежности LLM: выявление конфабуляций с помощью семантической энтропии

LLM, такие как ChatGPT и Gemini, обладают впечатляющими способностями к рассуждению и ответам, но часто производят «галлюцинации», то есть генерируют ложную или неподтвержденную информацию. Это затрудняет их надежность в критически важных областях, от юриспруденции до медицины, где неточности могут иметь серьезные последствия. Усилия по снижению этих ошибок путем надзора или укрепления имели ограниченный успех.

Практические решения:

Исследователи из группы OATML Университета Оксфорда разработали статистический подход для обнаружения конфабуляций в LLM, известных как «конфабуляции». Эти ошибки возникают, когда LLM генерируют произвольные и неправильные ответы, часто из-за тонких вариаций во входных данных или случайного семени.

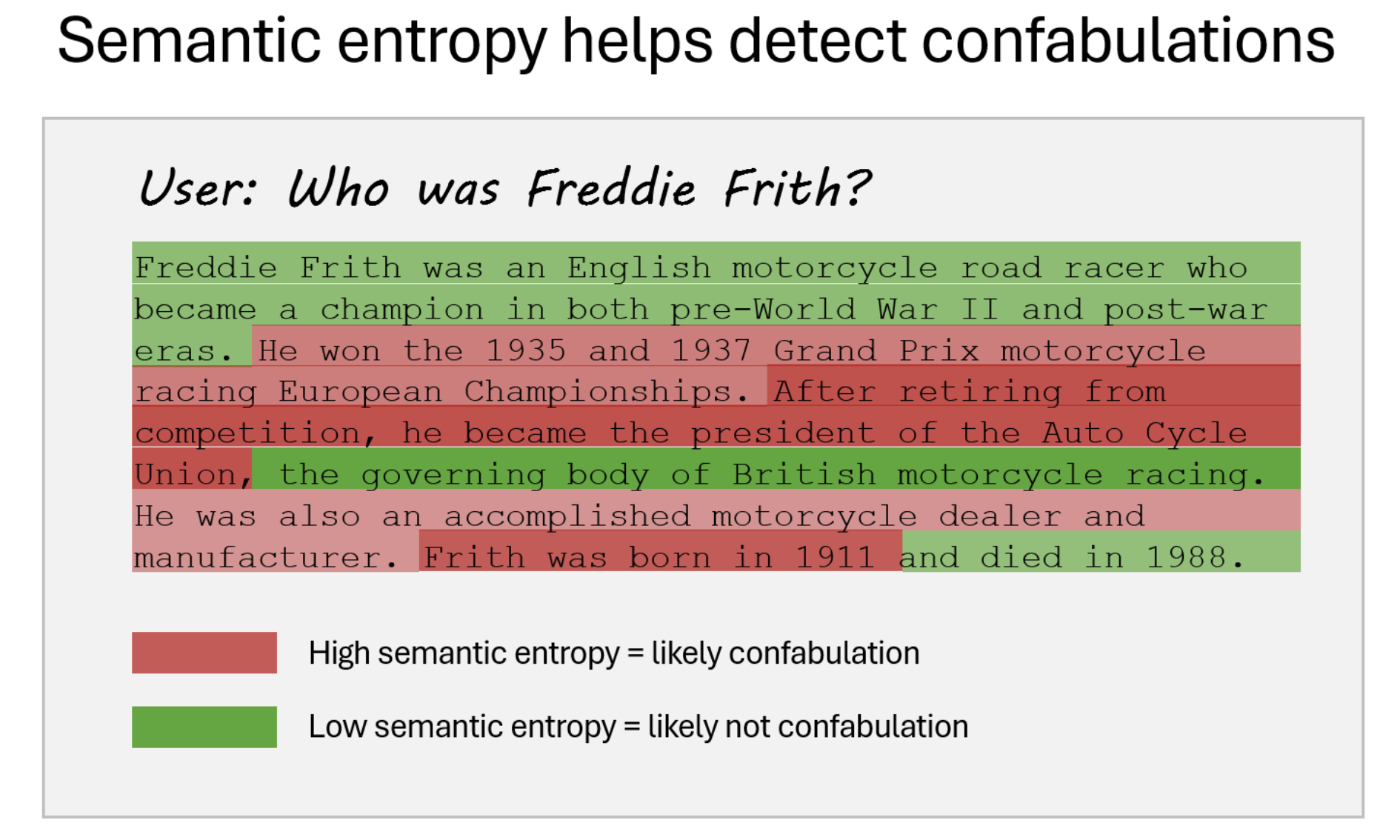

Новый метод использует оценщики неопределенности на основе энтропии, сосредотачиваясь на значении, а не на точной формулировке ответов. Путем оценки «семантической энтропии» — неопределенности в смысле сгенерированных ответов — эта техника может определить, когда LLM, скорее всего, будут производить ненадежные выводы. Этот метод не требует знания конкретной задачи или размеченных данных и эффективен в различных наборах данных и приложениях.

Метод исследователей работает путем кластеризации подобных ответов на основе их значения и измерения энтропии в этих кластерах. Если энтропия высока, LLM, скорее всего, генерируют конфабулированные ответы. Этот процесс повышает обнаружение семантических несоответствий, которые могли бы быть упущены ненаучными мерами энтропии, учитывающими только лексические различия. Техника была протестирована на различных LLM в различных областях, таких как знание в целом и медицинские запросы, демонстрируя значительное улучшение в обнаружении и фильтрации ненадежных ответов.

Семантическая энтропия — метод для обнаружения конфабуляций в LLM путем измерения их неопределенности в отношении значения сгенерированных выводов. Этот подход помогает предсказывать точность модели, повышает надежность, предупреждая о неопределенных ответах, и дает пользователям лучшую оценку уверенности в выводах модели.

Исследование сосредотачивается на выявлении и смягчении конфабуляций — ошибочных или вводящих в заблуждение выводов — созданных LLM с использованием метрики «семантической энтропии». Это позволяет эффективно определять конфабуляции в расширенных текстах, превосходя простые механизмы самопроверки и адаптируя вероятностные методы.

«`