«`html

Методы машинного обучения и искусственные нейронные сети

Методы машинного обучения, в частности глубокие нейронные сети (DNN), считаются уязвимыми к атакам. Даже небольшие добавочные искажения во входных изображениях могут значительно влиять на точность классификации предварительно обученной модели. Это вызывает серьезные опасения в области безопасности при критических приложениях DNN в различных областях.

Атаки на модели машинного обучения

Атаки подразделяются на белый и черный ящик. Белый ящик требует полного знания целевой модели машинного обучения, что делает их непрактичными во многих реальных сценариях. Черный ящик более реалистичен, так как не требует подробного знания целевой модели. Они могут быть разделены на атаки на основе передачи, атаки на основе оценки (или мягкие атаки) и атаки на основе решений (жесткие атаки).

Улучшение эффективности атак

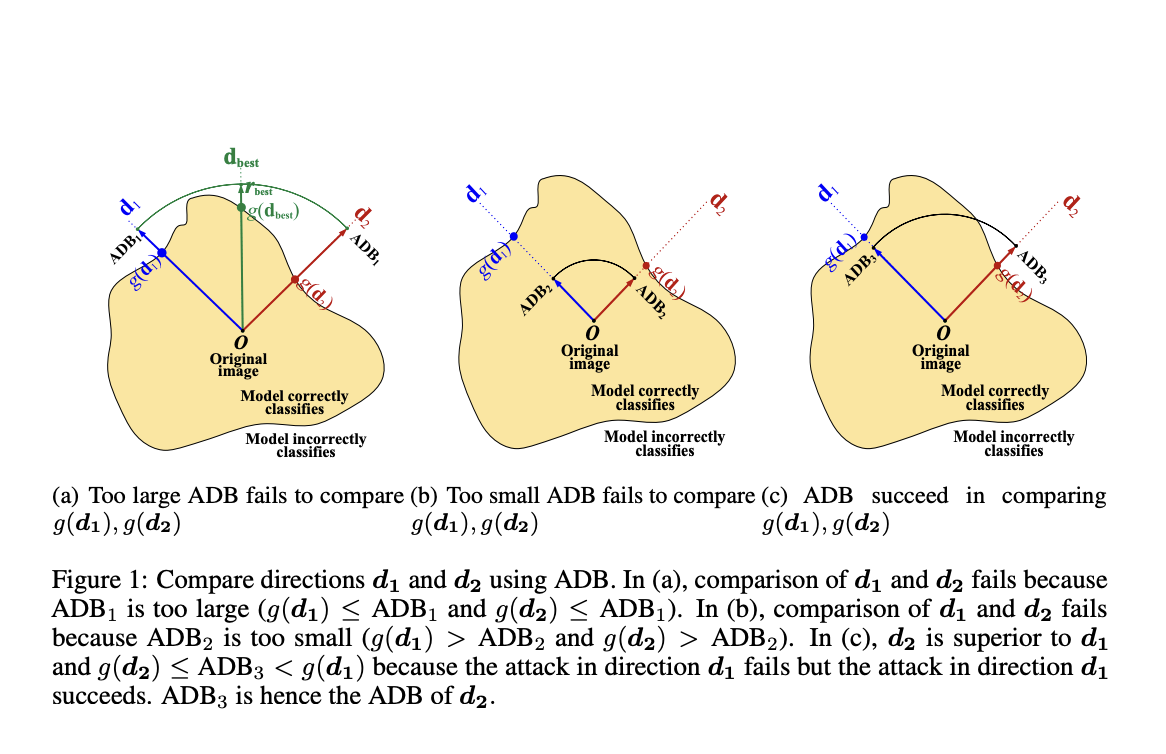

Существующие атаки на основе решений могут быть разделены на случайный поиск, оценку градиента и геометрическое моделирование. Основной проблемой случайных атак является большое количество запросов, необходимых для определения границы решения и оптимизации направления искажения.

Повышение эффективности атак

Улучшение эффективности атак на основе решений включает тонкий баланс между минимизацией количества запросов и поддержанием эффективных стратегий искажения. Исследователи предлагают исследовать инновационные методы для улучшения эффективности и эффективности этих атак.

Подробнее о статье можно узнать здесь.

«`