«`html

Решение для эффективной настройки больших моделей языка

Многие разработчики и исследователи, работающие с большими языковыми моделями, сталкиваются с проблемой эффективной настройки моделей. Настройка необходима для адаптации модели к конкретным задачам или улучшения ее производительности, но часто требует значительных вычислительных ресурсов и времени.

Проблема с существующими решениями

Существующие решения для настройки больших моделей, такие как общая практика корректировки всех весов модели, могут потреблять большое количество ресурсов. Этот процесс требует значительной памяти и вычислительной мощности, что делает его непрактичным для многих пользователей. Некоторые продвинутые техники и инструменты могут помочь оптимизировать этот процесс, но часто требуют глубокого понимания процесса, что может быть преградой для многих пользователей.

Решение: Mistral-finetune

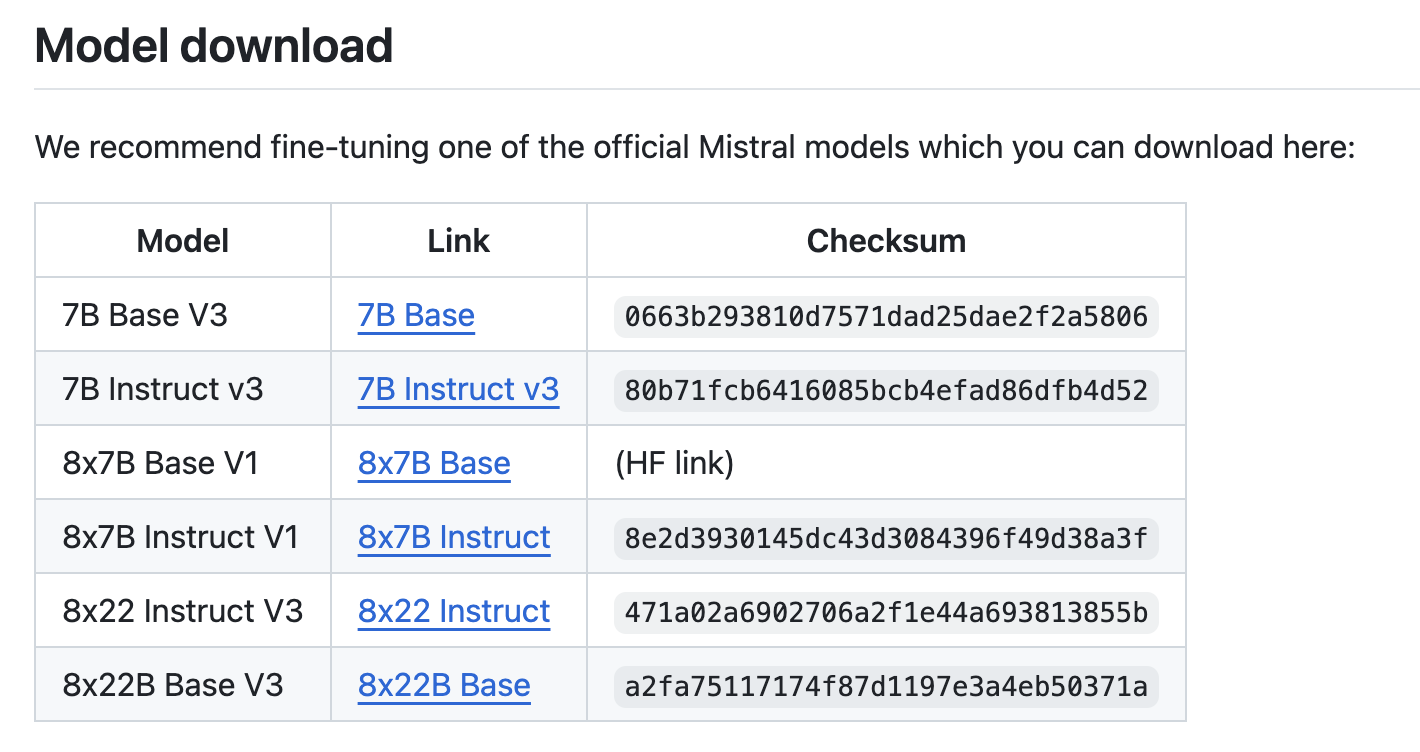

Знакомьтесь с Mistral-finetune: легковесной кодовой базой, разработанной для эффективной настройки больших языковых моделей. Она использует метод, известный как Low-Rank Adaptation (LoRA), при котором во время обучения корректируется только небольшой процент весов модели. Этот подход значительно снижает вычислительные требования и ускоряет настройку, делая ее доступной для более широкой аудитории.

Mistral-finetune оптимизирован для использования с мощными GPU, такими как A100 или H100, что улучшает его производительность. Однако для более маленьких моделей, таких как версии с 7 миллиардами параметров (7B), даже одного GPU достаточно. Эта гибкость позволяет пользователям с различными аппаратными ресурсами воспользоваться этим инструментом. Кодовая база поддерживает многографические настройки для более крупных моделей, обеспечивая масштабируемость для более требовательных задач.

Эффективность инструмента продемонстрирована его способностью быстрой и эффективной настройки моделей. Например, обучение модели на наборе данных, таком как Ultra-Chat, с использованием 8xH100 GPU кластера может быть завершено примерно за 30 минут, при этом достигается высокий показатель производительности. Эта эффективность представляет собой значительный прогресс по сравнению с традиционными методами, которые могут занимать гораздо больше времени и требовать больше ресурсов. Возможность обработки различных форматов данных, таких как наборы данных для следования инструкциям и вызова функций, дополнительно демонстрирует его универсальность и надежность.

В заключение, Mistral-finetune решает общие проблемы настройки больших языковых моделей, предлагая более эффективный и доступный подход. Использование LoRA значительно снижает необходимость в обширных вычислительных ресурсах, позволяя более широкому кругу пользователей эффективно настраивать модели. Этот инструмент не только экономит время, но также открывает новые возможности для тех, кто работает с большими языковыми моделями, делая передовые исследования и разработку ИИ более доступными.

Применение ИИ для вашего бизнеса

Если вы хотите использовать ИИ для развития своей компании и оставаться в числе лидеров, обратитесь к Mistral-finetune: легковесной кодовой базе, обеспечивающей эффективную настройку моделей Mistral.

Проанализируйте, как ИИ может изменить вашу работу, определите моменты для применения автоматизации и ключевые показатели эффективности, которые вы хотите улучшить с помощью ИИ. Подберите подходящее решение и внедряйте ИИ постепенно, начиная с малых проектов и анализируя результаты и KPI. На основе полученных данных и опыта расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram.

Попробуйте ИИ ассистент в продажах от Flycode.ru. Этот ИИ ассистент помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.

«`