«`html

InternLM2.5-7B-Chat: Открытие крупных языковых моделей с беспрецедентным рассуждением, обработкой длинного контекста и улучшенным использованием инструментов

InternLM представил свое последнее достижение в области открытых крупных языковых моделей — InternLM2.5-7B-Chat, доступный в формате GGUF. Эта модель совместима с llama.cpp, открытой платформой для вывода LLM, и может использоваться локально и в облаке на различных аппаратных платформах. Формат GGUF предлагает версии половинной точности и низкобитовые квантованные версии, включая q5_0, q5_k_m, q6_k и q8_0.

Практические решения и ценность:

Модель InternLM2.5 расширяет возможности своего предшественника, предлагая базовую модель с 7 миллиардами параметров и модель чата, нацеленную на практические сценарии. Эта модель обладает передовыми способностями рассуждения, особенно в математическом рассуждении, превосходя конкурентов, таких как Llama3 и Gemma2-9B. Она также имеет внушительное окно контекста в 1 миллион, демонстрируя практически идеальную производительность в задачах с длинным контекстом, таких как те, которые оценивает LongBench.

Способность модели обрабатывать длинные контексты делает ее особенно эффективной при извлечении информации из обширных документов. Эта способность усиливается в паре с LMDeploy, набором инструментов, разработанным командами MMRazor и MMDeploy для сжатия, развертывания и обслуживания LLM. Вариант InternLM2.5-7B-Chat-1M, предназначенный для вывода контекста длиной 1 миллион, является ярким примером этой силы. Эта версия требует значительных вычислительных ресурсов, таких как 4xA100-80G GPU, для эффективной работы.

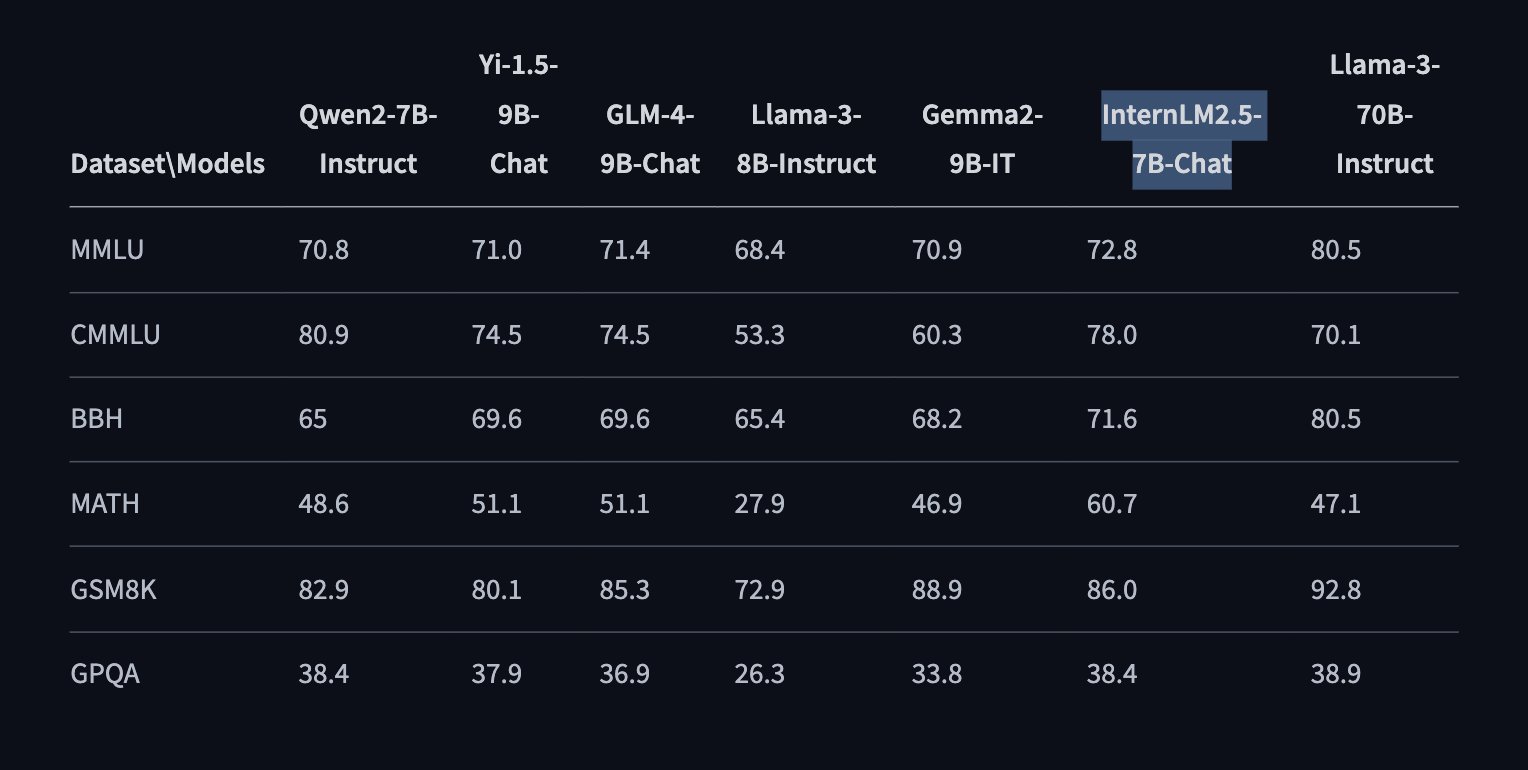

Оценки производительности, проведенные с использованием инструмента OpenCompass, подчеркивают компетентность модели по различным измерениям: дисциплинарная компетентность, языковая компетентность, компетентность знаний, компетентность вывода и компетентность понимания. В бенчмарках, таких как MMLU, CMMLU, BBH, MATH, GSM8K и GPQA, InternLM2.5-7B-Chat постоянно продемонстрировала превосходную производительность по сравнению с конкурентами.

Модель InternLM2.5-7B-Chat также отличается в обработке использования инструментов, поддерживая извлечение информации из более чем 100 веб-страниц. Выход новой версии Lagent дополнительно улучшит эту функциональность, улучшая способности модели в следовании инструкциям, выборе инструментов и рефлексии.

Архитектура модели InternLM2.5 сохраняет надежные особенности своего предшественника, внедряя новые технические инновации. Эти улучшения, основанные на большом корпусе синтетических данных и итеративном процессе обучения, приводят к модели с улучшенной производительностью рассуждения, что приводит к увеличению на 20% по сравнению с InternLM2.

В заключение, с выпуском InternLM2.5 и его вариантов с передовыми способностями рассуждения, обработкой длинного контекста и эффективным использованием инструментов, InternLM2.5-7B-Chat обещает быть ценным ресурсом для различных приложений как в исследованиях, так и в практических сценариях.

«`