Современные решения в области обработки естественного языка (NLP)

Обработка естественного языка (NLP) постоянно развивается. Одним из новых методов является обучение в контексте (ICL), которое предлагает инновационные подходы для улучшения больших языковых моделей (LLMs). ICL позволяет моделям обучаться на конкретных примерах, не изменяя их внутренние параметры. Это особенно полезно для быстрой адаптации LLM к различным задачам.

Проблемы и решения ICL

Тем не менее, ICL может требовать значительных ресурсов, особенно в моделях на основе трансформеров. Повышенные требования к памяти возрастают с количеством примеров. Это может превышать возможности моделей и негативно влиять на их производительность. Поэтому оптимизация обработки примеров в ICL становится важной задачей.

Ключевая проблема: как эффективно использовать демонстрационные данные, не расходуя ресурсы. Традиционные методы ICL основываются на объединении всех примеров в одну последовательность, что может снижать качество работы. Более того, такие методы не справляются с большими наборами данных, включающими нерелевантную информацию.

Новое решение: Метод MoICL

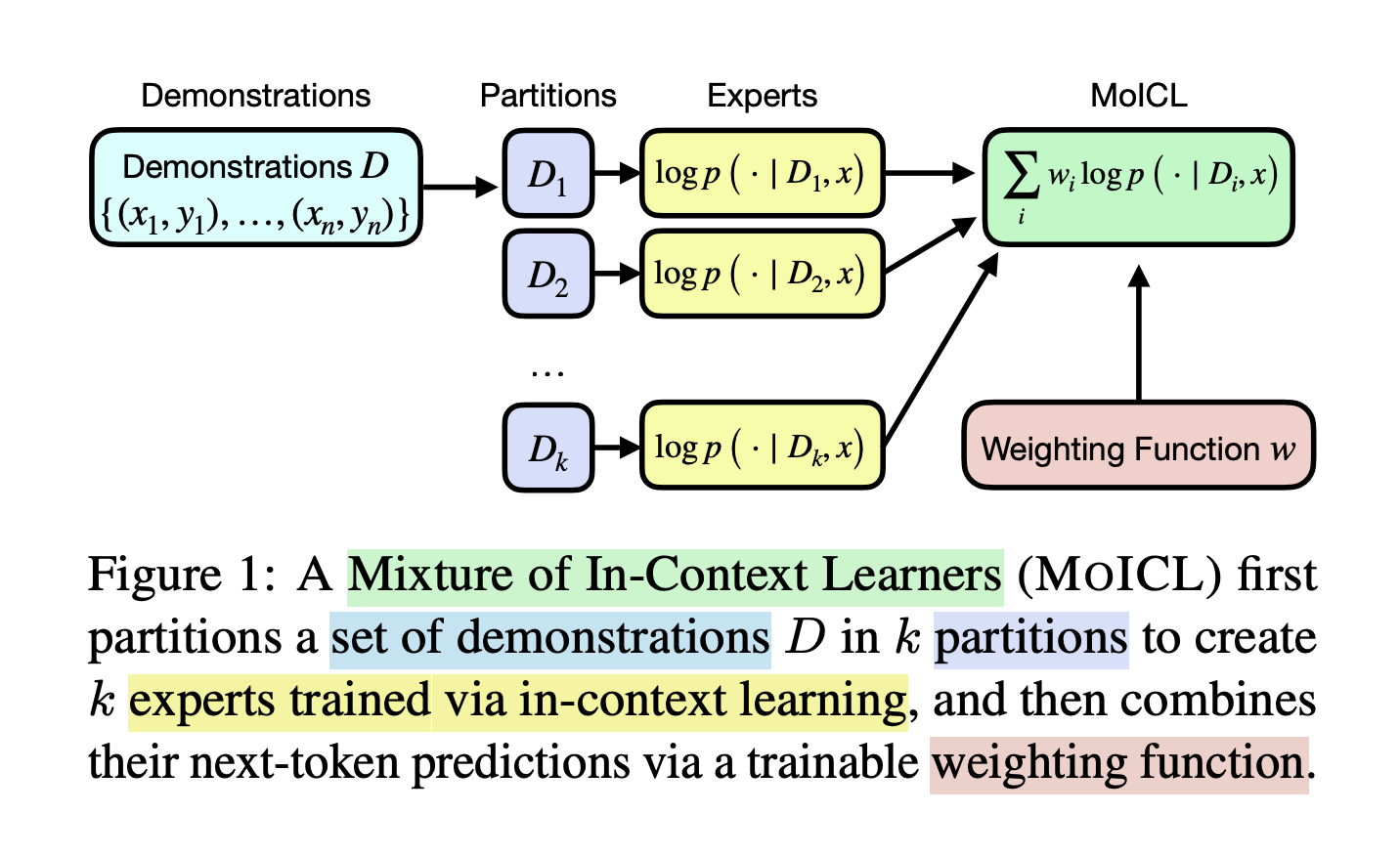

Исследователи из Эдинбургского университета и Miniml.AI разработали метод Mixtures of In-Context Learners (MoICL). Этот метод делит демонстрации на более мелкие группы, называемые «экспертами». Каждая группа обрабатывает часть данных и выдает предсказание. Весовая функция динамически объединяет эти прогнозы, учитывая требования к данным и задачам, чтобы эффективно использовать ресурсы памяти.

Такой подход позволяет MoICL быть более адаптивным и масштабируемым, что приводит к заметным улучшениям производительности по сравнению с традиционными методами.

Доказанная эффективность MoICL

Тесты продемонстрировали, что MoICL превосходит стандартные методы ICL на различных задачах классификации. Например, на наборе данных TweetEval была достигнута точность на 13% выше, а устойчивость к шумным данным увеличилась на 38%.

Ключевые преимущества MoICL:

- Увеличение производительности: до 13% повышения точности на TweetEval по сравнению с обычными методами.

- Устойчивость к шуму и несоответствию: улучшение устойчивости к шумным данным на 38% и справление с несбалансированными распределениями меток на 49% лучше, чем традиционные методы.

- Эффективные вычисления: сокращение времени вывода без потери точности.

- Генерализуемость: способный адаптироваться к различным типам моделей и задач NLP.

- Устойчивость к внеструктурированным данным: улучшение на 11% в обработке неожиданных изменений данных.

Заключение

Метод MoICL представляет собой значительный шаг вперед в ICL, позволяя преодолевать ограничения по памяти и обеспечивать высокую производительность. Используя группы экспертов и весовые функции, он предлагает эффективный способ выбора демонстраций и повышает точность работы с разнообразными наборами данных.

Задумайтесь, как ИИ может изменить вашу компанию. Давайте внедрим инновации вместе!