«`html

Оптимизация и ускорение техник для крупных языковых моделей (LLM)

Крупные языковые модели (LLM) сталкиваются с существенными вызовами в области оптимизации обучения. Это включает в себя:

- Ограничения ресурсов, которые ограничивают обучение и развертывание на одиночных устройствах из-за высоких требований к памяти и вычислительным мощностям.

- Балансировка эффективности и точности между эффективным использованием ресурсов и поддержанием производительности модели.

- Узкие места в памяти при распределении языковых моделей по устройствам.

- Накладные расходы на связь данных, которые могут замедлить обучение.

- Гетерогенность оборудования, которая усложняет эффективное использование различных устройств.

- Ограничения масштабируемости, затрудненные памятью и ограничениями связи.

Практические решения и ценность

Для преодоления этих вызовов были разработаны разнообразные техники оптимизации для LLM:

- Алгоритмические: техники, такие как FlexGen, повышают эффективность через оптимизированные вычисления и специализированные ядра оборудования.

- Разделение модели: техники, такие как GPipe, позволяют обработку на нескольких устройствах, даже при ограниченной памяти.

- Тонкая настройка для эффективности: техники, такие как AlphaTuning и LoRA, позволяют тонкую настройку больших моделей на ограниченной памяти путем уменьшения количества параметров, подлежащих настройке.

- Оптимизация планировщика: техники, такие как TurboTransformers, улучшают пропускную способность ответа и выполнение задач на графических процессорах.

Хотя SLR по техникам оптимизации крупных языковых моделей является тщательным, у него есть некоторые ограничения. Стратегия поиска может упустить соответствующие исследования, использующие различные терминологии. Кроме того, ограниченное охват базы данных привело к игнорированию значительных исследований. Эти факторы могут повлиять на полноту обзора, особенно в историческом контексте и последних достижениях.

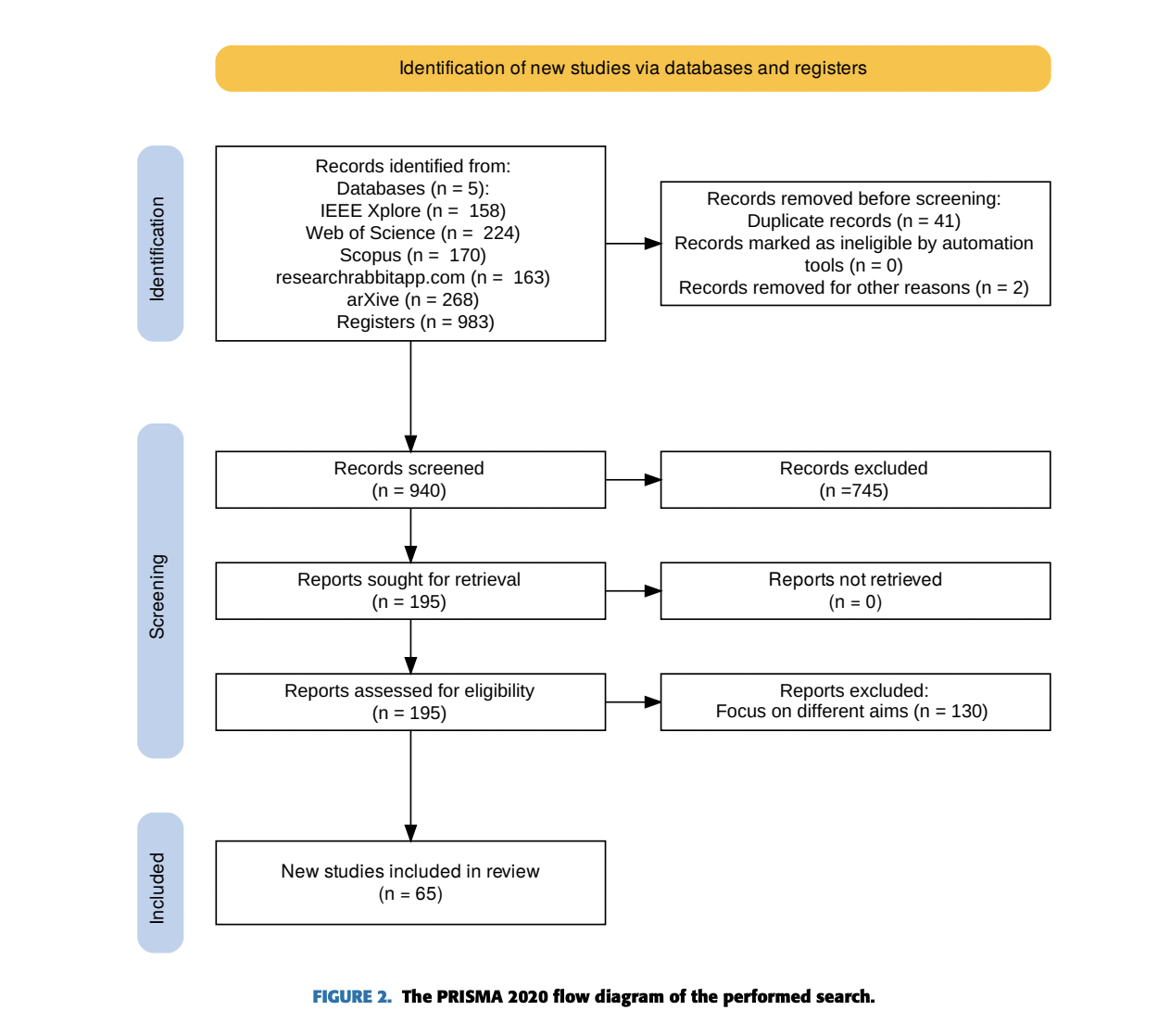

В данной статье исследователи представили систематический обзор литературы (SLR), который анализирует 65 публикаций с 2017 по декабрь 2023 года, следуя подходу PRISMA, и рассмотрели техники оптимизации и ускорения для LLM. Он выявил вызовы в области обучения, вывода и обслуживания систем для миллиардных или триллионных параметров LLM. Предложенная таксономия предоставляет четкое руководство для исследователей по навигации различными стратегиями оптимизации. Обзор библиотек и фреймворков поддерживает эффективное обучение и развертывание LLM, и два кейс-исследования демонстрируют практические подходы к оптимизации обучения моделей и улучшению эффективности вывода. Хотя последние достижения обнадеживают, исследование подчеркивает необходимость дальнейших исследований для полного раскрытия потенциала техник оптимизации LLM.

«`