«`html

Оптимизация крупных языковых моделей для кратких и точных ответов через ограниченное цепное мышление

LLM показали впечатляющие способности в решении сложных задач вопросно-ответной системы, поддерживаемые усовершенствованиями архитектур моделей и методов обучения. Техники, такие как цепное мышление (CoT), стали популярны для улучшения объяснения и точности ответов путем направления модели через промежуточные логические шаги. Однако применение цепного мышления может привести к увеличению объема вывода, увеличивая время генерации ответа из-за процесса декодирования по словам авторегрессивных трансформеров. Это создает вызовы в поддержании интерактивных разговоров и подчеркивает необходимость метрик для оценки краткости вывода и стратегий по сокращению чрезмерно длинных цепочек логического мышления.

Исследователи из Департамента отличия в робототехнике и ИИ в Scuola Superiore Sant’Anna и Mediavoice Srl проанализировали, как длина вывода влияет на время вывода LLM. Они предложили новые метрики для оценки краткости и правильности. Они представили улучшенную стратегию создания подсказок, ограниченное цепное мышление (CCoT), которое ограничивает длину вывода для улучшения точности и времени ответа. Эксперименты с LLaMA2-70b на наборе данных GSM8K показали, что ограничение логического мышления до 100 слов улучшило точность и сократило длину вывода. Исследование подчеркивает необходимость краткости в логическом мышлении LLM и выделяет различную эффективность CCoT для различных размеров моделей.

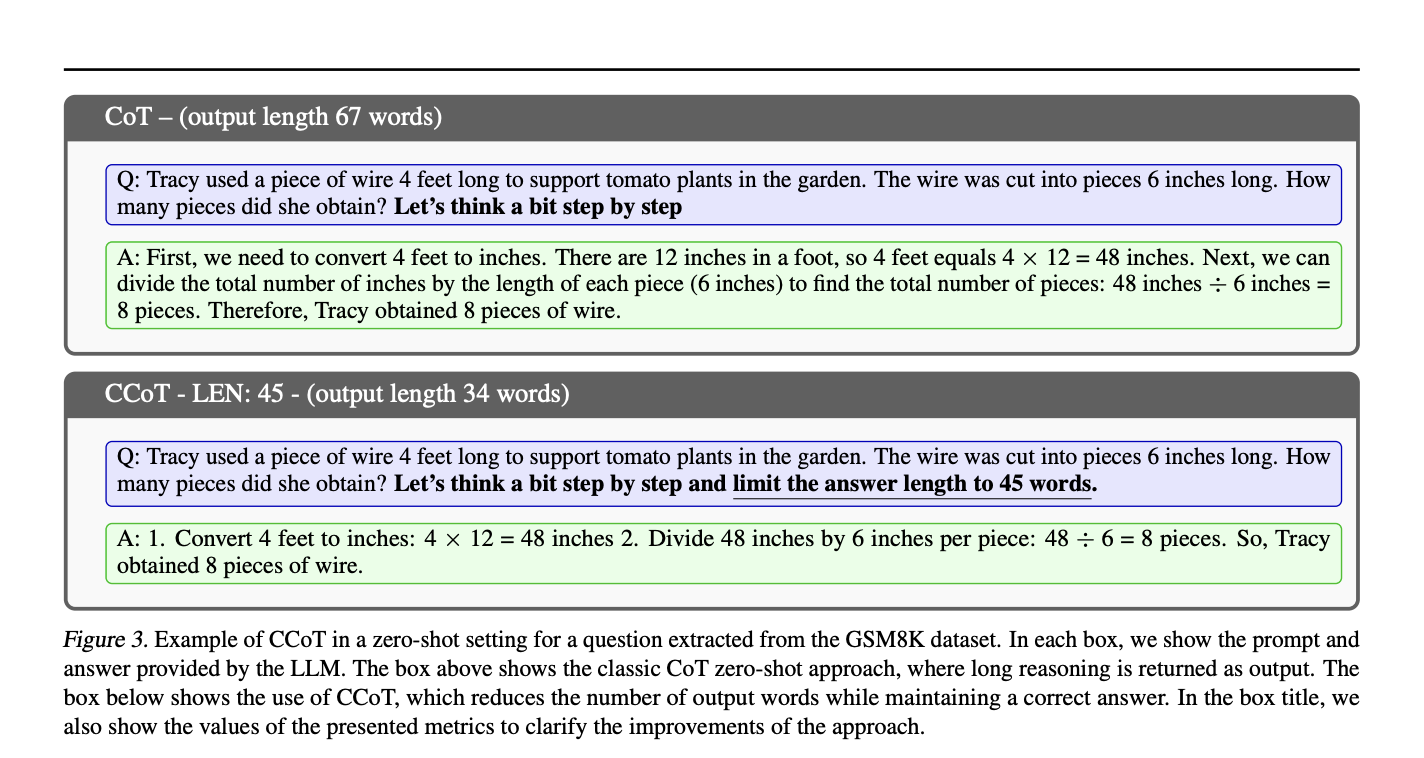

Недавние исследования LLM сосредоточились на улучшении точности, часто приводя к более длинным и подробным ответам. Эти расширенные выводы могут вызывать галлюцинации, когда модель генерирует правдоподобную, но неверную информацию и чрезмерно длинные объяснения, затмевающие ключевую информацию. Были разработаны различные техники создания подсказок для решения этой проблемы, включая цепное мышление, которое улучшает логическое мышление, но увеличивает время ответа. В исследовании предложены метрики для оценки как краткости, так и правильности, а также предложен улучшенный подход CoT, CCoT, для контроля длины вывода при сохранении качества.

Время генерации вывода LLM зависит от таких факторов, как архитектура модели, предварительная обработка, декодирование и используемая подсказка. Обычно более длинные выводы увеличивают время ответа из-за итеративной природы авторегрессивных моделей. Тесты на различных моделях (Falcon-7b/40b, Llama2-7b/70b) показали, что с увеличением длины вывода увеличивается время генерации. Цепное мышление, улучшающее правильность ответа, также увеличивает длину вывода и время генерации. Для решения этой проблемы предлагается подход CCoT, ограничивающий длину вывода при сохранении точности и сокращающий время генерации.

В экспериментах оценивается эффективность подхода CCoT по сравнению с классическим CoT, с акцентом на эффективность, точность и способность контролировать длину вывода. На наборе данных GSM8K были протестированы различные LLM (например, Llama2-70b, Falcon-40b). Результаты показывают, что CCoT сокращает время генерации и может улучшить или сохранить точность. Исследование также представляет новые метрики (HCA, SCA, CCA) для оценки производительности модели, учитывая правильность и краткость. Большие модели, такие как Llama2-70b, получают больше выгод от CCoT, в то время как меньшие модели испытывают затруднения. CCoT демонстрирует улучшенную эффективность и краткую точность, особенно для больших LLM.

Исследование подчеркивает важность краткости в генерации текста LLM и представляет CCoT как технику создания подсказок для контроля длины вывода. Эксперименты показывают, что большие модели, такие как Llama2-70b и Falcon-40b, получают выгоду от CCoT, но меньшие модели нуждаются в помощи для соблюдения ограничений длины. Исследование также предлагает новые метрики для оценки баланса между краткостью и правильностью. В будущем исследования будут исследовать интеграцию этих метрик в настройку модели и изучать, как краткость влияет на явления, такие как галлюцинации или неверное логическое мышление в LLM.

Посмотрите статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забывайте следить за нами в Twitter и присоединяйтесь к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу 47 тыс. пользователей в SubReddit по машинному обучению.

Найдите предстоящие вебинары по ИИ здесь

Arcee AI выпустила DistillKit: открытый инструмент для модельного сжатия, обеспечивающий создание эффективных и высокопроизводительных малых языковых моделей

Статья была опубликована на портале MarkTechPost.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Optimizing Large Language Models for Concise and Accurate Responses through Constrained Chain-of-Thought Prompting.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram

Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/ Этот ИИ ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru

«`