Улучшение моделей трансформера с помощью вложений абака для превосходной арифметики и алгоритмического мышления

Трансформерные модели значительно продвинули машинное обучение, особенно в решении сложных задач, таких как обработка естественного языка и арифметические операции, такие как сложение и умножение.

Исследователи стремятся улучшить способности этих моделей для выполнения сложных многошаговых задач рассуждения, особенно в арифметике, где отслеживание позиций цифр в длинных последовательностях является ключевым.

Решение проблемы

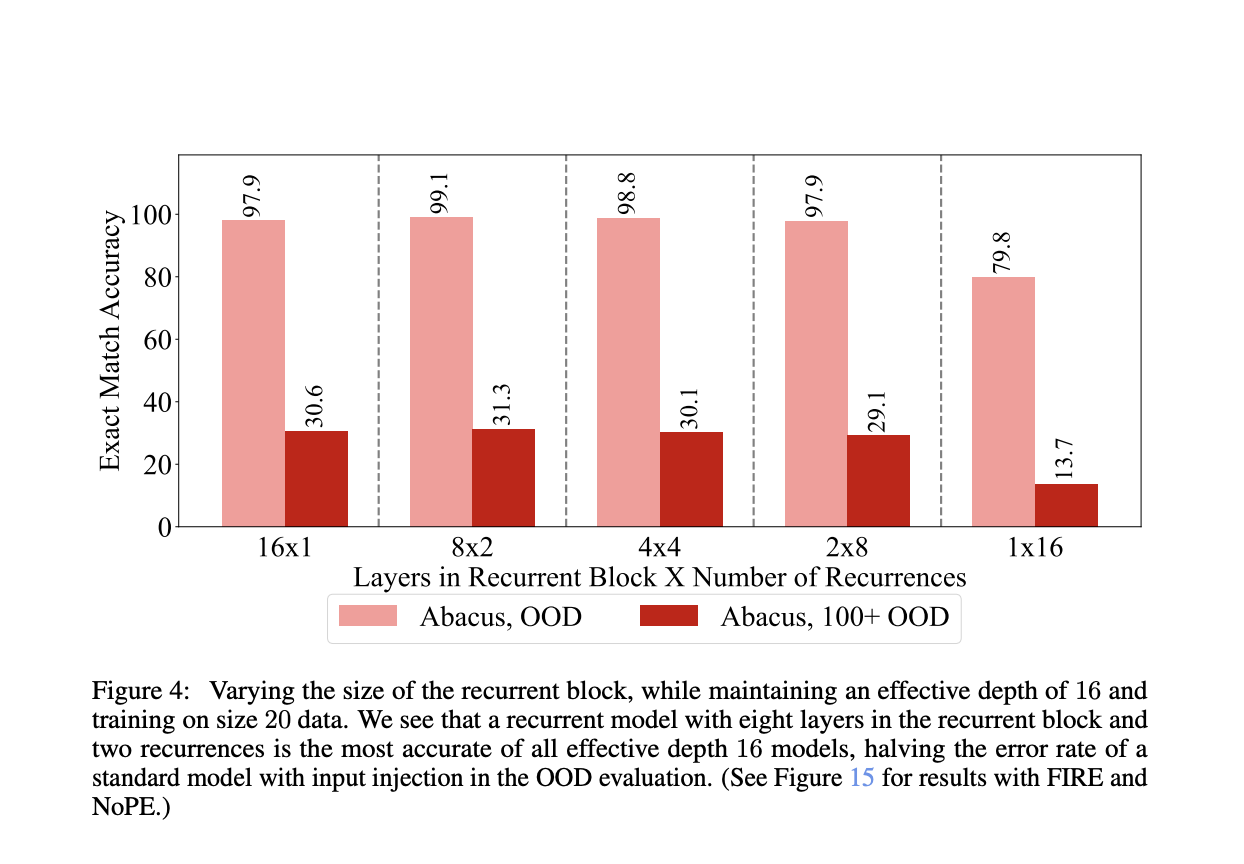

Метод вложений абака значительно улучшает способность модели трансформера отслеживать позицию каждой цифры в числе, что позволяет модели правильно выравнивать цифры.

Практические применения

Модели, обученные с использованием вложений абака, показали значительные улучшения в задачах арифметики, таких как сложение и умножение, а также в сортировке.

Значимость результатов

Модели, использующие вложения абака, достигли практически идеальной точности во многих случаях, что подчеркивает потенциал этого метода для трансформации способности моделей трансформера решать арифметические и другие алгоритмические задачи.

Заключение

Исследование подчеркивает прогресс, достигнутый благодаря вложениям абака в улучшении способностей моделей трансформера. Этот инновационный подход открывает путь для дальнейших достижений в области машинного обучения и может быть применен в различных сложных задачах.

Подробнее о исследовании и GitHub.

Вся заслуга за это исследование принадлежит его авторам.

Не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit и посетить нашу платформу для событий по ИИ.

Подробнее о нашей работе на Flycode.ru.