DFDG: Улучшение одношагового федеративного обучения с помощью двойных генераторов без данных для повышения производительности модели и уменьшения перекрытия данных

Основные практические решения и ценность:

Метод DFDG позволяет исследовать более широкое пространство обучения для локальных моделей, минимизируя перекрытие вывода между генераторами. Генераторы оцениваются по точности, передаваемости и разнообразию, обеспечивая эффективное представление распределений локальных данных. Введена функция потерь перекрестной дивергенции для уменьшения перекрытия вывода генераторов, максимизируя охват пространства обучения. Методология сосредотачивается на генерации синтетических данных, имитирующих локальные наборы данных без прямого доступа, решая проблемы конфиденциальности данных и улучшая производительность глобальной модели в гетерогенных сценариях клиентских данных.

Эксперименты проводятся на различных наборах данных для классификации изображений, сравнивая DFDG с передовыми базовыми методами, такими как FedAvg, FedFTG и DENSE. Результаты подтверждают превосходство DFDG в одношаговом федеративном обучении в различных сценариях гетерогенности данных и моделей.

DFDG демонстрирует высокую производительность в одношаговом федеративном обучении в различных сценариях гетерогенности данных и моделей. Метод показывает улучшение точности по сравнению с DFAD на 7,74% для FMNIST, 3,97% для CIFAR-10, 2,01% для SVHN и 2,59% для CINIC-10. Эффективность DFDG также подтверждается в сложных задачах, таких как CIFAR-100, Tiny-ImageNet и FOOD101 с разным количеством клиентов N.

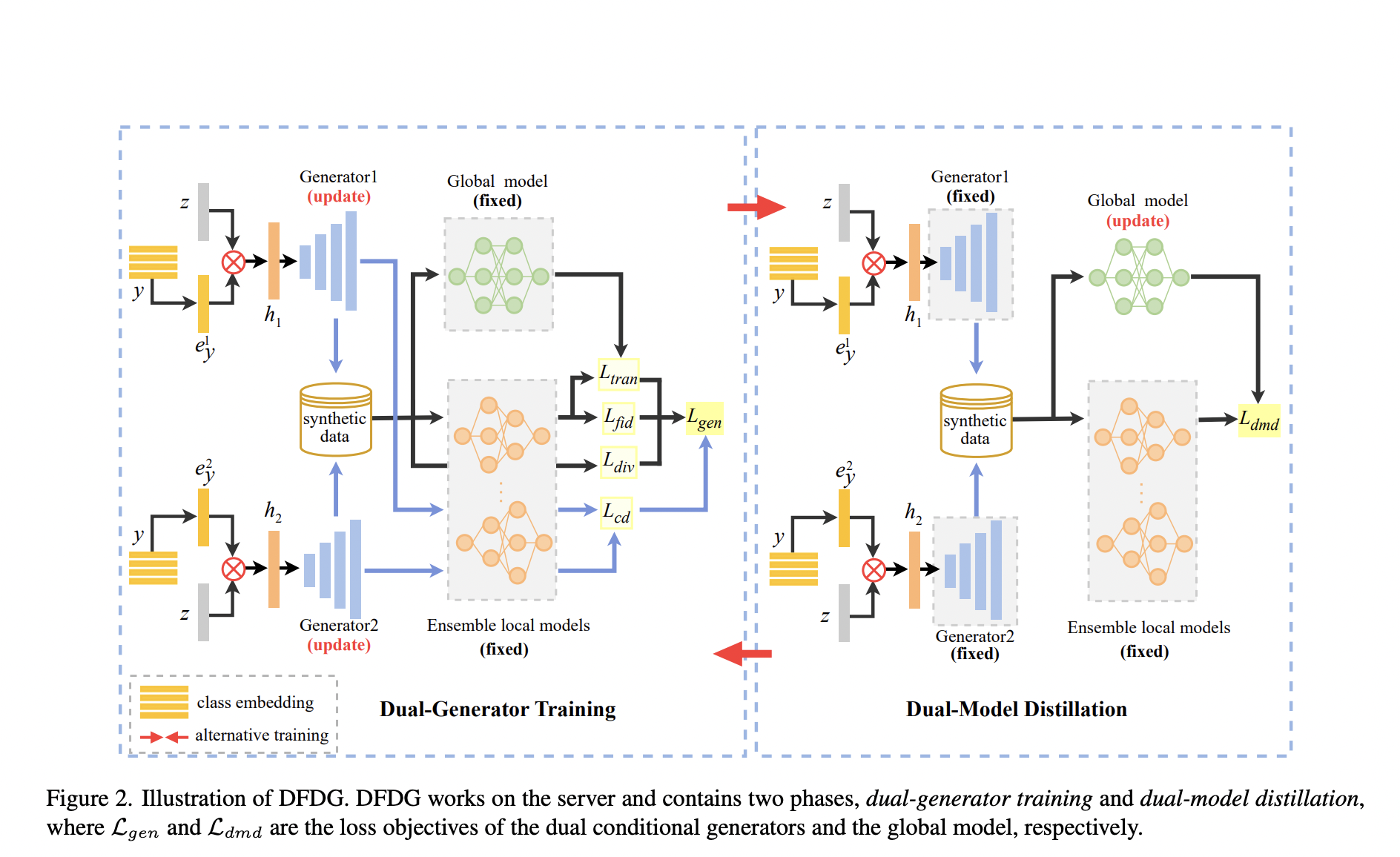

DFDG представляет собой новый метод одношагового федеративного обучения без данных, использующий двойные генераторы для исследования более широкого пространства обучения для локальных моделей. Метод работает в адверсариальной среде с обучением двойных генераторов и этапами дистилляции двойных моделей. Он акцентирует на точности, передаваемости и разнообразии генераторов, вводя функцию потерь перекрестной дивергенции для минимизации перекрытия вывода генераторов. Фаза дистилляции двойных моделей использует синтетические данные от обученных генераторов для обновления глобальной модели.

Вывод: DFDG представляет собой инновационный метод одношагового федеративного обучения без данных, который позволяет исследовать более широкое пространство обучения для локальных моделей. Метод успешно решает проблемы конфиденциальности данных и коммуникаций, улучшая производительность модели через инновационные методы обучения и дистилляции генераторов.