«`html

Lamini AI’s Memory Tuning Achieves 95% Accuracy and Reduces Hallucinations by 90% in Large Language Models

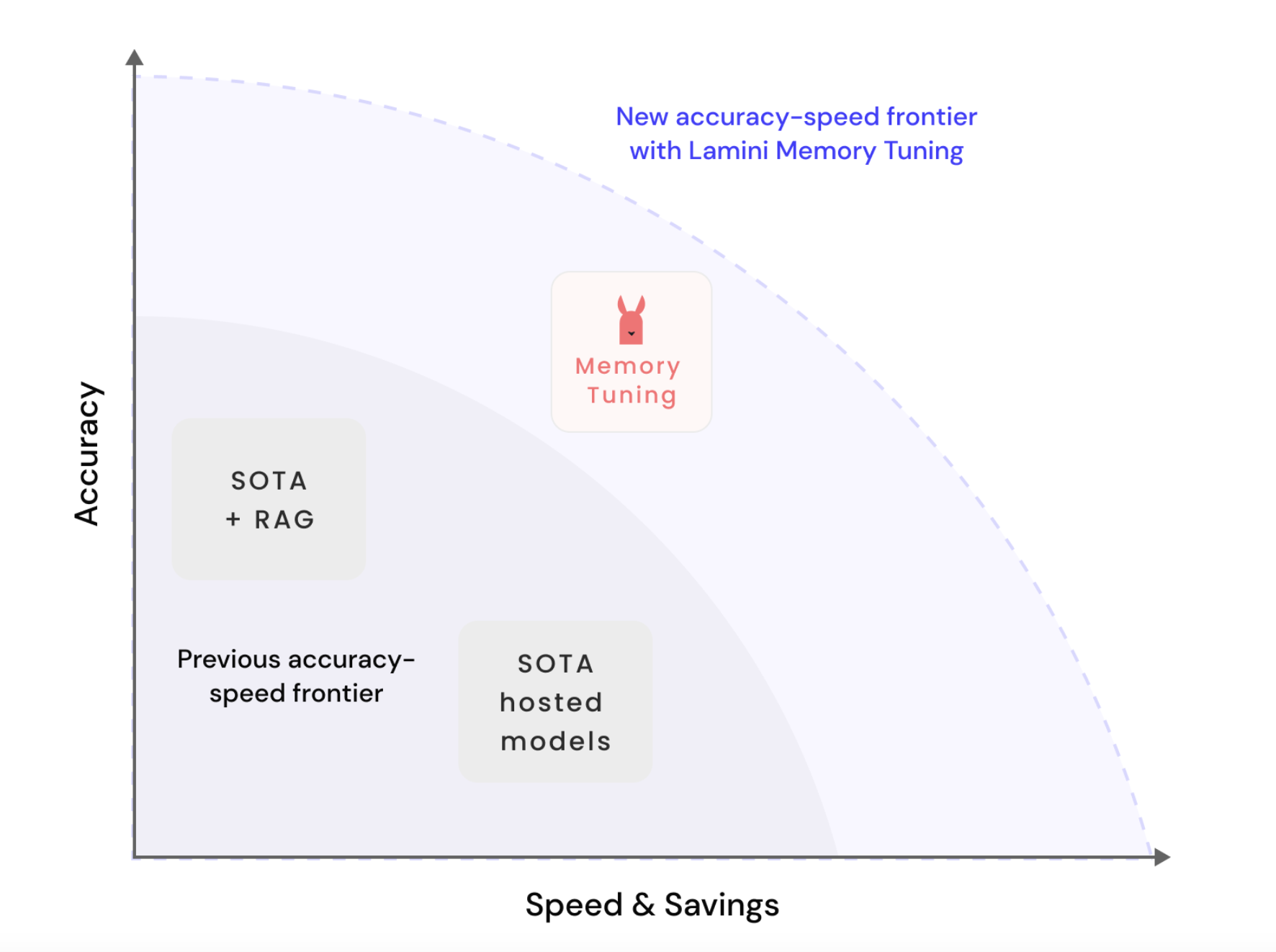

Lamini AI представила революционный прорыв в области больших языковых моделей (LLM) с выпуском Lamini Memory Tuning. Эта инновационная техника значительно повышает фактическую точность и снижает галлюцинации в LLM, значительно улучшая существующие методики. Метод уже продемонстрировал впечатляющие результаты, достигнув 95% точности по сравнению с обычно видимыми 50% при других подходах и снизив галлюцинации с 50% до всего 5%.

Техническая статья

Lamini Memory Tuning решает фундаментальный парадокс в области искусственного интеллекта: как обеспечить точность фактов, сохраняя обобщающие способности, делающие LLM универсальными и ценными. Этот метод включает настройку миллионов экспертных адаптеров (таких как Low-Rank Adapters или LoRA) с точными фактами поверх любой открытой LLM, такой как Llama 3 или Mistral 3. Техника встраивает факты в модель для извлечения только наиболее актуальной информации во время вывода, значительно снижая задержку и затраты, сохраняя при этом высокую точность и скорость.

Источник изображения

Необходимость точной настройки памяти возникает из врожденной конструкции общецелевых LLM, которые обучены уменьшать среднюю ошибку на широком спектре примеров. Это делает их компетентными во многих задачах, но не идеальными в ни одной, часто приводя к смутным конкретным фактам, таким как даты или доходы. Однако Lamini Memory Tuning оптимизирует нулевую ошибку на конкретных фактах, позволяя модели вспоминать эти факты практически идеально, не жертвуя ее обобщающими способностями.

Источник изображения

Заметной историей успеха является компания из списка Fortune 500, которая использовала Lamini Memory Tuning, чтобы достичь 95% точности в критических приложениях, в то время как предыдущие передовые подходы достигали только 50%. Этот уровень точности особенно важен для приложений, требующих точного воспоминания фактов, таких как преобразование вопросов на естественном языке в запросы к базе данных SQL, где точность имеет первостепенное значение.

Источник изображения

Традиционные методы, такие как Prompting и Retrieval-Augmented Generation (RAG), имеют свое место в улучшении точности LLM, но часто не устраняют галлюцинации. Эти методы увеличивают вероятность правильного ответа, но все еще нужно устранить почти правильные, но неправильные ответы. Lamini Memory Tuning преодолевает это, объединяя методы извлечения информации с ИИ, учащим модель, что почти правильный ответ фактически так же неправильный, как совершенно неправильный.

Источник изображения

Инновационный подход Lamini Memory Tuning заключается в создании массовой смеси экспертов по памяти (MoME), подобных специализированным индексам в системах извлечения информации. Эти эксперты настраиваются на воспоминание конкретных фактов с высокой достоверностью и динамически выбираются во время вывода. Этот метод сохраняет способность модели генерировать свободный текст и обеспечивает практически идеальное воспоминание критических фактов. Результатом является модель с редко активированными параметрами, способная масштабироваться до многих параметров, сохраняя низкие затраты на вывод, тем самым расширяя практические применения LLM в области, ранее затрудненные галлюцинациями.

В заключение, внедрение Lamini Memory Tuning представляет собой новый фронт в разработке и применении LLM. Оно обещает более высокую точность, меньшие затраты и более быстрые циклы разработки, обеспечивая более широкое принятие и внедрение в различных отраслях. Поскольку Lamini AI продолжает совершенствовать эту технологию, потенциал полностью автоматизированных, высокоточных решений, основанных на ИИ, становится все более реальным.

«`