Оптимизация высокопроизводительного вывода с долгим контекстом с помощью спекулятивного декодирования: улучшение производительности модели с помощью MagicDec и Adaptive Sequoia Trees

Спекулятивное декодирование становится важной стратегией для улучшения вывода с длинным контекстом, особенно по мере роста потребности в выводе с использованием больших языковых моделей (LLM) в различных приложениях. Исследование Together AI по спекулятивному декодированию решает проблему увеличения производительности вывода для LLM, работающих с длинными входными последовательностями и большими размерами пакетов. Это исследование предоставляет важные идеи для преодоления узких мест памяти во время вывода, особенно при работе с длинными контекстами.

Контекст и вызовы в выводе с длинным контекстом

При увеличении использования LLM модели сталкиваются с задачей обработки более обширных контекстов. Приложения, такие как извлечение информации из больших наборов документов, генерация синтетических данных для настройки, продолжительные разговоры с пользователем и рабочие процессы агентов, требуют обработки последовательностей, охватывающих тысячи токенов. Это требование высокопроизводительной обработки при длинных контекстах представляет техническую сложность, в основном из-за обширных требований к памяти для хранения кэшей ключ-значение (KV). Эти кэши необходимы для обеспечения эффективного воспоминания моделью более ранних частей длинных входных последовательностей.

Ключевые инновации: MagicDec и Adaptive Sequoia Trees

Together AI представляет два важных алгоритмических преимущества в спекулятивном декодировании: MagicDec и Adaptive Sequoia Trees, разработанные для увеличения производительности при длинных контекстах и больших размерах пакетов.

1. MagicDec: Основное узкое место при декодировании с длинным контекстом и большими пакетами — это загрузка кэша KV. MagicDec решает эту проблему, используя фиксированное окно контекста в черновой модели, что позволяет черновой модели работать быстрее, чем целевая модель. Фиксация размера окна контекста делает кэш KV черновой модели значительно меньше, чем у целевой модели, что ускоряет спекулятивный процесс. Интересно, что такой подход также позволяет использовать очень большую и мощную черновую модель. Использование полной целевой модели в качестве черновой становится возможным в этом режиме, потому что узкое место больше не загружает параметры модели.

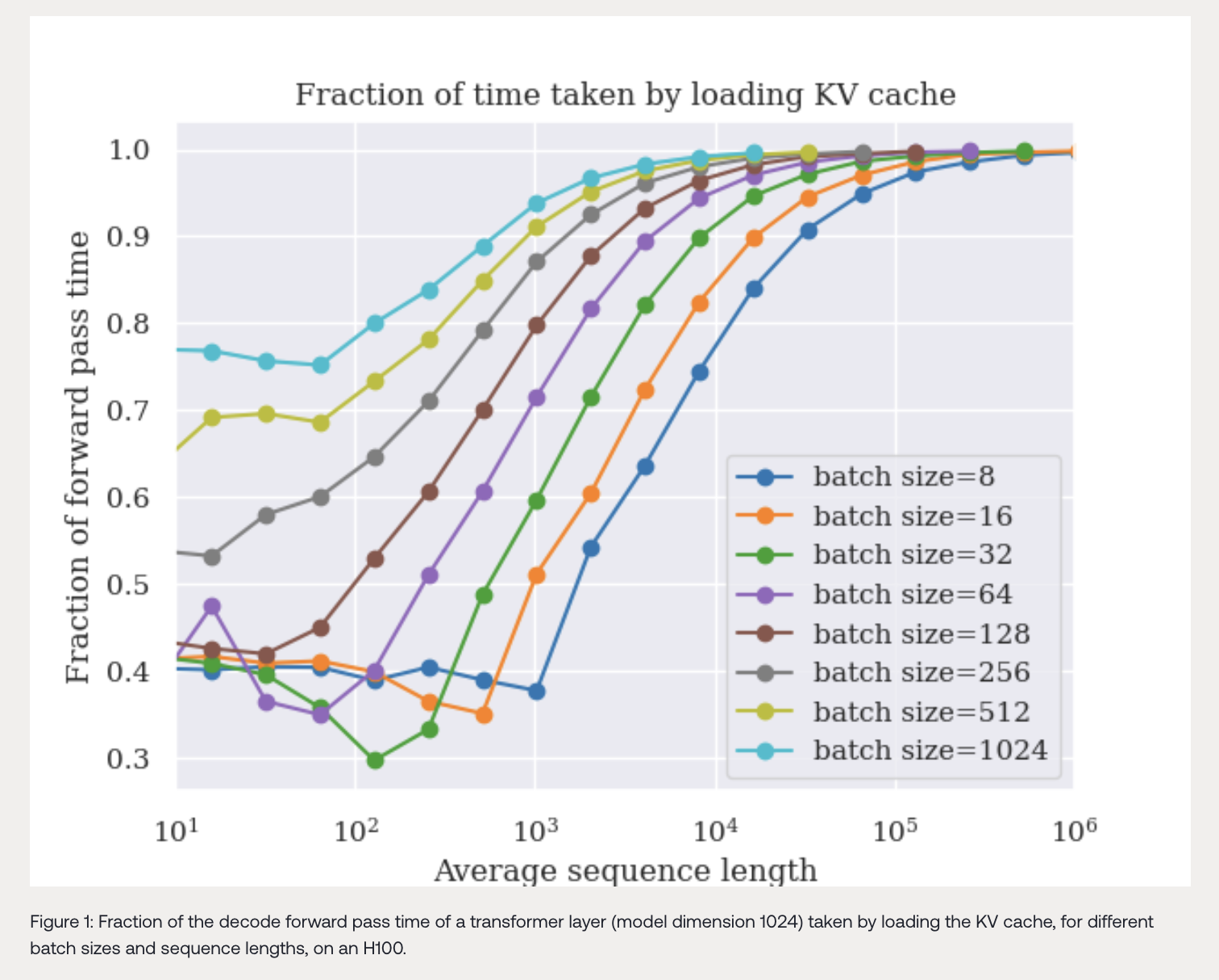

2. Adaptive Sequoia Trees: Другое важное открытие из исследования Together AI заключается в том, что длина входных последовательностей влияет на то, насколько узким становится процесс декодирования. Другими словами, чем длиннее последовательность, тем больше процесс декодирования зависит от загрузки и поддержания кэша KV. Adaptive Sequoia Trees адаптируются к этой ситуации, выбирая количество спекулируемых токенов в зависимости от длины последовательности. Основной принцип заключается в том, что при длинных последовательностях следует спекулировать больше токенов для максимизации производительности.

Компромиссы между памятью и вычислениями в спекулятивном декодировании

Одной из основных проблем, с которой сталкивается Together AI, является понимание баланса между требованиями к памяти и вычислениям во время декодирования. Декодирование включает два типа операций: операции, связанные с параметрами модели, и операции, связанные с кэшем KV. При увеличении длины последовательностей операции, связанные с кэшем KV, становятся доминирующим фактором в потреблении памяти, и, следовательно, декодирование становится память-ориентированным.

Эмпирические результаты

Исследователи подтверждают свои теоретические модели через эмпирический анализ, показывая, что спекулятивное декодирование может существенно улучшить производительность. Например, их результаты показывают, что при определенных условиях спекулятивное декодирование может достичь ускорения до 2 раз для моделей, таких как LLaMA-2-7B-32K, и ускорения до 1,84 раз для LLaMA-3.1-8B, обе на 8 A100 GPU. Эти результаты значительны, потому что они показывают, что спекулятивное декодирование может быть очень эффективным, даже в масштабе, где большие размеры пакетов и длинные последовательности обычно замедляют вывод и увеличивают потребление памяти.

Исследователи показывают, что, вопреки интуитивным представлениям, большие размеры пакетов делают спекулятивное декодирование более эффективным. По мере увеличения размеров пакетов соотношение стоимости черновой к целевой модели уменьшается, что означает, что вычислительная стоимость спекулятивного декодирования становится относительно ниже по сравнению с стоимостью проверки сгенерированных токенов. Это открытие открывает новые возможности для использования спекулятивных техник в масштабных развертываниях LLM с высокой производительностью.

Заключение

Исследование Together AI по спекулятивному декодированию для вывода с длинным контекстом и высокой производительностью переосмысливает понимание того, как LLM можно оптимизировать для реальных масштабных приложений. Сосредотачиваясь на узких местах памяти, а не только на вычислительных ограничениях, данная работа демонстрирует, что спекулятивное декодирование может значительно улучшить производительность модели и снизить задержку, особенно для приложений, включающих длинные входные последовательности. С инновациями, такими как MagicDec и Adaptive Sequoia Trees, спекулятивное декодирование готово стать ключевой техникой для улучшения производительности LLM в сценариях с длинным контекстом. Это важно для будущих приложений, основанных на ИИ, которые зависят от вывода в масштабе.