«`html

Мультимодальное машинное обучение: практические решения и ценность

Мультимодальное машинное обучение – это передовое исследовательское направление, объединяющее различные типы данных, такие как текст, изображения и звук, для создания более полных и точных моделей. Интеграция различных модальностей позволяет моделям лучше понимать и решать сложные задачи, что приводит к улучшению производительности в таких областях, как распознавание изображений, обработка естественного языка, анализ видео и другие.

Проблема и практическое решение

Основная проблема в мультимодальном машинном обучении заключается в неэффективности и негибкости больших мультимодальных моделей (LMMs) при работе с высокоразрешенными изображениями и видео. Традиционные LMMs, такие как LLaVA, используют фиксированное количество визуальных токенов для представления изображения, что часто приводит к избыточному количеству токенов для плотного визуального контента. Это увеличивает вычислительные затраты и ухудшает производительность, перегружая модель излишней информацией. В результате необходимы методы, способные динамически адаптировать количество токенов в зависимости от сложности визуального входа.

Существующие решения этой проблемы, такие как обрезка и объединение токенов, пытаются уменьшить количество визуальных токенов, поступающих в языковую модель. Однако эти методы обычно генерируют фиксированную длину вывода для каждого изображения, что не позволяет гибко балансировать плотность информации и эффективность. Они должны адаптироваться к различным уровням визуальной сложности, что может быть критично в приложениях, где визуальный контент значительно варьируется от кадра к кадру.

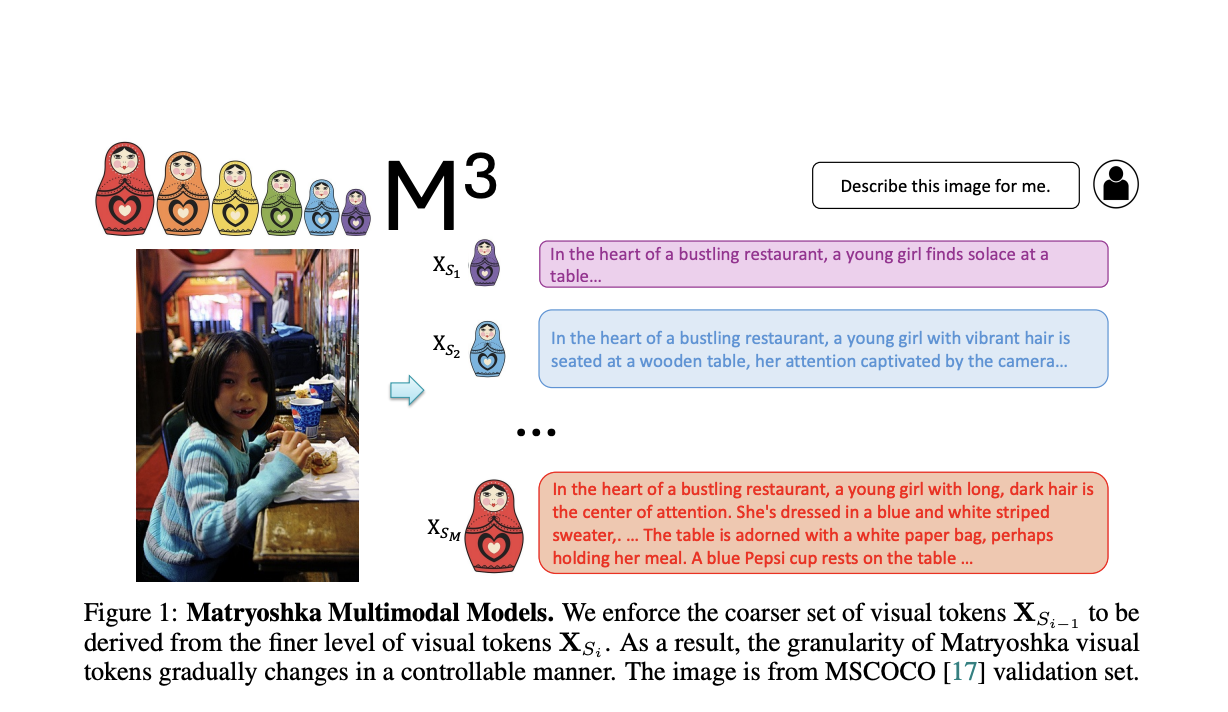

Университет Висконсина-Мэдисон и исследователи Microsoft Research представили модель Matryoshka Multimodal Models (M3). Вдохновленная концепцией матрешек, M3 представляет визуальный контент в виде вложенных наборов визуальных токенов, охватывающих информацию на нескольких уровнях детализации. Такой подход позволяет явно контролировать визуальную детализацию во время вывода, обеспечивая адаптацию количества токенов в зависимости от предполагаемой сложности или простоты контента.

Модель M3 достигает этого путем кодирования изображений в несколько наборов визуальных токенов с увеличением уровней детализации, от грубой к более подробной. В процессе обучения модель учится получать более грубые токены из более подробных, обеспечивая эффективное охватывание визуальной информации. В частности, модель использует масштабы, такие как 1, 9, 36, 144 и 576 токенов, причем каждый уровень обеспечивает постепенно более детальное представление визуального контента. Эта иерархическая структура позволяет модели сохранять пространственную информацию, адаптируя уровень детализации в соответствии с конкретными требованиями.

Экспертиза модели M3 подтверждает ее значительные преимущества. На бенчмарках в стиле COCO модель достигла точности, сопоставимой с использованием всех 576 токенов, но лишь с использованием примерно 9 токенов на изображение. Это представляет собой существенное улучшение эффективности без ущерба точности. Модель M3 также успешно прошла другие тесты, показав, что она может поддерживать высокую производительность даже при резком сокращении количества токенов. Например, точность модели с 9 токенами была сопоставима с Qwen-VL-Chat с 256 токенами, и в некоторых случаях она достигала аналогичной производительности всего с 1 токеном.

Модель может адаптироваться к различным вычислительным и памятным ограничениям во время внедрения, обеспечивая гибкий контроль над количеством визуальных токенов. Эта гибкость особенно ценна в реальных приложениях, где ресурсы могут быть ограничены. Подход M3 также предоставляет рамки для оценки визуальной сложности наборов данных, помогая исследователям понять оптимальную детализацию, необходимую для различных задач. Например, в то время как естественные сценарии, подобные COCO, могут быть обработаны с использованием примерно 9 токенов, плотные задачи визуального восприятия, такие как понимание документов или OCR, требуют большего количества токенов, от 144 до 576.

В заключение, Matryoshka Multimodal Models (M3) решает проблемы текущих LMMs и предоставляет гибкий, адаптивный метод представления визуального контента, создавая условия для более эффективных мультимодальных систем. Способность модели динамически адаптировать количество визуальных токенов в зависимости от сложности контента обеспечивает лучший баланс между производительностью и вычислительными затратами. Этот инновационный подход улучшает способности мультимодальных моделей в понимании и рассуждении, открывая новые возможности для их применения в различных и ресурсо-ограниченных средах.

«`