«`html

Phind представляет Phind-405B: флагманскую модель ИИ, повышающую эффективность технических задач, и мгновенную Phind для превосходной производительности поиска.

Phind официально объявил о выпуске своей новой флагманской модели, Phind-405B, а также инновационной модели Phind Instant, направленной на революционизацию поиска и программирования, работающих на базе ИИ. Эти новшества являются вехой в технических возможностях, предоставляя разработчикам и техническим пользователям более эффективные и мощные инструменты для решения сложных задач.

Введение Phind-405B

Phind-405B является угловым камнем последнего релиза, отмечая значительный прогресс в развитии Phind. Построенная на Meta Llama 3.1 405B, Phind-405B разработана для превосходства в программировании и технических задачах. Способная обрабатывать до 128 тыс. токенов контекста, включая 32-тысячное окно контекста, доступное при запуске, эта модель предназначена для решения технически сложных задач. Phind-405B теперь доступна для всех пользователей Phind Pro, предоставляя им немедленный доступ к ее передовым возможностям.

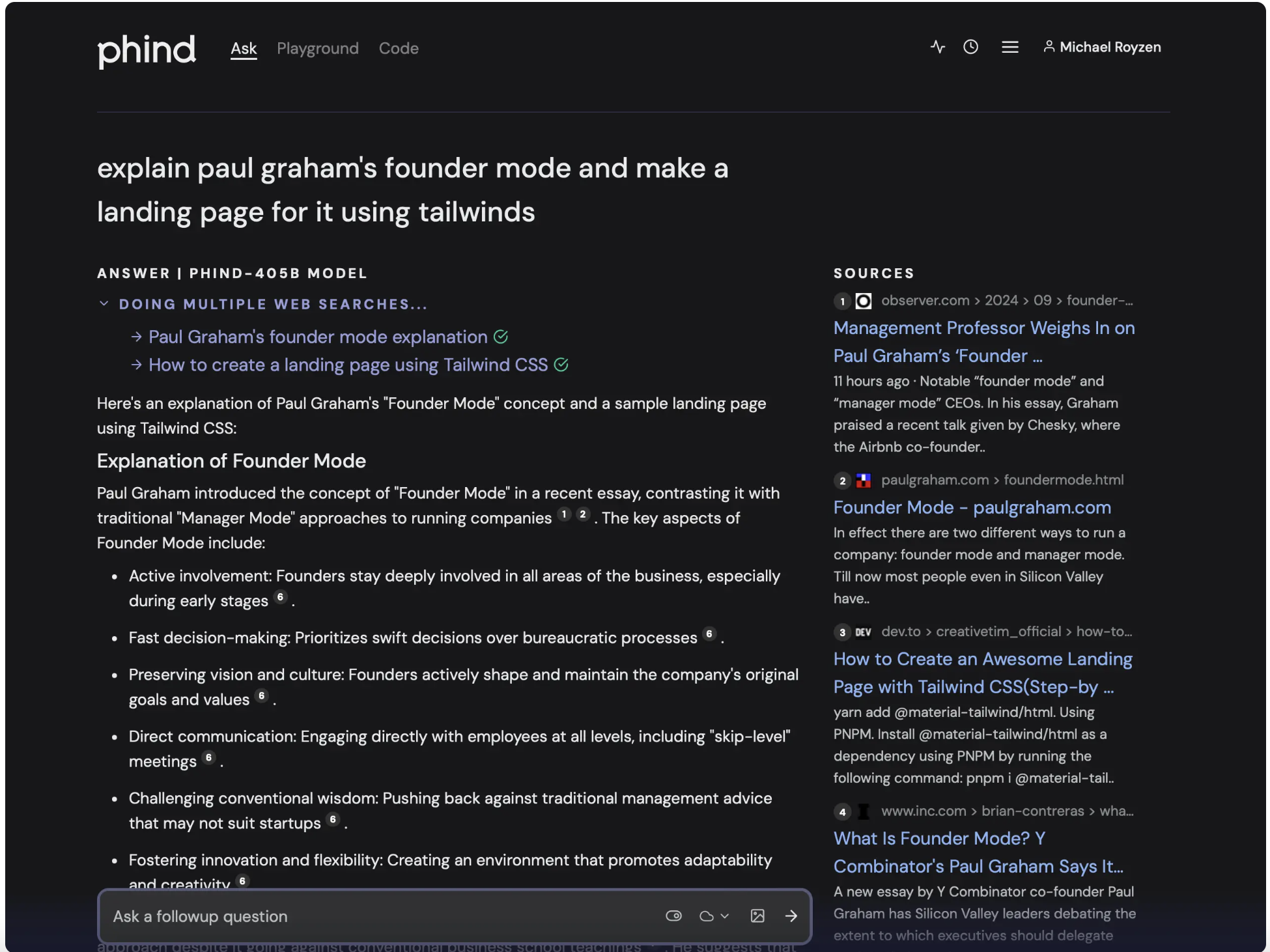

Одной из самых впечатляющих особенностей модели является ее производительность в реальных задачах, особенно в разработке веб-приложений. В чрезвычайном примере, при создании посадочной страницы для «Founder Mode» Пола Грэма, Phind-405B использовала несколько поисков и представила ряд вариантов дизайна. Ее возможности превышают базовое программирование; она предлагает решения, объединяющие творчество и эффективность.

Phind-405B также соответствует производительности модели Claude 3.5 Sonnet по метрике HumanEval 0-shot, обладая удивительной точностью в 92%. Это одна из лучших моделей для задач, требующих точности и технической экспертизы. Phind обучила эту модель на 256 H100 GPU с использованием FP8 смешанной точности, что гарантирует ее производительность без ущерба для качества и снижение использования памяти на 40%. Эффективность этого уровня позволяет модели работать более плавно и быстро, сохраняя при этом высокие стандарты, ожидаемые в технических средах.

Phind Instant: скачок в скорости поиска

С выпуском Phind-405B, Phind также представила Phind Instant – модель, предназначенную для борьбы с общей проблемой задержки при использовании AI-поиска. В отличие от традиционных поисковых систем, таких как Google, поисковые запросы, управляемые ИИ, часто страдают от задержек, несмотря на доставку более высококачественных ответов. Phind Instant направлена на устранение этого разрыва, предлагая мгновенное время отклика, сохраняя при этом глубину и точность ответов.

Основываясь на Meta Llama 3.1 8B и работая на настраиваемых серверах вывода Phind с использованием NVIDIA TensorRT-LLM, Phind Instant обрабатывает до 350 токенов в секунду. Эти впечатляющие скорости достигаются благодаря FP8 смешанной точности, вспышечному декодированию и сплавлению CUDA-ядер для MLP (многослойного перцептрона). Технические оптимизации Phind Instant позволяют ему быть высокоотзывчивым инструментом, особенно в средах, где быстрое получение точной информации критично.

Введение Phind Instant подчеркивает обязательства компании по улучшению пользовательского опыта в реальных сценариях поиска в реальном времени. Архитектура и реализация модели демонстрируют внимание Phind к деталям в оптимизации скорости и качества.

Улучшение эффективности поиска

Вместе с выпуском этих моделей, Phind также внедрила несколько улучшений в свою поисковую инфраструктуру. Осознавая, что в поиске каждая миллисекунда имеет значение, Phind сократила задержку до 800 миллисекунд на каждый поиск. Это улучшение достигнуто за счет внедрения новой обученной модели, которая предварительно загружает веб-результаты до завершения ввода пользователем. Такой превентивный подход значительно улучшает опыт поиска, особенно когда вовлечены запросы, требующие временной чувствительности или сложные запросы.

Дополнительное улучшение возможностей поиска Phind заключается в запуске новой, более крупной встраивающей модели, в 15 раз большей, чем ее предшественница. Несмотря на увеличение размера модели, задержка уменьшилась благодаря внедрению 16-поточности во время вычисления встраиваний. Эти технические усовершенствования гарантируют, что в модель попадает наиболее актуальная информация, что дополнительно улучшает релевантность и точность результатов поиска.

Широкий взгляд на будущее

Последние разработки Phind сосредоточены на поддержке разработчиков и технологов путем оптимизации и ускорения их рабочих процессов. Представляя Phind-405B и Phind Instant, компания позиционирует себя как лидера в области предоставления инструментов для сложных технических запросов. Что выделяет Phind, так это посвящение решению реальных проблем, а также возможность пользователям исследовать любопытства за пределами технической области. Благодаря мощным инструментам разработчики могут быстрее переходить от идеи к реализации, предоставляя путь для инноваций.

По мере расширения своего портфеля, Phind выражает благодарность своим ключевым партнерам, включая Meta, NVIDIA, Voltage Park, SF Compute и AWS. Эти партнерства подчеркивают совместные усилия, лежащие в основе технических достижений Phind, а также более широкие последствия, которые эти модели имеют для сообществ исследователей в области ИИ и машинного обучения.

В заключение, выпуск Phind-405B и Phind Instant обеспечивает одновременное улучшение скорости и качества в поиске с использованием ИИ и решении технических задач, и Phind закрепляет свою роль в качестве лидера в этой области. Будущее выглядит многообещающе для разработчиков и пользователей, полагающихся на высокопроизводительные модели для своих проектов.

Исходный текст: MarkTechPost

«`

«`html

Phind представляет Phind-405B: флагманскую модель ИИ, повышающую эффективность технических задач, и мгновенную Phind для превосходной производительности поиска.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Phind Presents Phind-405B: Phind’s Flagship AI Model Enhancing Technical Task Efficiency and Lightning-Fast Phind Instant for Superior Search Performance.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram.

Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/ Этот ИИ ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru

«`