Улучшенная параметризация DiNADO для превосходной сходимости и глобальных оптимумов при точной настройке

Большие предварительно обученные генеративные трансформеры продемонстрировали исключительную производительность в различных задачах генерации естественного языка, используя большие наборы данных для захвата логики человеческого языка. Однако адаптация этих моделей для определенных приложений через тонкую настройку представляет существенные трудности. Вычислительная эффективность тонкой настройки сильно зависит от размера модели, что делает ее дорогой для исследователей, работающих над большими моделями. Тонкая настройка на более маленьких наборах данных представляет риск катастрофического забывания, когда модель переобучается на конкретной области задачи и теряет важные знания, полученные во время предварительного обучения. Из-за этой проблемы умения рассуждения, такие как композиционная обобщенность и здравый смысл, сталкиваются с проблемами при оценке модели.

Существующие методы

Существующие методы включают prompt-настройку, которая включает добавление токенов или обучаемых векторов к входу и оптимизацию их вложений. Этот метод позволяет адаптироваться к новым задачам с минимальными данными, уменьшая риск катастрофического забывания. Второй метод — алгоритм NeurAlly-Decomposed Oracles (NADO), который предоставляет золотую середину через более маленькую модель трансформера для управления базовой моделью без изменения ее параметров. Однако возникают вопросы относительно оптимальных практик обучения для значительных распределительных несоответствий и снижения дополнительных затрат, связанных с обучением модуля NADO. Последний метод — алгоритм GeLaTo, инновационная структура для улучшения авторегрессивной генерации текста путем интеграции управляемых вероятностных моделей (TPM).

DiNADO: улучшенная параметризация NADO

Команда исследователей из Университета Калифорнии в Лос-Анджелесе, Amazon AGI и Samsung Research America представили norm-Disentangled NeurAlly-Decomposed Oracles (DiNADO), улучшенную параметризацию алгоритма NADO. Он улучшает сходимость NADO во время наблюдаемой тонкой настройки и поздних этапов, фокусируясь на уникальности глобальных параметрических оптимумов. Неэффективность оценки градиента обрабатывается с использованием NADO с разреженными сигналами от функции управляющего сигнала, показывая, как улучшить эффективность выборки и оценки градиента. Более того, естественное сочетание DiNADO с подходами, такими как LoRA, позволяет обновлять базовую модель через контрастную формулировку и улучшает емкость модуля NADO, улучшая производительность во время вывода.

Оценка DiNADO

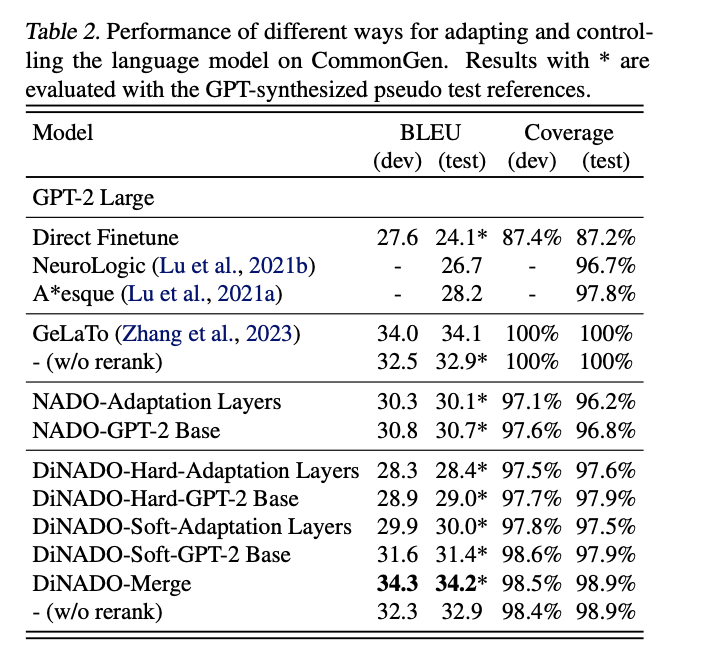

DiNADO оценивается с использованием двух основных задач: формальный машинный перевод (FormalMT) и лексически ограниченная генерация (LCG). Для FormalMT используется формальная ссылка и бинарный классификатор для приближения оценки формальности. Задача LCG использует набор данных CommonGen, который оценивает способности композиционной обобщенности и здравого смысла в моделях генерации текста. Эксперименты разделены на две части:

- Результаты с использованием базового распределения GPT-2-Large, оцененные по качеству генерации и управляемости.

- Исследование эффективности выборки, показывающее, как различные конструкции и техники перевзвешивания целей улучшают эффективность выборки NADO.

Результаты показывают, что DiNADO-Soft превосходит DiNADO-Hard, поскольку строгая прямая согласованность DiNADO-Hard может повлиять на обучение сигнала оракула. Модули NADO большей емкости предлагают улучшенную гибкость и управляемость с DiNADO-Merge, показывая более обобщаемую производительность. Более того, нормативное разделение DiNADO помогает контролировать регуляризацию ниже 0,5, обеспечивая, что обновления в функции R последовательно улучшают составленное распределение. Это в отличие от обычного NADO, где расхождение в регуляризационном члене может повлиять на улучшение производительности, подчеркивая превосходство динамики обучения DiNADO и эффективности в контролируемых задачах генерации текста.

Вывод

Исследователи представили DiNADO, улучшенную параметризацию алгоритма NADO. Одним из основных преимуществ DiNADO является его совместимость с методами тонкой настройки, такими как LoRA, позволяющая вариант NADO с богатой емкостью. Более того, исследователи провели теоретический анализ недостатков реализации обычного NADO и предложили конкретные решения. Эта статья вносит ценные идеи и улучшения в область управляемой генерации языка, потенциально открывая новые пути для более эффективных приложений генерации текста.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте следить за нами в Twitter и LinkedIn. Присоединяйтесь к нашему Telegram-каналу. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу на SubReddit

Попробуйте ИИ ассистент в продажах здесь. Этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru