«`html

Обеспечение безопасности и этического поведения в больших языковых моделях (LLM)

Гарантировать безопасность и этическое поведение LLM при ответе на запросы пользователей — это важно. Проблемы возникают из-за того, что LLM предназначены для генерации текста на основе ввода пользователя, что иногда может привести к вредному или оскорбительному контенту. Этот документ исследует механизмы, с помощью которых LLM отказываются генерировать определенные типы контента, и разрабатывает методы улучшения их способности отказывать.

Техника ортогонализации весов

Техника ортогонализации весов является более простым и эффективным методом, чем существующие методы, поскольку она не требует оптимизации на основе градиентов или набора вредных завершений. Она включает в себя коррекцию весов в модели таким образом, чтобы направление, связанное с отказом, было ортогонализировано, предотвращая модели следовать указаниям отказа, сохраняя при этом ее исходные возможности.

Оценка производительности

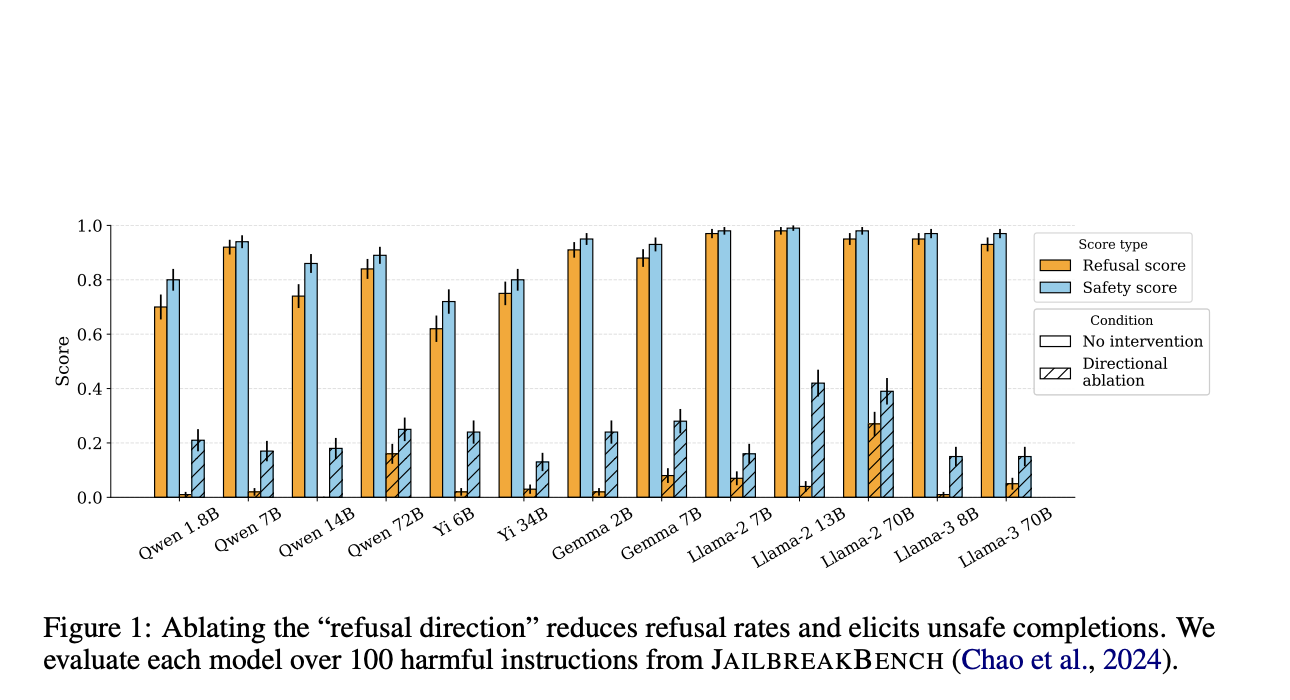

Эксперименты с этим методом, проведенные с использованием тестового набора HARMBENCH, показывают обнадеживающие результаты. Метод демонстрирует высокую степень успешности атаки (ASR) на различных моделях, включая семейства LLAMA-2 и QWEN, даже когда системные запросы разработаны для обеспечения безопасности и этических принципов.

Этические соображения

Предложенный метод значительно упрощает процесс обхода защиты LLM, но также вызывает важные этические вопросы. Работа подчеркивает хрупкость текущих механизмов безопасности и призывает к научному согласию относительно ограничений этих техник для информирования будущих решений в области политики и исследований.

Это исследование выявляет критическую уязвимость в механизмах безопасности LLM и представляет эффективный метод для эксплуатации этой слабости. Работа не только продвигает понимание уязвимостей LLM, но также подчеркивает необходимость надежных и эффективных механизмов безопасности для предотвращения злоупотреблений.

«`